0 引 言

我国是煤炭生产大国,虽然原煤总产量占能源总产量的百分比呈逐年下降趋势,但是在很长的一段时间内,我国以煤为主的能源结构依然难以改变,煤炭在国家能源战略中的地位依然不可动摇[1]。随着我国煤炭工业的快速发展,采掘作业的规模越来越大,与此同时,我国的煤矿事故发生率也非常频繁。根据国家安全生产监督管理局的统计数据显示,2001—2018年,我国共发生煤矿重大事故495起[2],其中,2018年煤矿百万吨死亡率为0.093[3]。虽然煤矿事故数量和煤矿每百万吨死亡率在逐年下降,煤矿安全开采的形势得到了一定好转,但同世界先进采煤国家相比, 我国煤炭开采业的风险系数依然很高[4-5]。煤矿事故发生后,必须在第一时间了解煤矿的环境信息,并进入到事故现场展开救援工作,然而,煤矿现场存在着诸如瓦斯、污水、煤尘等危险和其他难以预测的次生灾害。考虑到救援人员的生命安全,必须在施加多种防护措施的条件下,救援人员才能进入到事故现场展开搜救工作。一般来说,事故后最初的几个小时是黄金时间,特别是对于受伤严重的被困人员,第1个小时至关重要。在第1个24 h之后,被困人员的存活率开始下降[6]。因此,研发能够代替救援人员在第一时间进入到事故现场,及时地开展环境探测和生命救援任务的煤矿救援机器人至关重要。

建设智慧煤矿是煤炭工业发展的必然选择,符合“中国制造2025”国家战略[7-8]。2019年,国家应急管理部发布“煤矿机器人重点研发产品目录”,旨在加快各类煤矿机器人的研发工作[9]。煤矿救援机器人是煤矿机器人的重要组成部分,其应该具备自感知、自运动、自决策和自学习能力[4]。其中,自感知是机器人进行路径规划和自主决策的基础。在机器人的感知行为中,视觉感知至关重要。视觉提供了环境的绝大部分信息[10]。在机器人视觉领域,双目视觉有着非接触性和被动性的优势,所以被广泛应用于机器人自主避障和三维重建。虽然双目视觉技术已经初步地应用到了救援机器人感知系统中,然而,在煤矿的非结构化环境中,机器人双目视觉技术的应用水平还亟待提高,特别是在摄像机标定精度,立体视觉匹配效果,三维重建精度和实时性等方面。随着机器人技术和双目视觉技术的日趋成熟,基于双目视觉技术的煤矿救援机器人成为了煤矿安全领域的研究热点。笔者介绍了双目视觉技术的基本原理,总结了摄像机标定方法和立体视觉匹配算法的研究进展,分析了近年来双目视觉在煤矿救援机器人中的应用情况和存在的技术难题,并指出了未来的发展趋势。

1 机器人双目视觉关键技术

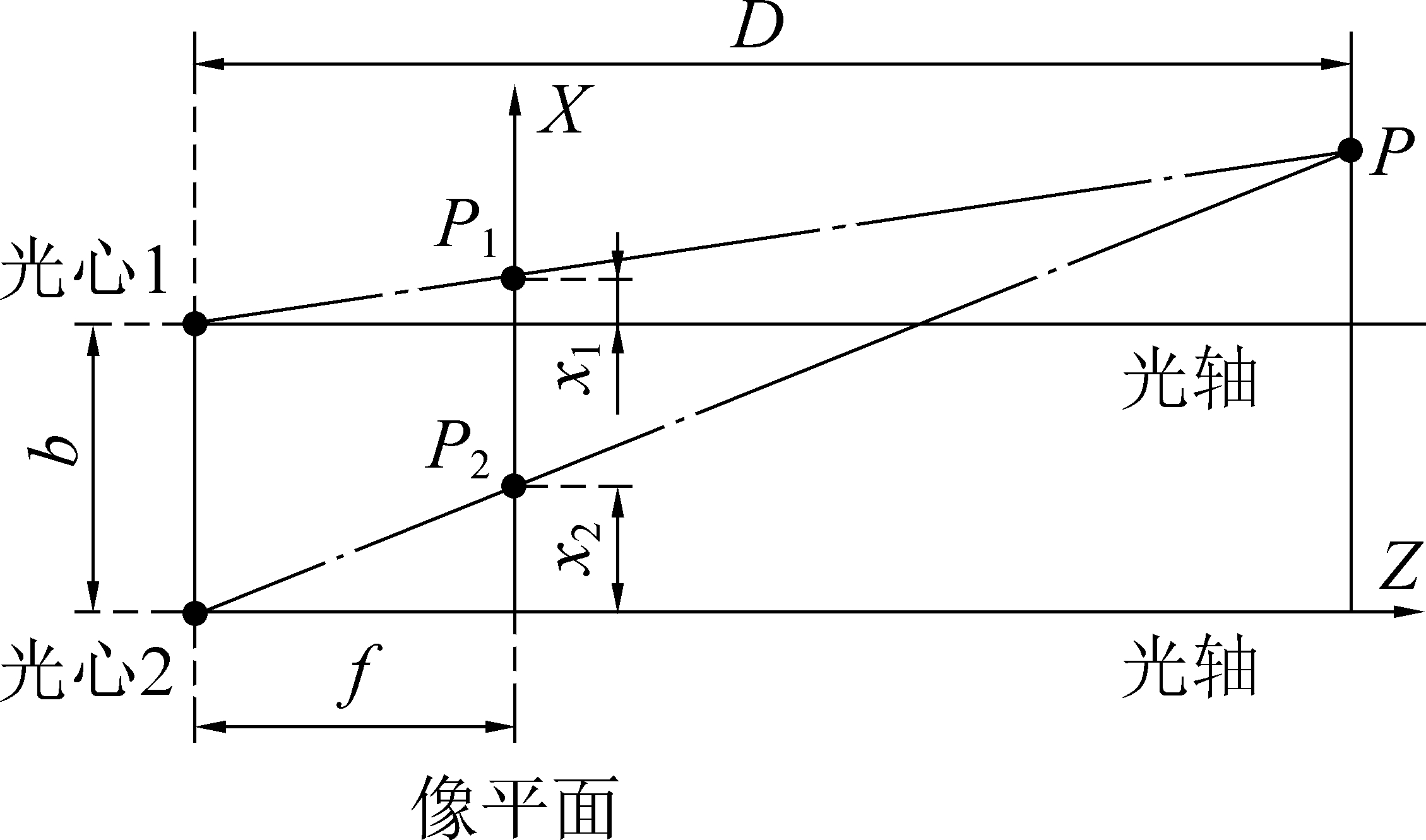

在煤矿事故现场,煤矿救援机器人通过双目视觉获取障碍物信息,并完成环境的3维重建。双目视觉主要是通过2个摄像头从不同角度产生的视差来获取被测物体的三维空间信息[11]。机器人双目视觉获取目标物深度是依靠三角测距原理,如图1中双点划线三角形所示。根据三角形相似原理,深度D[12]可表示为

图1 双目测距原理

Fig.1 Principle of binocular ranging

(1)

d=x1-x2

(2)

式中:f为摄像机的焦距;b为2个摄像机之间的基线长度;d为双目视差;x1、x2分别为目标点P对应于摄像机1和摄像机2在像平面上的横坐标。

双目视觉的实现流程需要经历5个步骤,即:①图像对采集;②摄像机标定;③畸变矫正;④立体视觉匹配:⑤三维重建。由式(1)可知,计算深度D的前提是预先获取焦距f、基线长度b和视差d。焦距和基线长度可以通过摄像机标定获取,视差可以通过立体视觉匹配得到。所以,摄像机标定和立体视觉匹配是双目视觉的关键技术,其标定精度和匹配效果对三维重建有着决定性的影响。

1.1 摄像机标定

摄像机标定是指利用特定目标或场景的特征来获得摄像机的内外参数,从而实现立体空间到平面图像的映射[13]。标定过程中涉及到4个坐标系之间的转换,即摄像机坐标系Oc,像平面坐标系Oi,像素坐标系Op和世界坐标系Ow,它们的关系如图2所示。

图2 4个坐标系的位置

Fig.2 Positions of four coordinate systems

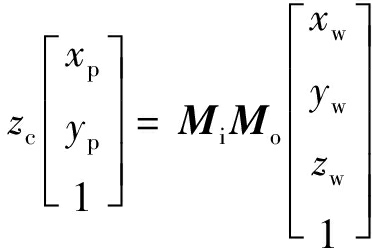

三维空间点P在空间坐标系中的坐标(xw,yw,zw)与其在相平面上的投影点坐标(xp,yp)的映射关系为[14-16]

(3)

其中:Mi为摄像机内参数矩阵;Mo为摄像机外参数矩阵。式(3)是基于线性模型给出的函数关系,而在实际的摄像机标定过程中,摄像机会发生径向畸变,离心畸变和薄棱镜畸变[17],所以还需要进行畸变矫正。

摄像机标定方法分为传统标定方法,主动视觉标定方法和自标定方法。传统标定方法是将形状和尺寸已知的参照物作为摄像机的拍摄目标, 然后经图像处理和数学变换后,即可求得摄像机参数。例如张正友标定法[18]、直接线性变换法[19-20]、两步标定法[21]等。主动视觉标定方法是通过精确地控制摄像机工作台的运动,摄像机可以获取多幅不同角度的图像,然后利用摄像机运动参数和被摄图像之间的约束关系,即可求得摄相机参数。例如基于纯平移的标定法[22]、基于纯旋转的标定法[23]等。自标定方法是在场景信息未知的条件下,仅依靠图像序列中获得的约束关系,即可获得摄像机参数。例如基于射影重建的自标定法[24]、分层逐步自标定法[25]等。

1.2 立体视觉匹配

立体视觉匹配以匹配算法为基础,目的在于搜寻三维空间中目标物上的某一点在被摄图像上的对应点。SCHARSTEIN等[26]系统地总结了立体视觉匹配的4个步骤,即:①匹配代价计算;②代价聚合;③视差计算;④视差优化。大部分的立体视觉匹配算法都需要经历这4个步骤。

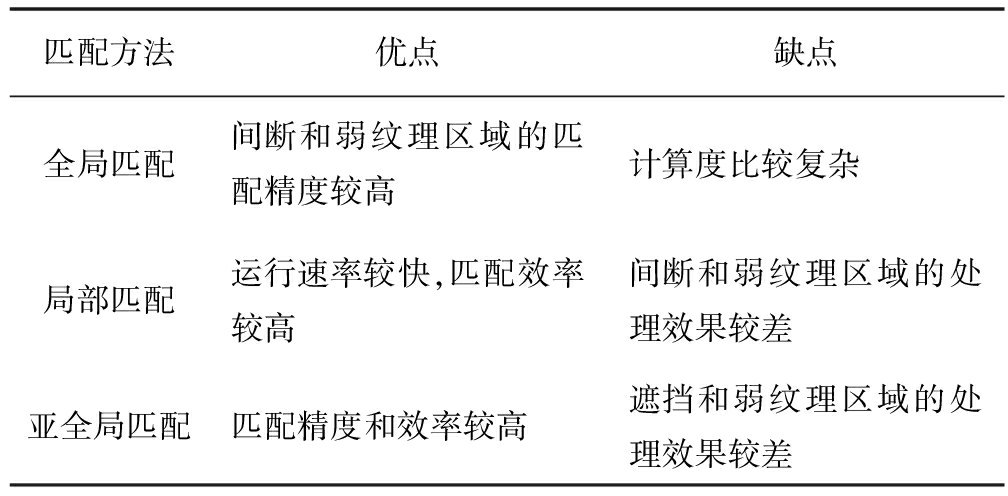

目前常用的匹配算法分为全局匹配算法,局部匹配算法和亚全局匹配算法3类。全局匹配算法全面考虑了整个待匹配区域的信息,通过建立并求解全局能量函数,进而计算视差。例如基于图像分割的算法[27]、基于置信度的算法[28]、基于动态规划的算法[29]等。目前,基于深度学习和仿生的智能算法成为了研究的热点。SHELHAMER等[30]提出了一种基于全卷积网络的图像分割算法,该算法完成了图像的像素级分类,解决了语义级别的图像分割问题。MAHATO等[31]提出了一种基于遗传算法的立体匹配方法,该方法有效地解决了稠密立体图像的匹配问题。

局部匹配算法依靠局部窗口的约束信息,通过比较局部特征进行匹配。例如基于区域的算法[32]、基于特征的算法[33]、基于相位的算法等。目前,许多研究人员提出了很多改善的局部匹配算法。EMLEK等[34]使用引导滤波器进行代价聚合,并采用交叉窗口策略矫正了视图差异,既提高了效率,又降低了匹配误差。YANG等[35]提出了一种基于动态场景的局部匹配算法。该算法将代价滤波器与运动信息相结合,获得了效果较好的深度图。

亚全局匹配算法的性能介于全局匹配算法和局部匹配算法之间。HIRSCHMÜLLER[36]首先提出了亚全局匹配算法。传统的亚全局匹配算法通常在像素级别上计算匹配代价,并在假设相邻像素具有相似视差的情况下将其聚合,这个过程需要很大的存储空间,为了解决这个问题,LEE等[37]提出了基于记忆效率的亚全局匹配方法。该方法将匹配代价作为一个高斯混合模型函数,大量的匹配代价通过一组高斯混合模型参数来表示,则基于高斯混合模型的参数聚合过程就取代了传统的代价聚合过程。传统算法需要假设像素具有颜色一致性,但在实际场景中,辐射条件一般不是理想状态。基于这种情况,NI等[38]提出了一种基于倾斜平面迭代优化的亚全局匹配算法。该算法将人口普查、梯度等结合起来作为匹配成本,降低了辐射畸变的影响。3类立体匹配算法的优缺点见表1。

表1 立体匹配算法的优缺点

Table 1 Advantages and disadvantages of stereo matching algorithm

匹配方法优点缺点全局匹配间断和弱纹理区域的匹配精度较高计算度比较复杂局部匹配运行速率较快,匹配效率较高间断和弱纹理区域的处理效果较差亚全局匹配匹配精度和效率较高遮挡和弱纹理区域的处理效果较差

2 双目视觉技术在煤矿救援机器人中的应用和发展

以中国为代表的煤炭生产和消费大国都非常重视矿难救援技术及装备的研发和应用,但目前仍然难以达到紧急救援的需求[39]。研发和应用煤矿救援机器人是实现煤矿智能化的重要途径。在国外,卡内基梅隆大学、美国REMOTEC公司、美国矿山安全与卫生管理局等都较早地对煤矿救援机器人展开了研究[40-41]。在国内,中国矿业大学、北京理工大学、哈尔滨工业大学、西安科技大学和中信重工开诚智能装备有限公司等高校和企业都研制出了多款不同类型的煤矿救援机器人[42-45]。如图3a、图3b所示为CUMT-V(B)型机器人在长沟峪煤矿的现场试验[42],如图3c、图3d所示为MINBOT-I型机器人在塔山煤矿的现场试验[44]。

图3 煤矿现场试验

Fig.3 Field test of coal mine

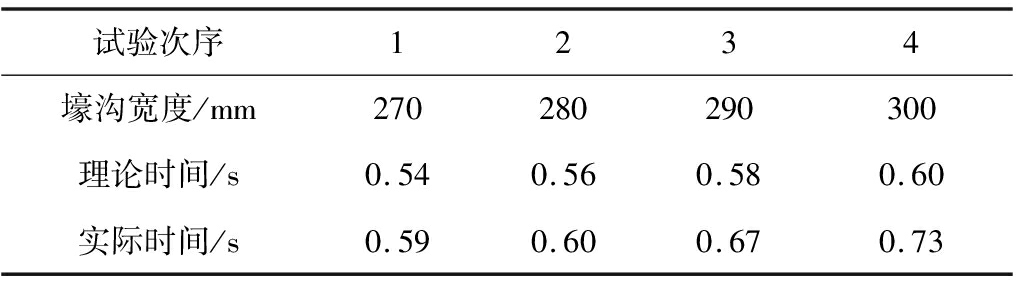

由于煤矿井下环境的特殊性,视觉导航成为了煤矿救援机器人重要的导航策略。例如,王宇等[46]设计了一款基于机器视觉的救援类机器人。该机器人包括视觉系统、轮履转换系统和可变形曲柄系统等。其中,视觉系统主要用于获取障碍物的信息,保障机器人能够以最佳的姿态和运动执行救援任务。机器人跨越壕沟的部分试验数据[46]见表2,其时间误差最大为0.13 s,所以该机器人具有较好的越障性能。

表2 机器人越过壕沟试验数据

Table 2 Test data of robot crossing ditch

试验次序1234壕沟宽度/mm270280290300理论时间/s0.540.560.580.60实际时间/s0.590.600.670.73

近些年以来,关于煤矿救援机器人双目视觉的研究也取得了很多代表性的成果,其研究热点主要集中在立体视觉匹配算法改进、模式分类与识别、视觉测量与三维重建、组合测量与定位、视觉伺服控制和基于虚拟现实技术的视觉算法仿真等方面。

2.1 立体视觉匹配算法的改进

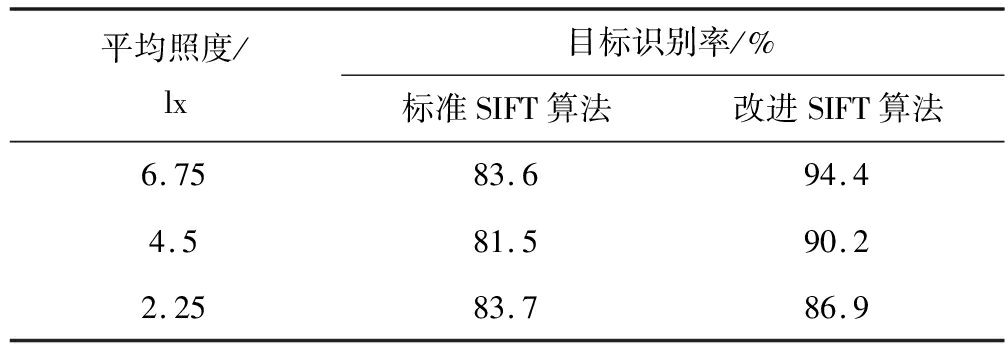

立体视觉匹配是双目视觉技术的关键,其算法性能直接影响着三维重建的速度和质量。考虑到煤矿具有高动态和强干扰的特点,煤矿救援机器人需要使用一种鲁棒,准确和实时的匹配算法来适应复杂的非结构化场景。例如,HE等[47]提出了一种改进的普查算法,并将其用于煤矿救援机器人双目视觉的立体匹配。普查算法属于非参数变换,其基本原理为:先将原始图像对的灰度值转换为具有图像处理特性的数据,生成以二进制码为元素的普查图像对,即普查变换,然后再在普查图像对中进行立体视觉匹配。Middlebury库图像测试表明,该算法在资源占用率,处理速度和精度方面都取得了较好的平衡。巩固等[48]考虑了矿井下的光照条件,提出了一种改进的尺度不变特征转换(SIFT)算法。该算法主要在图像边缘搜索关键点,且使用马氏距离进行二次匹配,减少了计算量。提出的改进SIFT算法和标准SIFT算法的测试结果见表3[48],可以看出,改进的SIFT算法较之标准SIFT算法,其目标识别率更高。

表3 SIFT算法性能比较数据

Table 3 Performance comparison data of SIFT algorithm

平均照度/lx目标识别率/%标准SIFT算法改进SIFT算法6.7583.694.44.581.590.22.2583.786.9

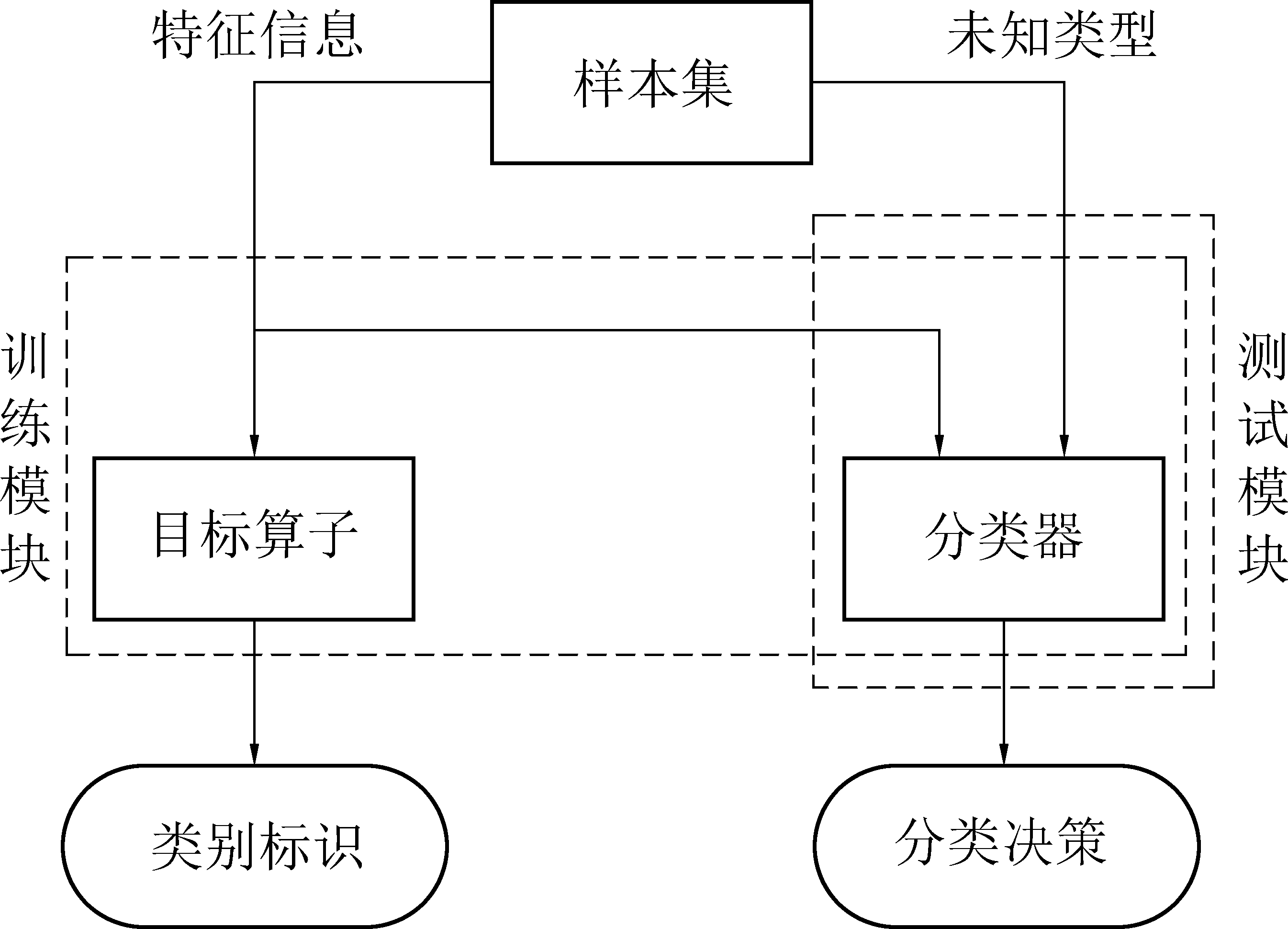

2.2 模式分类与识别

当前的立体视觉匹配算法在实时性,准确性方面都有了很大的提高,但是其在处理弱纹理区域,深度不连续区域和遮挡区域时效果不佳,这严重地影响到了三维重建的质量。匹配算法在进行图像对的匹配时,只用到了图像的浅层信息,这容易产生匹配歧义性问题。而人工智能领域的模式分类与识别方法,能够在图像理解的层次上,进行有效的深层特征提取,目前已经成为了机器人视觉与图像处理领域的关键技术。模式分类与识别可定义为:依据目标的属性或特征,利用智能机器和分类算法对其进行分类和识别[49]。RICHARD等对模式分类与识别进行了深入的研究[50],将模式分类划分为监督学习分类和无监督学习分类2种类型。前者通过先验信息和训练数据集来设计分类器,代表性方法有基于贝叶斯决策的分类法、基于模糊逻辑的分类法、基于神经网络的分类法和基于参数/非参数估计的分类法等。后者也被称为聚类,代表性方法有基于函数最优聚类法、层次聚类法、顺序聚类法等。一般地,模式分类需要经历训练和测试2个阶段。如图4所示,训练阶段主要通过训练样本特征来设计分类器,并完成类别标识。测试阶段主要是利用分类器对未知的测试样本进行测试,并形成分类决策。

图4 分类器训练和测试流程框架

Fig.4 Framework for training and testing of classifiers

当前,模式分类问题的求解方法向着多策略结合的方向发展,常用的有遗传算法与神经网络相结合的方法[51],模糊逻辑与神经网络相结合的模糊神经网络方法[52]等。模糊逻辑具有较强的推理能力,但自学习能力较弱,而神经网络能够进行深度学习,所以两者的结合可以显著提高模式分类与识别的效率和准确度[53]。例如,SHANG等[54]将模糊逻辑与神经网络相结合,研发了一套基于模糊神经网络的煤矿救援机器人双目视觉系统,并将其应用于煤矿巷道障碍物的分类与识别。该研究的特点在于将模糊逻辑中的类别隶属度函数进行了调整和优化,实现了启发式的分类过程。根据煤矿环境,该研究设置了4种障碍物类型,即:①前向巷道没有障碍物;②前向巷道有可逾越的障碍物;③前向巷道有不可逾越但可绕过的障碍物;④前向巷道有不可逾越且不可绕过的障碍物。首先,200幅已知特征类型的障碍物图像(4种类型各50幅)作为训练样本,50幅未知类型的障碍物图像作为测试样本,进行神经网络权值的迭代,然后汇总信号误差。当信号平均误差小于预设阈值时达到收敛要求,停止迭代过程,完成分类器的训练和测试。最后得到隶属度函数的关键参数,并形成类别标识和决策。如图5所示为基于模糊神经网络的双目视觉识别过程,输入特征为障碍物的宽度、高度、深度,巷道宽度和最大越障高度,模糊神经网络为基于反向传播算法的5层前向结构。MATLAB仿真结果表明,机器人双目视觉识别的正确率为99.28%,均方误差为7.2×10-4,所以该系统对环境的非线性映射具有良好的自适应能力,可以较为准确地对前向巷道的障碍物类型进行分类和识别。

图5 基于模糊神经网络的双目视觉识别流程

Fig.5 Process of binocular visual recognition based on fuzzy neural network

此外,煤矿救援机器人双目视觉所采集的环境图像既包含障碍物信息,又包含背景信息。所以需要从图像中识别出障碍物,即提取区域特征。常用的算法有K-means聚类算法[55]和Graph-Cut 障碍识别算法[56]等。前者是先从大量信息流中任选K个值作为聚类起始中心点,然后再对所有信息进行分类,直到聚类中心点收敛时,终止迭代。后者基于能量优化原理,可以有效地进行背景分割和障碍物特征提取。

2.3 视觉测量和三维重建

煤矿救援机器人视觉系统需要对煤矿的非结构化环境进行三维重建,最重要的任务之一就是要获取和分析障碍物的距离信息(深度),即视觉测量,从而为其导航和路径规划提供依据。视觉测量方法分为有源测距和无源测距。有源测距可将机器人获取的环境局部信息累积到机器人世界坐标系中,直接测定目标到机器人之间的距离[57]。如飞行时间(TOF)、结构光、光编码和红外测距等都属于有源测距。双目视觉技术属于无源测距,其在非结构照明条件下,仅从双目摄像机采集的二维图像中就可以提取距离信息。而距离信息的有效性和准确性则依赖于图像中特征提取的效果和约束条件的应用。

特征提取是获取目标三维信息的前提和基础,常用的特征提取方法包括Harris算法[58],SIFT(Scale Invariant Feature Transform)算法[59]和SURF(Speeded Up Robust Features)算法[60]。Harris算法具有旋转不变特性,但不具备尺度不变特性。SIFT算法具有旋转和尺度不变特性,且可扩展性强,但实时性不高。SURF算法在SIFT算法的基础上进行了改进,其特征提取速度得到了较大提高。特征提取之后的下一步就是获取深度图,而深度图的完备性和准确性则由约束条件来保障。深度图中的约束条件包括极线约束、相容性约束、唯一性约束和连续性约束[61]。这4个约束是在双目视觉成像模型中客观存在的几何条件。此外,在真实场景中,采集对象之间还存在着场景约束,如视差约束,顺序约束和互相对应约束等。

例如,NIU等[62]利用煤矿救援机器人双目视觉系统进行了测量和三维重建试验。摄像机采集完图像后,Harris算法被用于提取特征角点,其中角点响应函数F(x, y)可表示如下[62]:

F(x,y)=Det(M)-kTrace2(M)

(4)

式中:Det代表矩阵的行列式;Trace代表矩阵的迹;M为偏导数矩阵;k为经验常数。

另外,极线约束被用于降低图像的匹配误率,约束方程可表示如下:

(5)

式中:E为本质矩阵,即一幅图像上的点确定另一幅图像上的一条直线的基本矩阵;Pl为空间点P在左相平面上的像点;Pr为空间点P在右相平面上的像点。

在得到了精确的匹配角点之后,采用最小二乘法求解得到了目标点的3维坐标,完成了视觉测量任务。

2.4 组合测量与定位

单一测量与定位源在目标定位、识别和追踪方面存在着精度不高,时间滞后,鲁棒性较弱和测量维度单一的缺点,而多源组合测量与定位能够取得较好的效果。常见的基于视觉的测量与定位组合有:①视觉/惯性组合;②视觉/激光雷达组合;③视觉/超声波组合;④视觉/红外组合;⑤视觉/惯性/激光雷达组合等。例如,朱晓飞等[63]提出了一项视觉/惯性组合测量与定位策略。其中视觉模块采用双目视觉。考虑到惯性测量具有误差随时间累积和放大的缺点,该研究将视觉和惯性测量结果的差值作为误差函数的观测量,并结合卡尔曼滤波器,对系统误差进行修正,实现了较为精确的定位。仿真结果证明,该系统在x和y方向的相对位置误差分别小于 0.4% 和 0.3%,这在一定程度上降低了双目视觉信号的离散性。

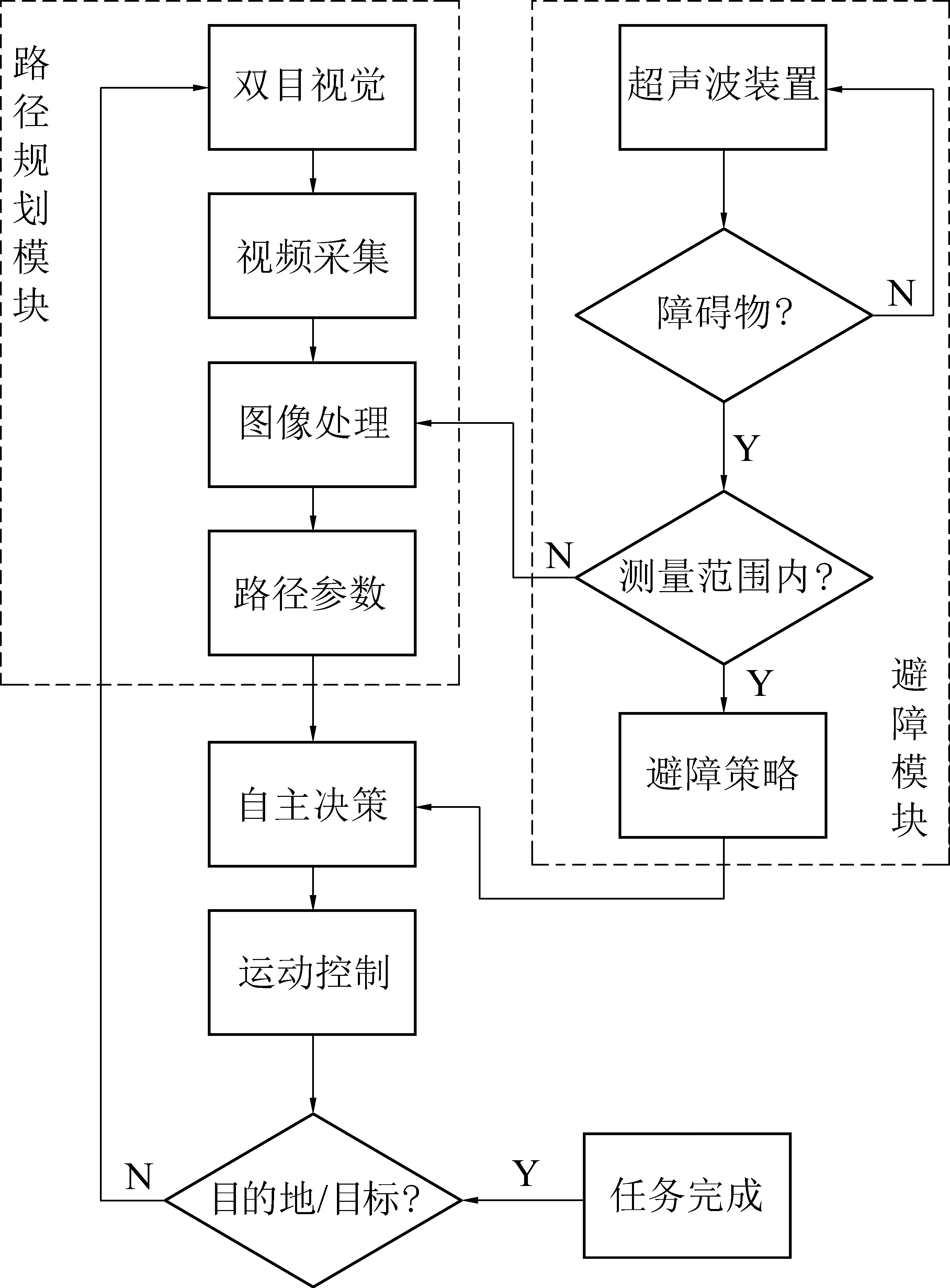

视觉传感器测距范围广,获取信息量大,定位精度较高,但易受环境光的影响。此外,视觉测量存在死角效应,煤矿救援机器人难以在其盲区进行路径规划[64]。超声波传感器结构简单,成本较低,且时间分辨率好,不受环境光的影响,但测量距离短,采集速度慢,适用于近距离测量。因此,在视觉传感器的基础上,辅助超声波测距进行补偿,可以实现高精度的实时测量和定位。视觉/超声波组合策略的工作流程如图6所示,煤矿救援机器人双目视觉模块和超声波模块协同工作。视觉模块实时获取场景信息,经图像处理器滤波、分割、增强等处理后,生成路径参数,用于机器人运动控制。同时,超声波模块检测前向通道是否有障碍物,并根据反射时间差原理测量障碍物距离[65],形成避障动作。若障碍物距离超过超声波测距范围,则反馈给视觉处理模块,进行障碍物识别。2个部分的信息经机器人决策系统分析后,进而驱动机器人运动[66]。例如,HE等[67]设计了一款煤矿救援机器人,如图7所示。采用双目视觉测距和超声波测距相组合的避障策略。首先利用超声波检测技术对前向通道的障碍物进行检测,并根据实际情况将信息反馈给双目视觉模块,用于获取障碍物的外部轮廓信息,最后形成避障动作,控制机器人运动。

图6 双目视觉与超声波组合测量与定位流程

Fig.6 Combined measurement and positioning flow of binocular vision and ultrasonic

图7 煤矿救援机器人

Fig.7 Coal mine rescue robot

2.5 视觉伺服控制

机器人视觉伺服控制是指通过视觉传感器获取机器人与目标的相对位置,从而实现机器人姿态和运动的反馈闭环控制[68]。HILL等[69]首先提出了视觉伺服的概念。目前该理论已经趋于成熟,并得到了广泛的应用。在视觉伺服系统中,视觉传感器的配置方式有2种。第1种是摄像机固定在工作空间中,机器人运动时不会带动摄像机运动。第2种是摄像机安装在机器人本体上或者机械手上,机器人相对于目标的姿态可以通过摄像机和机械手之间的姿态关系来确定。在紧急救援情况下,移动机器人首选第2种配置方式。例如,柴钰等[70]设计了一套煤矿救援机器人双目视觉伺服控制系统。首先,机器人双目摄像机采集煤矿的场景图像。然后,视觉分析与处理模块提取图像特征信息,生成视觉反馈信号,并作用于机器人电机系统。最后电机驱动机器人机械臂运动,实现了机器人姿态和运动的反馈控制。

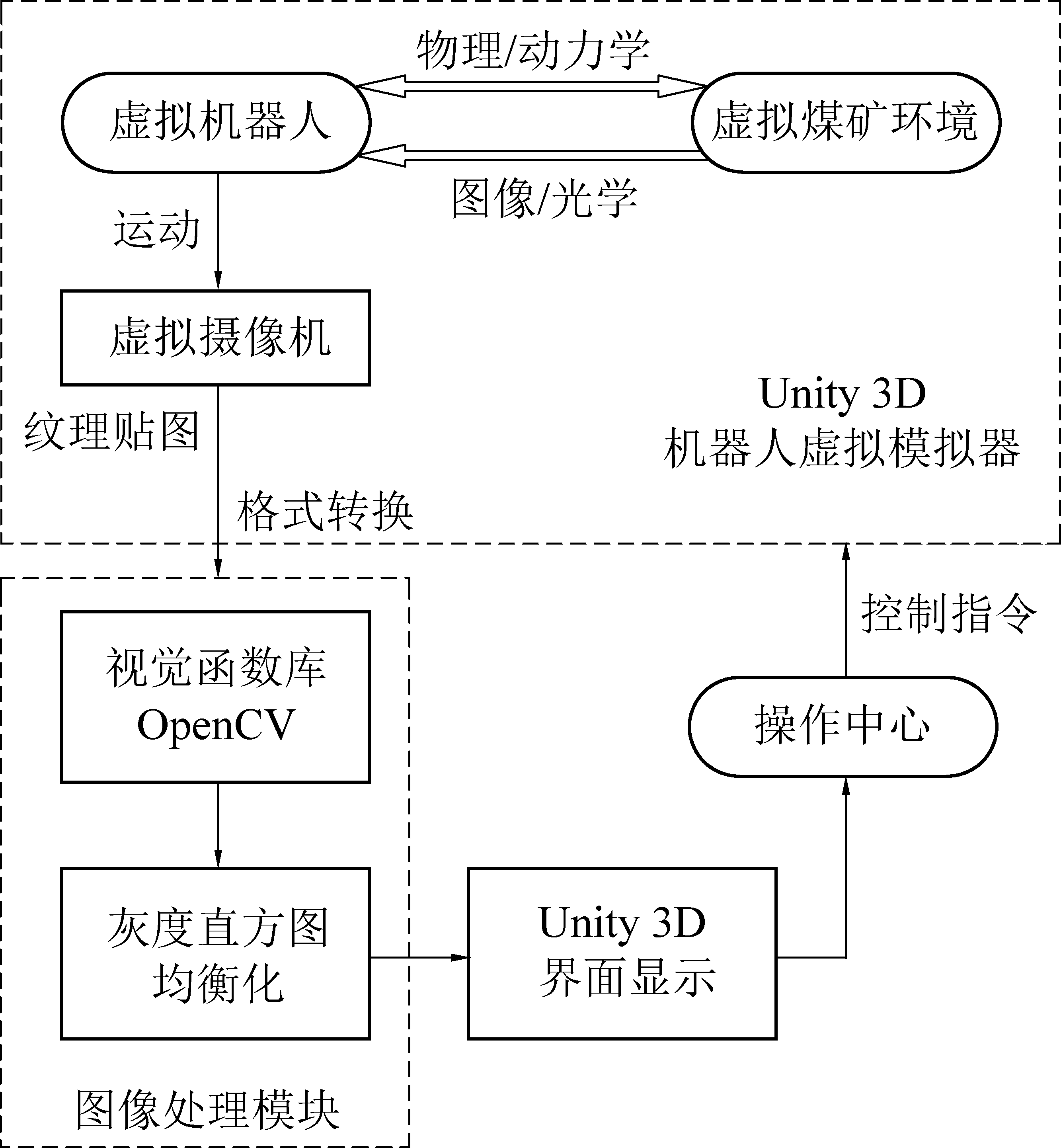

2.6 基于虚拟现实技术的视觉算法仿真

煤矿事故现场存在着大量严重影响视觉可视化的干扰因素,所以其视觉算法需要根据煤矿环境特点经过多次测试并调试后才可以确定其关键参数。然而,搭建一个高度逼真的受灾测试环境不仅困难,而且成本很高,周期很长。而虚拟现实技术能够提供代替真实测试环境的特种机器人视觉算法测试平台,并支持交互式仿真。例如,WANG等[71]利用虚拟现实技术搭建了用于煤矿救援机器人视觉增强算法验证的虚拟测试环境。该研究基于Unity 3D虚拟平台,构建了包含有巷道、障碍物、煤尘等在内的虚拟煤矿环境和虚拟煤矿救援机器人。视觉增强算法在虚拟环境中的实现流程如图8所示,虚拟机器人运动时带动Unity 3D内置虚拟摄像机去采集虚拟世界的图像信息。

图8 虚拟现实平台视觉增强算法仿真流程

Fig.8 Simulation process of visual enhancement algorithm based on virtual reality

视觉函数库OpenCV以链接库的形式被封装到Unity 3D平台中,所以在Unity 3D平台上就可以直接调用OpenCV库的直方图均衡化算法,用于图像增强处理。处理结果可视化地显示在用户界面上后,操作员根据信息就可以给Unity 3D机器人虚拟模拟器发送指令,进而控制煤矿救援机器人的运动。在有煤尘干扰和点光源强度为3 lx的条件下,虚拟摄像机采集的图像及处理效果如图9所示[71]。原始图像和原始直方图分别如图9a、图9b所示,直方图均衡化算法处理后的图像和直方图分别如图9c、图9d所示。可以看出,经过直方图均衡化算法处理后,图像的灰度趋于均匀,障碍物轮廓趋于清晰。因此,虚拟现实技术可以用来验证煤矿救援机器人视觉算法的性能。

图9 虚拟图像及处理结果

Fig.9 Virtual images and processing results

3 救援机器人关键技术和发展趋势

3.1 关键技术

3.1.1 运动模糊和镜头污染对双目视觉系统鲁棒性

不同于一般的工业场景,煤矿事故现场环境异常复杂。事故发生之后,巷道、运输设备和排水系统等都会遭到严重的破坏。瓦斯和煤尘爆炸所形成的冲击波会造成石块、煤块、顶板等散落和坍塌[72]。此外,现场可能还会发生二次爆炸或其他灾害。这些都会引起煤矿救援机器人双目摄像机的剧烈抖动,导致采集的图像出现运动模糊。另外,煤矿救援机器人在移动时,搭载的摄像机镜头会粘附上受潮的微细粉尘,造成镜头污染,进一步导致采集的图像质量劣化。运动模糊和镜头污染严重地影响了双目视觉系统的鲁棒性,致使图像信息丢失,特征提取困难,最终影响测距精度。因此,如何根据煤矿环境,提高稳像水平,减弱复杂地形和粉尘运移所带来的消极影响,是当前面临的技术难题。

3.1.2 超广角镜头的非线性畸变对摄像机标定

超广角镜头焦距更短,视角更大,其能够在较短的距离范围内,采集到更多的场景信息。所以煤矿救援机器人在搭载超广角双目摄像机的情况下,能够更加适应煤矿的高动态特点。然而,相比较于常规镜头,超广角镜头会发生大幅的非线性畸变[73],造成摄像机标定困难。因此,如何有效地矫正和补偿非线性畸变造成的失真,提高超广角摄像机的标定精度,是当前面临的技术瓶颈。

3.1.3 照度条件对立体视觉匹配

事故发生之后,煤矿井下的光照强度极弱,甚至是零照度情况。虽然煤矿救援机器人可以携带光源,但是受到能耗、体积、安全和安装的限制,其稳定性较差,难以达到高对比度和强鲁棒性的要求。立体匹配的相似性计算依赖于图像对的像素灰度值,而像素灰度值对光照强度很敏感。不理想的光照强度会增加图像噪声,降低信噪比,使图像像素灰度发生畸变[74]。因此,煤矿井下的弱照度或零照度条件会增加立体视觉匹配过程的误匹配率,进而导致3维重建的效果不理想。因此,如何根据煤矿环境,提高双目视觉系统的光照自适应能力,这也是当前面临的技术挑战。

3.2 发展趋势

3.2.1 基于大视场双目视觉的多自由度测量

为了使煤矿救援机器人视觉系统在尽可能短的时间内,获取尽可能多的环境信息,需要增大其视场范围。传统的双目摄像机是通过摄像机和目标物之间的固定位置关系,结合约束条件,进而完成3维重建。这虽然提高了成像的稳定性,但是其视场范围较小,限制了其获取大范围场景信息的能力。为此,可以增加双目视觉系统的自由度。WU等[75]提出了一种基于双目视觉和编码圆柱辅助的六自由度位移测量方法,可以获取目标物转动和平动的位移信息。GHASEMI等[76]提出了一种基于自适应开关控制的工业机器人视觉伺服方案。该方案可以对摄像机的平移和旋转运动进行解耦,提高系统的响应速度,改善视觉伺服系统的跟踪性能。GIBALDI等[77]在研究中通过调整双目视觉的多注视方向,使其能够在较大视场范围内对视觉刺激产生实时有效的转向运动。王庆滨等[78]研发了一款拥有4个旋转自由度的视觉平台,并搭载了一套可以单独运动的双目摄像机,有效地扩大了双目视觉的视场范围。因此,通过增加双目视觉系统的自由度,可以显著地提高双目视觉的视场范围。这不但有利于煤矿救援指挥中心在较短的时间内获取尽可能多的信息,制定合理的救援策略,而且有利于煤矿救援机器人进行高效的路径规划和自主决策。

3.2.2 基于传感器信息融合的多策略感知

煤矿井下光线较暗,空气中漂浮着大量煤尘,这极大的影响了视觉传感器的图像采集过程。此外,单一视觉传感器的目标信噪比较差,空间分辨率和光谱存在局限性。因此,为了提高图像采集质量和测距精度,煤矿救援机器人视觉系统可以同时搭载其他传感器,例如激光传感器,红外传感器,或者惯性测量单元等,然后通过传感器信息融合技术来实现信息互补。在工程上,传感器信息融合是指将多个传感器或信息源的信息综合起来,经处理和分析后,能够精确合理的描述感知对象,并最终形成可靠的决策[79]。其中,图像融合是至关重要的。图像融合是指将来自一个场景的多幅图像组合在一起,从而提供一张合成图像[80]。与单一的双目视觉获取的图像相比,该合成图像增强了后期处理效果,所以其有效信息性更大。因此,通过搭载2个及其以上测距传感器,然后应用传感器信息融合技术,就可以最大程度地描述视野内的环境信息,以此提高煤矿救援机器人获取事故现场信息的准确性。

3.2.3 基于仿生的主动视觉和自适应感知

双目摄像机采集目标物图像是实现双目视觉功能和完成视觉反馈及控制最基本的要求。煤矿井下的环境是动态的,所以目前双目摄像机很难稳定地将目标保持在其视场范围内。杨广中等[81]在2019“年度十大机器人技术”中提到,通过提取一般的生物学原理,基于生物启发设计,可以将工程学推向超越自然界的可能性。仿生的柔性机器人可以在复杂和非结构化的环境中避开障碍物,这为探索和救援机器人的导航带来了新方向。LONINI等[82]研究指出,在感知和运动的循环过程中,主动视觉能够引导视觉信息的流动,从而进行高效的自学习活动。BAJCSY等[83]研究指出,感知系统的感觉和处理应该是主动的,系统必须具有探索能力,且能够进行信息评估。因此,在复杂的煤矿动态环境中,煤矿救援机器人应该利用主动视觉来增强与环境的交互能力,积极地感知环境信息,提高其获取信息的可靠性和适应环境变化的能力。未来的研究重点应该是开发仿生物网络控制的主动视觉算法,然后通过反馈伺服控制,实现双目视觉的自适应感知。

4 结 论

煤矿救援机器人是人工智能在智慧矿山领域的具体应用。在煤矿的非结构化环境中,双目视觉能够获取环境的大部分信息,因此,基于双目视觉的煤矿救援机器人的研发和应用至关重要。主要结论如下:

1)双目视觉技术是煤矿救援机器人自主避障和导航的关键。其中,摄像机标定精度和立体视觉匹配效果决定了三维重建的质量。非结构化的煤矿环境对摄像机标定和立体视觉匹配的精度、实时性和智能化有着更高的要求。

2)近年来,基于双目视觉的煤矿救援机器人的应用和研究取得了很多代表性的成果,主要集中在立体视觉匹配算法改进、模式分类与识别、视觉测量与三维重建、组合测量与定位、视觉伺服控制和基于虚拟现实技术的视觉算法仿真等方面。

3)煤矿事故现场具有高动态和强干扰的特点,煤矿救援机器人双目视觉受到煤矿井下复杂地形,煤尘运移和弱/零照度条件的影响,图像模糊,镜头畸变和立体视觉匹配困难等问题亟待解决。

4)煤矿救援机器人双目视觉未来应该主要在大视场,高精度和自适应感知等方面发展,建议重点研发多自由度测量,传感器信息融合和基于主动视觉的自适应感知等技术。

[1] 谢和平,吴立新,郑德志.2025年中国能源消费及煤炭需求预测[J].煤炭学报,2019,44(7):1949-1960.

XIE Heping, WU Lixin, ZHENG Dezhi.Prediction on the energy consumption and coal demand of China in 2025[J].Journal of China Coal Society, 2019, 44(7):1949-1960.

[2] ZHANG Jiangshi, FU Jing, HAO Hongyu, et al.Root causes of coal mine accidents:characteristics of safety culture deficiencies based on accident statistics[J].Process Safety and Environmental Protection, 2020, 136:78-91.

[3] 葛世荣,胡而已,裴文良.煤矿机器人体系及关键技术[J].煤炭学报,2020,45(1):455-463.

GE Shirong, HU Eryi, PEI Wenliang.Classification system and key technology of coal mine robot[J].Journal of China Coal Society, 2020, 45(1):455-463.

[4] HAN Shuai, CHEN Hong, LONG Ruyin, et al.Evaluation of the derivative environment in coal mine safety production systems:Case study in China[J].Journal of Cleaner Production, 2017, 143:377-387.

[5] LIU Qing, LIU Jian, GAO Jinxin, et al.An empirical study of early warning model on the number of coal mine accidents in China[J].Safety Science, 2020,123:1-7.

[6] MURPHY Robin R, KRAVITZ Jeffery, STOVER Samuel L, et al.Mobile robots in mine rescue and recovery[J].IEEE Robotics and Automation Magazine, 2009, 16(2):91-103.

[7] 王国法,杜毅博.煤矿智能化标准体系框架与建设思路[J].煤炭科学技术,2020,48(1):1-9.

WANG Guofa, DU Yibo.Coal mine intelligent standard system framework and construction ideas[J].Coal Science and Technology, 2020, 48(1):1-9.

[8] 王国法,赵国瑞,任怀伟.智慧煤矿与智能化开采关键核心技术分析[J].煤炭学报,2019,44(1):34-41.

WANG Guofa, ZHAO Guorui, REN Huaiwei.Analysis on key technologies of intelligent coal mine and intelligent mining[J].Journal of China Coal Society, 2019, 44(1):34-41.

[9] 宋 锐,郑玉坤,刘义祥,等.煤矿井下仿生机器人技术应用与前景分析[J].煤炭学报, 2020, 1-15.https://doi.org/10.13225/j.cnki.jccs.ZN20.0328.

SONG Rui, ZHENG Yukun, LIU Yixiang, et al.Analysis on the application and prospect of coal mine bionic robotics[J].Journal of China Coal Society, 2020, 1-15.https://doi.org/10.13225/j.cnki.jccs.ZN20.0328.

[10] PEREZ Luis, RODRIGUEZ Inigo, RODRIGUEZ Nuria, et al.Robot guidance using machine vision techniques in industrial environments:a comparative review[J].Sensors, 2016,16(3):35-43.

[11] ZHANG Shengfu, LI Bo, REN Fuji, et al.High-precision measurement of binocular telecentric vision system with novel calibration and matching methods[J].IEEE Access, 2019(7):54682-54692.

[12] HU P, HAO X Y, LI J S, et al.Design and implementation of binocular vision system with an adjustable baseline and high synchronization[C].IEEE International Conference on Image, Vision and Computing(ICIVC), 2018:566-570.

[13] CHEN Hua-Tsung.Geometry-based camera calibration using five-point correspondences from a single image[J].IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(12):2555-2566.

[14] ZHU Hongjun, LI Yan, LIU Xin, et al.Camera calibration from very few images based on soft constraint optimization[J].Journal of the Franklin Institute-Engineering and Applied Mathematics, 2020, 357(4):2561-2584.

[15] CHEN Xiaoyun, LIN Jiarui, YANG Linghui, et al.Flexible calibration method for visual measurement using an improved target with vanishing constraints[J].Journal of the Optical Society of America.2020, 37(3):97-114.

[16] BOUDINE Bouchra, KRAMM Sebastien, El Akkad Nabil, et al.A flexible technique based on fundamental matrix for camera self-calibration with variable intrinsic parameters from two views[J].Journal of Visual Communication and Image Representation, 2016, 39:40-50.

[17] YANG Shoubo, GAO Yang, LIU Zhen, et al.A calibration method for binocular stereo vision sensor with short-baseline based on 3D flexible control field[J].Optics and Lasers in Engineering, 2020, 124:1-9.

[18] ZHANG Z Y.A flexible new technique for camera calibration[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11):1330-1334.

[19] ABDEL-AZIZ Y I, KARARA H M.Direct linear transformation from comparator coordinates into object space coordinates in close-range photogrammetry[J].Photogrammetric Engineering and Remote Sensing, 2015, 81(2):103-107.

[20] BARONE Francesco, MARRAZZO Marco, OTON Claudio J.Camera calibration with weighted direct linear transformation and anisotropic uncertainties of image control points[J].Sensors, 2020, 20(4):73-78.

[21] ZHOU Ping, CAI Weijia, YU Yunlei, et al.A two-step calibration method of lenslet-based light field cameras[J].Optics and Lasers in Engineering, 2019, 115:190-196.

[22] 刘 阳,刘 巍,徐鹏涛,等.基于纯平移两视图几何的镜头畸变参数标定[J].光学精密工程,2016,24(4):922-929.

LIU Yang, LIU Wei, XUPengtao, et al.Calibration of lens distortion parameters based on two view geometry of translation motion[J].Optics and Precision Engineering, 2016, 24(4):922-929.

[23] 李宝全,方勇纯,张雪波.基于纯旋转运动的摄像机统一自标定方法[J].光学学报,2013,33(11):154-161.

LI Baoquan, FANG Yongchun, ZHANG Xuebo.Unified rotation-based self-calibration method for cameras[J].Acta Optica Sinica, 2013, 33(11):154-161.

[24] JIANG Zetao, LIU Sanchao.Self-calibration of varying internal camera parameters algorithm based on quasi-affine reconstruction[J].Journal of Computers, 2012, 7(3):774-778.

[25] CHANDRAKER Manmohan, AGARWAL Sameer, KRIEGMAN David, et al.Globally optimal algorithms for stratified autocalibration[J].International Journal of Computer Vision, 2010, 90(2):236-254.

[26] SCHARSTEIN D, SZELISKI R.A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[J].International Journal of Computer Vision, 2002, 47(1/3):7-42.

[27] BOYKOV Y, VEKSLER O, ZABIH R.Fast approximate energy minimization via graph cuts[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(11):1222-1239.

[28] SUN J, ZHENG N N, SHUM H Y.Stereo matching using belief propagation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(7):787-800.

[29] KIM J C, LEE K M, CHOI B T, et al.A dense stereo matching using two-pass dynamic programming with generalized ground control points[C].IEEE Conference on Computer Vision and Pattern Recognition,2005:1075-1082.

[30] SHELHAMER Evan, LONG Jonathan, DARRELL Trevor.Fully convolutional networks for semantic segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4):640-651.

[31] MAHATO Manimala, GEDAM Shirishkumar, JOGLEKAR Jyoti, et al.Dense stereo matching based on multiobjective fitness function-agenetic algorithm optimization approach for stereo correspondence[J].IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(6):3341-3353.

[32] YOON K J, KWEON I S.Adaptive support-weight approach for correspondence search[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2006, 28(4):650-656.

[33] LOWE D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision, 2004, 60(2):91-110.

[34] EMLEK A, PEKER M, YALCIN M K.Improving the cost-volume based local stereo matching algorithm[C].IEEE Signal Processing and Communications Applications Conference(SIU), 2018.

[35] YANG Jiachen, WANG Huanling, DING Zhiyong, et al.Local stereo matching based on support weight with motion flow for dynamic scene[J].IEEE Access, 2016(4):103-109.

[36] HIRSCHMUELLER Heiko.Stereo processing by semiglobal matching and mutual information[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2008, 30(2):328-341.

[37] LEE Yeongmin, PARK Mingyu, HWANG Youngbae, et al.Memory-efficient parametric semiglobal matching[J].IEEE Signal Processing Letters, 2018, 25(2):194-198.

[38] NI Jinyan, LI Qingwu, LIU Yan, et al.Second-order semi-global stereo matching algorithm based on slanted plane iterative optimization[J].IEEE Access, 2018(6):61735-61747.

[39] 孙继平,钱晓红.煤矿重特大事故应急救援技术及装备[J].煤炭科学技术,2017,45(1):112-116.

SUN Jiping, QIAN Xiaohong.Emergency rescue technology and equipment of mine extraordinary accidents[J].Coal Science and Technology, 2017, 45(1):112-116.

[40] WANG Yong, TIAN Peng, ZHOU Yu, et al.The encountered problems and solutions in the development of coal mine rescue robot[J].Journal of Robotics, 2018.

[41] THRUN S.Autonomous exploration and mapping of abandoned mines-software architecture of an autonomous robotic system[J].IEEE Robotics & Automation Magazine, 2004, 11(4):79-91.

[42] LI Yutan, LI Menggang, ZHU Hua, et al.Development and applications of rescue robots for explosion accidents in coal mines[J].Journal of Field Robotics,2020,37(3):466-489.

[43] ZHAO Jingchao, GAO Junyao, ZHAO Fangzhou, et al.A search-and-rescue robot system for remotely sensing the underground coal mine environment[J].Sensors, 2017, 17(10):2426-2430.

[44] WANG Weidong, DONG Wei, SU Yanyu, et al.Development of search-and-rescue robots for underground coal mine applications[J].Journal of Field Robotics, 2014, 31(3):386-407.

[45] BAI Yun, HOU YuanBin.Research of pose control algorithm of coal mine rescue snake robot[J].Mathematical Problems in Engineering, 2018,4751245:1-9.

[46] 王 宇,刘泓滨,吴智恒,等.机器视觉的救灾机器人越障性能分析[J].煤矿机械,2016,37(7):92-94.

WANG Yu, LIU Hongbin, WU Zhiheng,et al.Obstacle surmounting analysis for rescue robot based on machine vision[J].Coal Mine Machinery, 2016, 37(7):92-94.

[47] HE S M, TONG Z Y, MA G B, et al.Research on stereo vision matching algorithm for rescue robot[C].International Conference on Robotics and Automation Sciences(ICRAS), 2017:35-38.

[48] 巩 固,朱 华.煤矿救援机器人环境目标图像识别[J].工矿自动化,2017,43(7):7-11.

GONG Gu, ZHU Hua.Environmental target image recognition of coal mine rescue robot[J].Industry and Mine Automation, 2017, 43(7):7-11.

[49] 张学工.模式识别[M].3版.北京:清华大学出版社,2010:1-3.

ZHANG Xuegong.Pattern recognition[M].Third edition.Beijing:Tsinghua University Press, 2010:1-3.

[50] RICHARD O D, PETER E H, DAVID G S, 著.李宏东,姚天翔,译.模式分类[M].2版.北京:机械工业出版社,2003:12-13.

RICHARD O D, PETER E H, DAVID G S, waiting.LI Hongdong, YAO Tianxiang, translation.Pattern Classification[M].Second edition.Beijing:China Machine Press, 2003:12-13.

[51] 周辉仁,郑丕谔,牛 犇,等.基于递阶遗传算法和BP网络的模式分类方法[J].系统仿真学报,2009,21(8):2243-2247.

ZHOU Huiren, ZHENG Pie, NIU Ben.HGA-BP-based pattern classification method[J].Journal of System Simulation, 2019, 21(8):2243-2247.

[52] 孔令文,李鹏永,杜巧玲.基于模糊神经网络的六足机器人自主导航闭环控制系统设计[J].机器人,2018,40(1):16-23.

KONG Lingwen, LI pengyong, DU Qiaoling.The closed-loop control system design of hexapod robot autonomous navigation based on fuzzy neural network[J].Robot, 2018, 40(1):16-23.

[53] KULKARNI A, KULKARNI N.Fuzzy neural network for pattern classification[J].Procedia Computer Science, 2020, 167:2606-2616.

[54] SHANG C C, MA H W.Coal mine robot binocular vision recognition system based on fuzzy neural network[C].phuket;International Conference on Automation, Mechanical and Electrical Engineering, 2015:95-98.

[55] 王美华,曾燕妮,蔡瑞初.改进K-Means聚类算法及其在视觉词典构造中的应用[J].计算机应用与软件,2015,32(10):159-163.

WANG Meihua, ZENG Yanni, CAI Ruichu.Improved k-means clustering algorithm and its application in visual vocabulary building[J].Computer Applications and Software, 2015, 32(10):159-163.

[56] 蒋建国,郭艳蓉,郝世杰,等.贝叶斯框架下的非参数估计Graph Cuts分割算法[J].中国图象图形学报,2011,16(6):947-952.

JIANG Jianguo, GUO Yanrong, HAO Shijie, et al.Graph cuts segmentation based on bayesian nonparametric estimation[J].Journal of Image and Graphics, 2011, 6(6):947-952.

[57] 李宇波,朱效洲,张 辉,等.救援机器人技术研究进展[J].机器人技术与应用,2011(6):6-12.

LI Yubo, ZHU Xiaozhou, ZHANG Hui, et al.Research progress of rescue robot technology[J].Robot Technique and Application,2011(6):6-12.

[58] HARRIS C,STEPHENS M.A combined corner and edge detector[C]//Manchester:Alvey Vision Conference AVC,1988:147-151.

[59] LOWE D G.Distinctive image features from scale-invariant keypoints[J].Int J Comput Vis, 2004, 60(2):91-110.

[60] BAY H, ESS A, TUYTELAARS T, et al.Speeded-up robust features(SURF)[J].Comput Vis Image Underst,2008, 110(3):346-359.

[61] 刘李漫,谭龙雨,刘 佳.基于多种几何约束的图像误匹配剔除算法[J].中南民族大学学报:自然科学版,2020,39(1):91-97.

LIU Liman, TANLongyu, LIU Jia.A mismatch removing method based on multiple geometric constraints[J].Journal of South-Central University for Nationalities:Natural Science Edition, 2020, 39(1):91-97.

[62] NIU Z G, LI L J, WANG T.3D reconstruction based on binocular stereo vision of robot[J].Advanced Materials Research,2011, 338:645-648.

[63] 朱晓飞.煤矿救灾机器人的惯性/视觉组合导航方法研究[J].矿山机械, 2010,38(4):12-14.

ZHUXiaofei.Inertial/computer-vision integrated navigation for the coalmine rescue robot[J].Mining & Processing Equipment, 2010, 38(4):12-14.

[64] 卢万杰,付 华,赵洪瑞.煤矿井下探测搜救机器人地形感知系统及路径规划方法研究[J].传感技术学报,2019,32(7):979-985.

LU Wanjie, FU Hua, ZHAO Ruihong.Research on topographic perception system and path planning method of underground detection and search and rescue robot in coal mine[J].Chinese Journal of Sensors and Actuator, 2019, 32(7):979-985.

[65] 李剑汶,周 慧,王小阳,等.基于超声波时差定位和卡尔曼滤波的服务机器人导航方法[J].南京大学学报:自然科学,2015,51(S1):82-86.

Li Jianwen, ZHOU Hui, WANG Xiaoyang, et al.Navigation of service robots based on ultrasonic transit-time positioning and Kalman filter algorithm[J].Journal of Nanjing University:Natural Science, 2015, 51(S1):82-86.

[66] KIM P G, PARK C G, JONG Y H, et al.Obstacle avoidance of a mobile robot using vision system and ultrasonic sensor[C].International Conference on Intelligent Computing, 2007:545-551.

[67] HE K, MA X M.Research on avoidance obstacle strategy of coal underground inspection robot based on binocular vision[C].Chinese Control and Decision Conference(CCDC), 2017:6732-6737.

[68] TAHERIAN A, MAZINAN A H and ALIYARI-SHOOREHDELI M.Image-based visual servoing improvement through utilization of adaptive control gain and pseudo-inverse of the weighted mean of the Jacobians[J].Comput Electr Eng, 2020, 83:19-28.

[69] HILL J.Real time control of a robot with a mobile camera[J].Proceedings of ISIR, 1979(1):441-449.

[70] 柴 鈺,贾晓劢,卫苏晶.一种新型可变形智能救援机器人系统设计[J].测控技术,2014,33(5):77-81.

CHAI Yu, JIA Xiaomai, WEI Sujing.Design of a novel deformable and intelligent rescue robot system[J].Measurement & Control Technology, 2014, 33(5):77-81.

[71] WANG Yong, TIAN Peng, ZHENG Benchang, et al.Special robot vision algorithm test platform in virtual reality environment[C].IEEE International Congress on Cybermatics, 2019.

[72] 陈先中, 刘荣杰,张 森, 等.煤矿地下毫米波雷达点云成像与环境地图导航研究进展[J].煤炭学报,2020,1-11.https://doi.org/10.13225/j.cnki.jccs.ZN20.0316.

CHEN Xianzhong, LIU Rongjie, ZHANG Sen, et al.The development of mm Wave radar imaging and SLAM in coal mine underground environment.Journal of China Coal Society, 2020, 1-11.https://doi.org/10.13225/j.cnki.jccs.ZN20.0316.

[73] MOON Suk Hwan.A study on ultra wide-angle lens distortion correction technique for object situation recognition in drone flight[J].The Journal of Korean Institute of Next Generation Computing, 2019, 15(3):78-85.

[74] 韩采芹,李 华,朱顺一,等.不同光照条件下CCD相机时间噪声和空间噪声的研究[J].应用光学,2008,29(2):207-210.

HAN Caiqin, LI Hua, ZHU Shunyi,et al.Temporal noise and spatial noise of CCD camera at different illuminance[J].Journal of Applied Optics, 2008,29(2):207-210.

[75] WU Lijun, SU Yiyan, CHEN Zhicong, et al.Six-degree-of-freedom generalized displacements measurement based on binocular vision[J].Structural Control & Health Monitoring, 2020, 27(2):2482-2489.

[76] GHASEMI Ahmad, LI Pengcheng, XIE WenFang.Adaptive switch image-based visual servoing for industrial robots[J].International Journal of Control Automation and Systems, 2019,45:1-11.

[77] GIBALDI Agostino, VANEGAS Mauricio, CANESSA Andrea, et al.A portable bio-inspired architecture for efficient robotic vergence control[J].International Journal of Computer Vision, 2017, 121(2):281-302.

[78] 王庆滨,邹 伟,徐 德,等.仿生眼运动视觉与立体视觉三维感知[J].机器人,2015,37(6):760-768.

WANG Qingbin, ZOU Wei, XU De, et al.3D perception of biomimetic eye based on motion vision and stereo vision[J].Robot, 2015, 37(6):760-768.

[79] ZHOU Xinbin, PENG Tong.Application of multi-sensor fuzzy information fusion algorithm in industrial safety monitoring system[J].Safety Science, 2020, 122:1-5.

[80] SHOLEHKERDAR Araz, TAVAKOLI Javad, LIU Zheng.Theoretical analysis of tsallis entropy-based quality measure for weighted averaging image fusion[J].Information Fusion, 2020, 58:69-81.

[81] YANG Guangzhong, FULL Robert J, JACOBSTEIN Neil, et al.Ten robotics technologies of the year[J].Science Robotics, 2019,4(26):1-4.

[82] LONINI L, ZHAO Y, CHANDRASHEKHARIAH P, et al.Autonomous learning of active multi-scale binocular vision[C].IEEE 3rd Joint International Conference on Development and Learning and Epigenetic Robotics(ICDL), 2013.

[83] BAJESY Ruzena, ALOIMONOS Yiannis, TSOTSOS John K.Revisiting active perception[J].Autonomous Robots, 2018, 42(2):177-196.