0 引 言

我国煤炭生产大部分采用井工作业,经常会有顶板压力、瓦斯、煤尘、水、火等自然灾害的威胁,所以煤矿井巷的日常安全巡检和灾害发生时的应急救援就显得尤为重要[1]。智能机器人在这方面具有效率高、成本低、可靠性高、危险因素检测准确的优势,得到越来越多的应用。由于煤矿井下没有卫星导航信号,且电磁环境复杂,因此实现井下智能机器人的自主导航具有重要意义。

自主导航技术[2]作为智能机器人的关键技术之一,是指移动机器人通过传感器感知环境信息和自身状态,实现在有障碍的环境中面向目标的自主运动。目前,移动机器人主要的导航方式包括:卫星导航、磁导航、惯性导航、视觉导航等。卫星导航[3]包括常见的GPS导航、北斗卫星导航等,适用于能接收到导航卫星信号的室外场所。磁导航[4]已经是比较成熟的技术,一般需要铺设专用磁条作为导引路线,常见的比如物流搬运AGV(Automatic Guided Vehicle,自动引导车)等。惯性导航[5]在导航的过程中只考虑自身传感器的数据,其适应性和自主性比较强,但是存在误差积累的问题。视觉导航[6]通过摄像头对障碍物或标志物拍摄获取图像信息,然后对图像信息进行探测和识别实现导航,它具有信号探测范围广,获取信息完整等优点,是智能机器人自主导航的一个主要发展方向。

视觉导航按照是否需要导航地图可分为地图型导航和无地图导航[6]。无地图导航方法通常不需要对环境进行全局描述,使用图像分割[7]、光流计算[8]和帧间特征跟踪[9]等方法获得视觉信息,通过目标识别或特征跟踪获取对环境的感知实现导航。

在煤矿巷道环境中,机器人的卫星导航、磁导航、惯性导航都不适用或具有一定的局限性,因此笔者主要研究基于无地图的视觉辅助导航方法。矿井巷道中架设有用于通信、电力传输、给排水、压风等的管线,具有显著的颜色和几何结构化特点,采用机器视觉相关算法对其进行分割和识别,然后对环境中结构化信息建立模型,并恢复到三维空间中解算机器人当前偏航角度,更新导航状态,进而引导机器人完成相关工作。

1 图像分割与环境结构化信息模型建立

1.1 基于HSV颜色空间的图像阈值分割

RGB颜色空间是通过对红、绿、蓝3个颜色通道的变化以及它们相互之间的叠加来得到各式各样的颜色的。

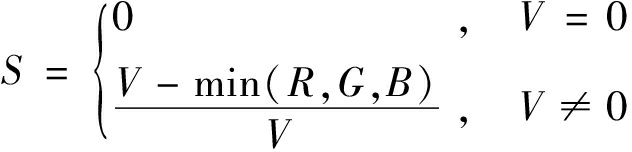

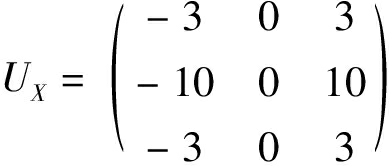

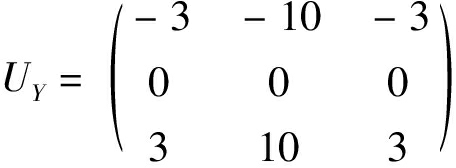

HSV颜色空间是由色调、饱和度和亮度3个属性组成[10],针对视觉范围内的感知空间,在光照发生变化时也能稳定显示图像的信息。HSV颜色空间可以给人们提供感知色彩的认知度,更适合在图像处理中使用。煤矿巷道中管线与背景的颜色差异较大,但是不同区域光照强度也不同,为了保证分割的效果,将图像由RGB转到HSV空间,同时使用3个通道对巷道中的管线进行分割[11]。从RGB转到HSV空间的公式如下:

V=max(R,G,B)

(1)

(2)

(3)

其中,R、G和B分别为RGB颜色空间红色、绿色和蓝色通道的颜色值,取值范围均为[0, 255];H为HSV颜色空间的色彩信息,取值范围为[0, 360];S为HSV颜色空间的颜色接近光谱色的程度,取值范围为[0, 1];V为HSV颜色空间的颜色明亮的程度,取值范围[0, 255]或归一化为[0, 1]。对原始的煤矿巷道图像进行颜色空间的转换,得到的结果如图1b所示。

图1 颜色空间转换

Fig.1 Color space conversion

根据颜色的先验知识选取相应的阈值,进行三通道的阈值处理,黄、绿、蓝3个管线的提取结果如图2所示。

图2 各管线提取结果

Fig.2 Extraction results of different color pipeline

由图2可得,3种管线均被提取出来,但是提取结果中还存在非管线的部分,整体来说仅依赖颜色提取管线的结果不太准确,仍然包含较多噪声,需要使用更多的图像信息精准地提取管线所在位置。

1.2 基于几何形状特征的分割

煤矿巷道中的管道信息,具有非常显著的几何形状特征:每一管道在图像中的投影都近似是2条平行线,且多个管道的方向具有一致性。因此,基于几何形状特征,采用图像纵向梯度特征进行管线检测和分割。

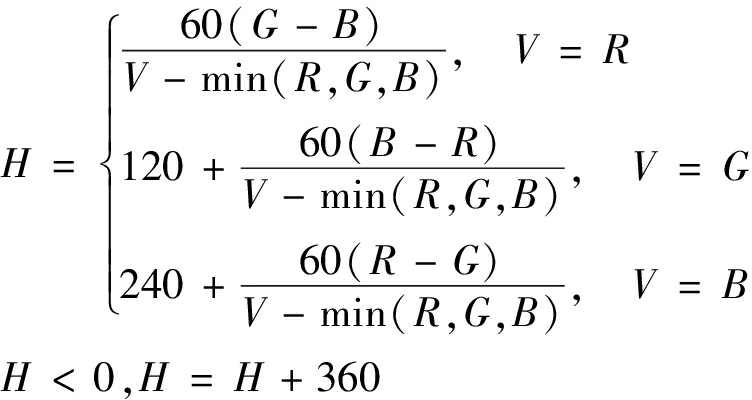

图像梯度检测通常使用Sobel[12]算子,其对图像的高斯平滑和微分操作,具有较好的抗噪能力。当卷积核大小为3时,X和Y方向的卷积核分别为

(4)

(5)

基于几何形状特征分割的具体步骤如下:①使用Sobel计算图像沿Y轴方向的梯度。②使用大津自适应阈值[13]方法对图像进行二值化操作,强化梯度信息。③进行形态学处理[14],抑制噪声,并改善管道梯度图像断断续续的情况。④根据巷道环境的特点设计一个Mask,同上一步骤中的结果进行卷积。⑤检测图像中的轮廓[15],进行面积等简单几何约束,就能够获得管道轮廓信息。

经过上述5个步骤的处理,巷道图像中的管线提取结果如图3所示。

其中,图3b为经过Y方向的Sobel算子提取的边缘图像,图3d为根据几何特征提取的管线结果,虽然管线都被提取出来,但是不精确,仍然包含部分噪声。

图3 巷道图像中的管线提取结果

Fig.3 Extraction results of pipelines in roadway image

2 结合颜色与几何特征的分割

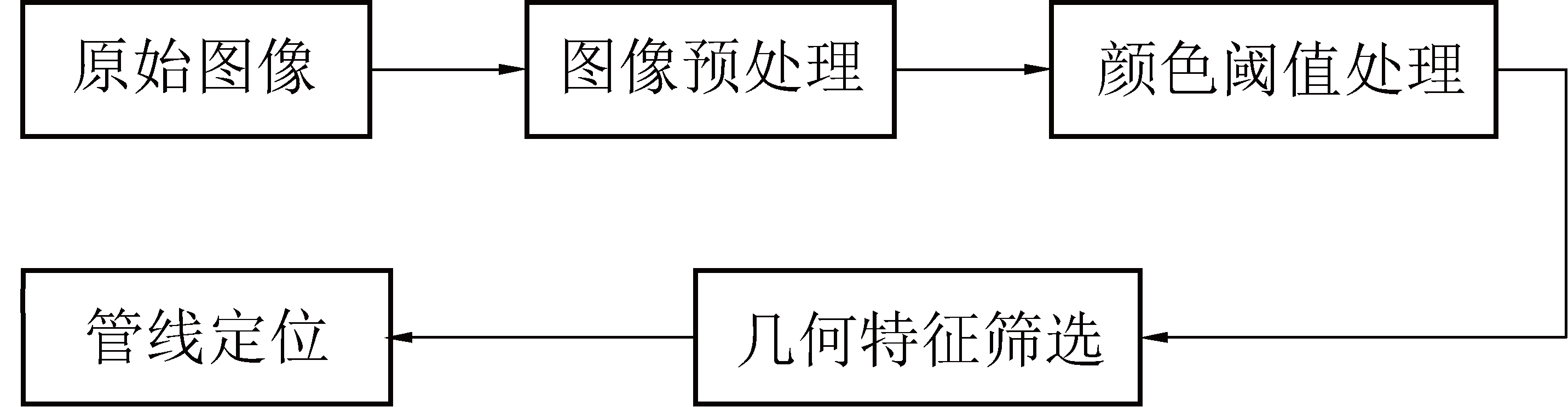

从上述分析可以看出,仅靠颜色信息或者简单的几何信息很难准确地分割巷道图像中的管线,笔者通过结合颜色与几何特征,将图像纵向分割成多个独立的子图像,从每个子图像中获取候选管道轮廓,并根据是否属于同一根管道轮廓分组,从每组候选轮廓中根据几何特征筛选出较为鲁棒和稳定的管道轮廓。具体的流程如图4所示。

图4 巷道图像中的管线分割流程

Fig.4 Flow of pipeline segmentation in roadway image

具体做法是将原始图像进行滤波处理后,将RGB颜色空间转换到HSV颜色空间进行阈值化处理,对阈值化处理结果的二值图,利用管线边沿是2条近似平行的直线这个几何特征来进行筛选,通过管线所在上下2条直线来定位巷道中的管线。

1)图像预处理。对图像进行预处理,对图像进行畸变校正[16],并将原始图像从RGB颜色空间转换到HSV颜色空间,将二值图沿Y轴方向切割成N1张小图,其中,N1=W/150,W为图像宽度,纵向切割如图5所示。

图5 纵向切割示意

Fig.5 Schematic of longitudinal cutting

2)管道颜色分割。选定管道颜色对应的HSV阈值,并适当放宽,使用该阈值进行阈值化操作得到二值图。

3)初步几何形状分割。对每张小图进行轮廓检测,并进行面积和形状等简单的几何约束[17]。至此初步得到符合颜色和几何形状要求的管道轮廓,但是仍然包含部分环境噪声。

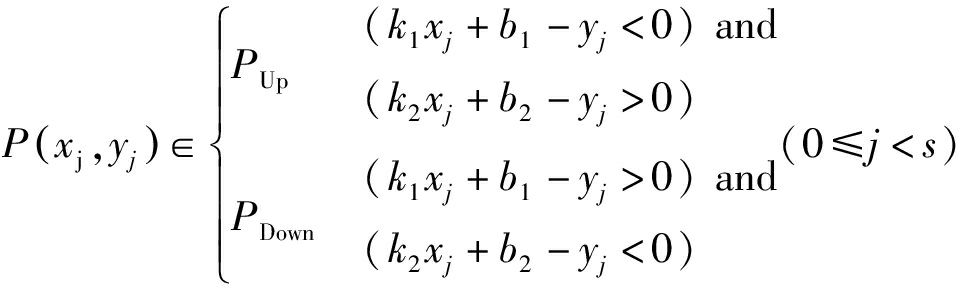

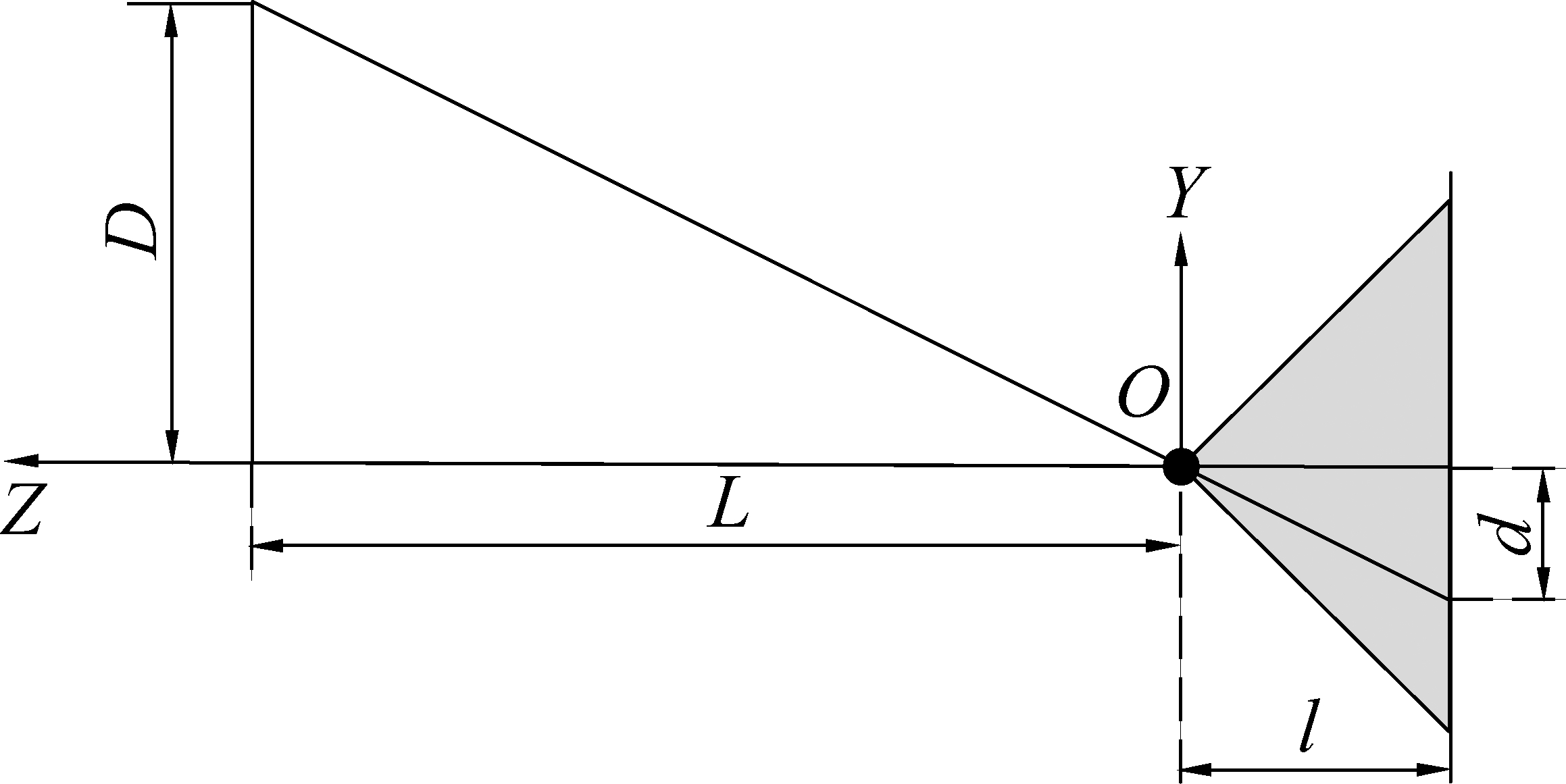

4)提取管道的上下边沿轮廓。将N1张小图中属于同一根管道的轮廓重新组合,对每组管道的每一段轮廓,计算其最小外接矩形,计算对角线方程,基于线性规划获得每段轮廓的上、下边沿轮廓点集PUp、PDown[18],公式如下:

(6)

其中:s为当前轮廓点集的大小;P(xj,yj)为第j个点坐标,xj、yj分别为第j个点对应x轴和y轴上的坐标;y=k1x+b1和y=k2x+b2分别为当前轮廓最小外接矩形对角线所在直线的方程,其中k1、b1和k2、b2分别为直线l1和l2需要拟合的系数。上下边沿轮廓获取示意如图6所示。

图6 上下边沿轮廓获取示意

Fig.6 Diagram of upper and lower edge contour

5)获取完全满足颜色和几何形状的轮廓。对每组管道中的每段轮廓上下边沿轮廓拟合直线,计算斜率绝对值之差,并据此做升序排序,检查每组轮廓第2个轮廓的斜率绝对值之差是否小于设定阈值。若小于阈值,则只保留该组前2个轮廓;若大于阈值则舍弃该组轮廓。至此获得了N2组颜色和形状最佳的管道轮廓。

经过以上5个步骤的处理,管线定位的结果如图7所示,可以看出,经过将图像纵向分割,并融合了颜色和形状特征之后,管线被准确定位。

图7 不同颜色提取结果

Fig.7 Extraction results of different color pipelines

3 偏航角解算

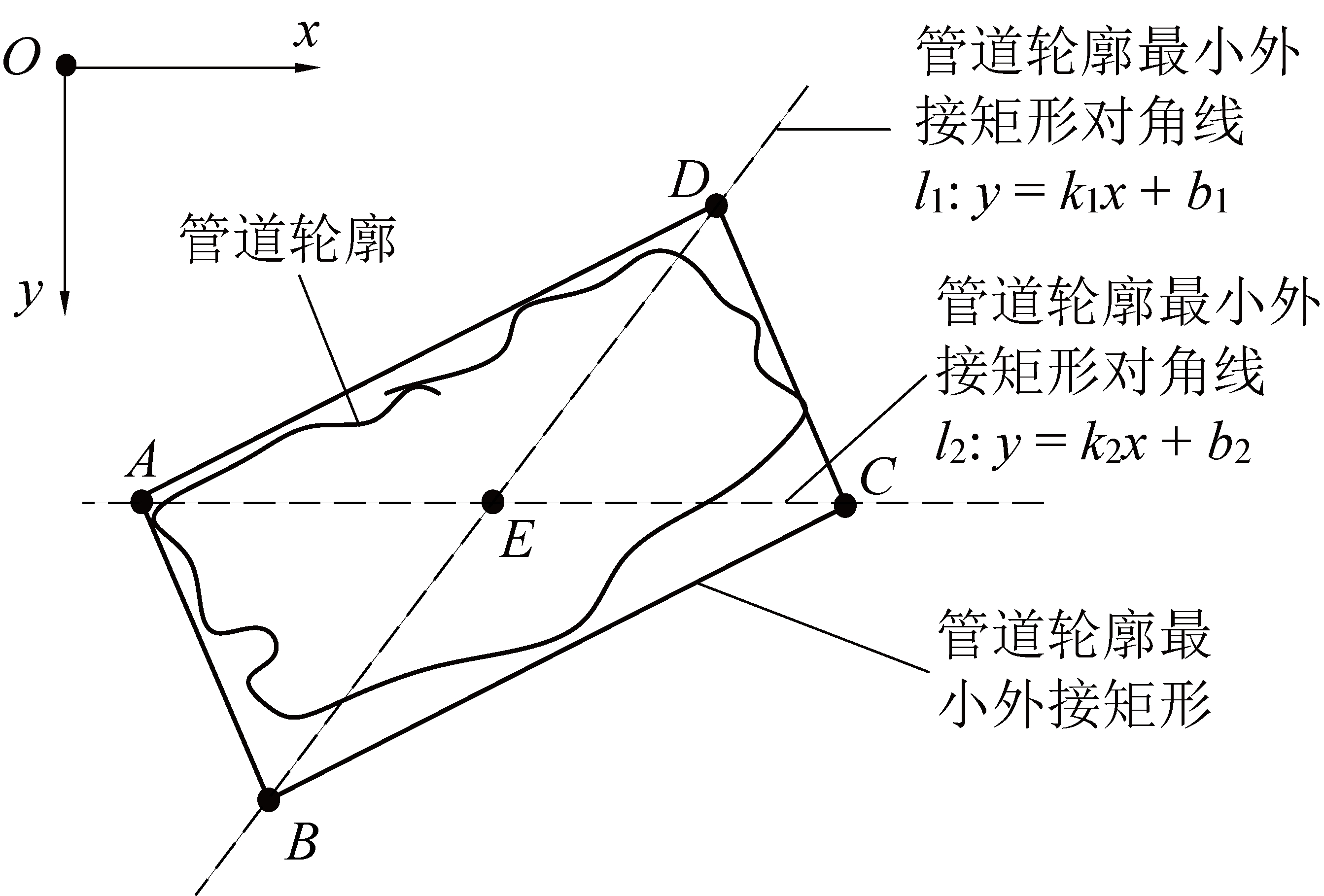

3.1 单目测距算法

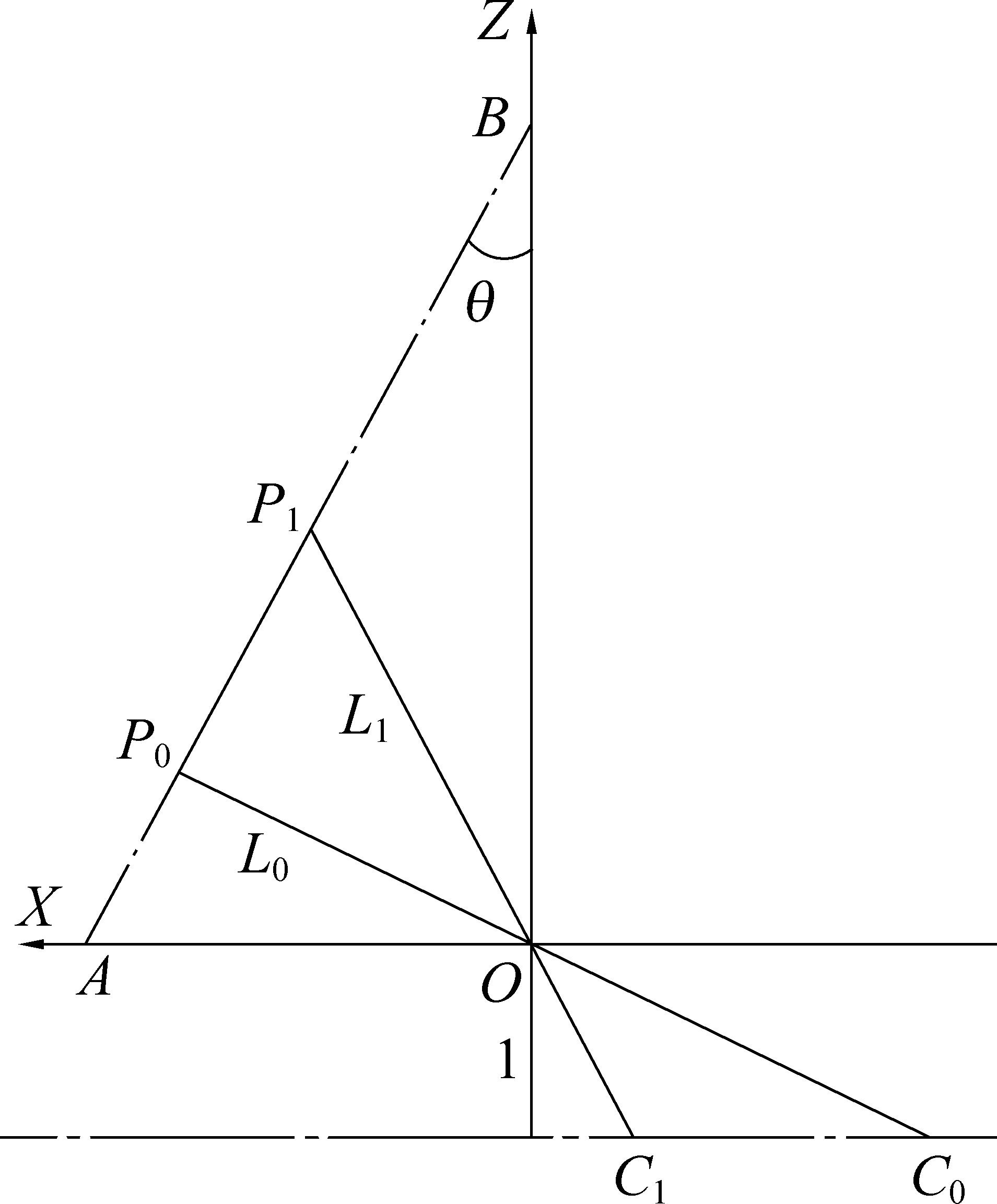

机器人在运动时,由于其搭载的云台具有自稳功能,云台相机坐标系的O-YZ平面能够始终平行于管线架设的平面,不存在绕相机光轴的旋转,所以如图8所示,根据相机针孔成像模型[19],能够求解管线轮廓中心到相机光心的距离L。假设某段轮廓对应的管道直径为D,并且其在相机归一化平面上的直径为d,则L为

图8 单目相机针孔模型

Fig.8 Pinhole model of single-view camera

L=D/d

(7)

3.2 偏航角解算

机器人偏航角解算示意如图9所示。在图9中机器人机载相机坐标系下点P0(X0,Y0,Z0)和P1(X1,Y1,Z1)为每组管道轮廓中2段轮廓的中心点;C0(xc0,yc0)和C1(xc1,yc1)为其在相机归一化平面上的投影;L0和L1分别为通过单目测距算法计算出的点P0和P1到相机中心的距离[20]。

图9 偏航角θ解算模型

Fig.9 Calculation model of yaw angleθ

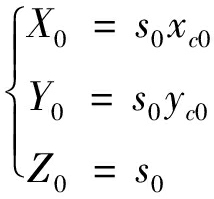

点C0在相机归一化平面上坐标缩放系数![]() 恢复到P0的坐标见式(8)。

恢复到P0的坐标见式(8)。

(8)

同理能够得出P1(X1,Y1,Z1)。在相机坐标系中,管线所在向量为![]() 取

取![]() 为相机光轴上单位向量,两者夹角为

为相机光轴上单位向量,两者夹角为![]() 然后得出每组偏航角θi,(i=1,2,…,N2)。

然后得出每组偏航角θi,(i=1,2,…,N2)。

(9)

其中:W为相机所采集图像的宽度。结合每组管线轮廓的检测结果,机器人相对于煤矿巷道的最终偏航角θ为

(10)

4 试验结果与分析

4.1 单目测距算法

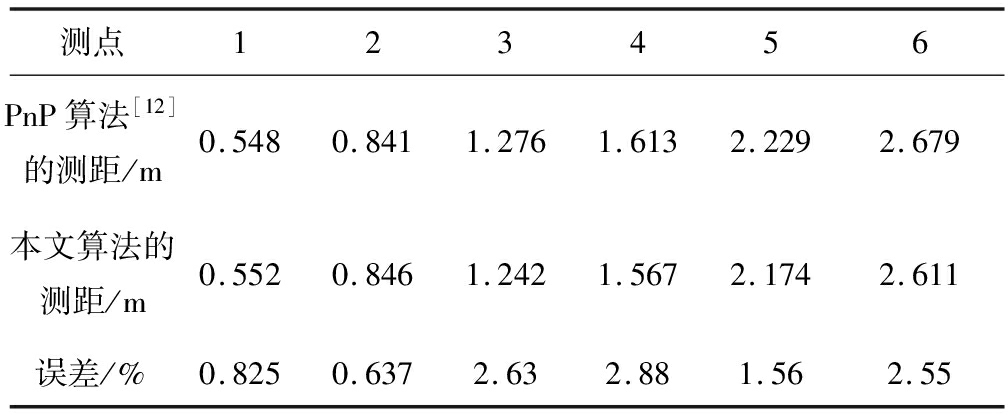

为确保文中单目测距算法的准确性,使用OpenCV ArUco检测图中的Mark,并分别使用PnP(Perspective-n-Point)算法[21]和上述算法计算Mark到相机中心的距离,结果见表1,2种算法存在一定误差,但误差率在允许范围之内,满足在该场景下应用要求。

表1 不同算法测距对比

Table 1 Comparison of distance measurement by different algorithms

测点123456PnP算法[12]的测距/m0.5480.8411.2761.6132.2292.679本文算法的测距/m0.5520.8461.2421.5672.1742.611误差/%0.8250.6372.632.881.562.55

4.2 偏航角度解算

在自动驾驶领域,自动驾驶汽车在巡航时能够根据车道线计算消失点来计算车辆同车道的相对夹角,反馈到控制系统实施矫正车辆的航向[22]。在巷道狭闭空间中,同样能够根据管道特征进行机器人与巷道的相对偏航角计算。对巷道场景图像应用第2节所提出的融合颜色与几何特征的算法进行分割,并标记出管线,结果如图10所示,可以看出分割准确,管线轮廓拟合效果良好。然后分别求取这2段管线在相机归一化平面的直径,运用单目测距算法解得管线中心到相机中心的距离。进一步使用偏航角解算算法,得到机器人的偏航角度,从图10可以看出偏航角度解算比较准确,能够准确反映机器人偏航角度的变化。

图10 不同情况下的偏航角度计算结果

Fig.10 Calculation results of yaw angle under different conditions

5 结 论

1)在煤矿巷道环境中,既使机器人搭载补光设备补充光照,在巷道光照良好的情况下,仅依靠颜色或者是几何特征,都达不到较好的管道分割效果。结合颜色与几何特征,并将图像纵向分割成多个独立的子图像,从每个子图像中获取候选管道轮廓,然后判断是否属于同一根管线进行轮廓分组,从每组候选轮廓中根据管线轮廓所拟合直线的平行程度进一步筛选出较为鲁棒和稳定的管线轮廓,试验效果显著。

2)在煤矿巷道中,由于管线架设的墙面平行于相机坐标系的O-YZ平面,不存在绕Z轴方向上的转动,可以在已知管线直径的情况下,采用相机模型使用三角形相似求解管线中心到相机光心的距离。

3)针对一根管线上不同的两段,提出的机器人偏航角解算方法,能够准确解算出机器人偏航角,通过测试验证能够满足实际机器人系统的辅助导航需求。

4)笔者将进一步研究在复杂背景及光照突变等情况下算法的鲁棒性,提升煤矿巷道机器人视觉辅助导航的实用性能。

致谢:感谢中国矿业大学信息与控制工程学院研究生郭雪亮、张俊对本文的工作!

[1] 袁 亮, 姜耀东, 何学秋, 等.煤矿典型动力灾害风险精准判识及监控预警关键技术研究进展[J].煤炭学报, 2018, 43(2):306-318.

YUAN Liang, JIANG Yaodong, HE Xueqiu,et al.Research progress of precise risk accurate identification and monitoring early warning on typical dynamic disasters in coal mine[J].Journal of China Coal Society, 2018, 43(2):306-318.

[2] TRUONG X, NGO T D.Toward socially aware robot navigation in dynamic and crowded environments:a proactive social motion model[J].IEEE Transactions on Automation Science and Engineering, 2017, 14(4):1743-1760.

[3] SHAIR S, CHANDLER J H, GONZ LEZ-VILLELA V J,et al.The use of aerial images and GPS for mobile robot waypoint navigation[J].IEEE/ASME Transactions on Mechatronics, 2008, 13(6):692-699.

LEZ-VILLELA V J,et al.The use of aerial images and GPS for mobile robot waypoint navigation[J].IEEE/ASME Transactions on Mechatronics, 2008, 13(6):692-699.

[4] PETRIU E M.Automated guided vehicle with absolute encoded guide-path[J].IEEE Transactions on Robotics and Automation, 1991, 7(4):562-565.

[5] NIU X, LI Y, KUANG J, ZHANG P.Data fusion of dual foot-mounted IMU for pedestrian navigation[J].IEEE Sensors Journal, 2019, 19(12):4577-4584.

[6] FERRO M, PAOLILLO A, CHERUBINI A,et al.Vision-based navigation of omnidirectional mobile robots[J].IEEE Robotics and Automation Letters, 2019, 4(3):2691-2698.

[7] VISIN F, ROMERO A, CHO K, et al.ReSeg:a recurrent neural network-based model for semantic segmentation[C].Computer Vision and Pattern Recognition, 2016:426-433.

[8] RANJAN A, HOFFMANN D T, TZIONAS D, et al.Learning Multi-human Optical Flow[J].International Journal of Computer Vision, 2020, 128(4):873-890.

[9] YU Z, WANG K, LI R, et al.The inter-frame feature matching and tracking of binocular vision based on the ORB-PyrLK algorithm[C].Chinese Control Conference, 2017:6922-6927.

[10] 李 健, 姜 楠, 宝音巴特, 等.空间颜色聚类算法及其在图像特征提取中的应用[J].吉林大学学报:理学版, 2020, 58(3):627-633.

LI Jian, JIANG Nan, BAOYIN Bate, et al.Spatial color clustering algorithm and its application in Image feature extraction[J].Journal of Jilin University:Science Edition, 2020, 58(3):627-633.

[11] 赵 磊, 张 文, 孙振国, 等.基于色彩分割及信息熵加权特征匹配的刹车片图像分类算法[J].清华大学学报:自然科学版, 2018, 58(6):547-552.

ZHAO Lei, ZHANG Wen, SUN Zhenguo, et al.Brake pad image classification algorithm based on color segmentation and information entropy weighted feature matching[J].Journal of Tsinghua University:Science and Technology, 2018, 58(6):547-552.

[12] 蒋华军, 蔡 艳, 李超豪, 等.基于改进Sobel算法的焊缝X射线图像气孔识别方法[J].上海交通大学学报, 2017, 51(6):665-671.

JIANG Huajun, CAI Yan, LI Chaohao, et al.Recognition method for gas pores on X-Ray image of lap joints based on the improved Sobel algorithm[J].Journal of Shanghai Jiao Tong University, 2017, 51(6):665-671.

[13] 刘晓玉, 王欢欢.光照不均匀钢坯缺陷图像的二值化方法[J].控制工程, 2018, 25(12):2147-2152.

LIU Xiaoyu, WANG Huanhuan.Non-uniform illumination and binary processing of billet defect detection[J].Control Engineering of China, 2018, 25(12):2147-2152.

[14] 娄联堂, 何慧玲, 石胜平.基于局部处理的X射线图像裂纹缺陷自动检测[J].中南民族大学学报:自然科学版, 2020, 39(1):98-102.

LOU Liantang, HE Huiling,SHI Shengping.Automatic detection of crack defects in Xray image based on local processing[J].Journal of South-Central University for Nationalities:Natural Science Edition, 2020, 39(1):98-102.

[15] 林耀海, 杨泽灿, 张泽均.结合图像和图形特征的原木轮廓识别[J].福建农林大学学报:自然科学版, 2020, 49(3):412-417.

LIN Yaohai,YANG Zecan,ZHANG Zejun.Outline extraction of logs cross section base-upon both image and graphics features[J].Journal of Fujian Agriculture and Forestry University:Natural Science Edition, 2020, 49(3):412-417.

[16] LI J, SU J, ZENG X.A solution method for image distortion correction model based on bilinear interpolation[J].Computer Optics, 2019, 43(1):99-104.

[17] PABLO Arbeláez, MAIRE M, FOWLKES C, et al.Contour detection and hierarchical image segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5):898-916.

[18] ZHANG Z, LI S, YAN X, et al.A linear programming based approach for composite-action Markov decision processes[J].Rairo Operations Research, 2019, 53(5):1749-1761.

[19] LIU M, ZHANG X, ZHANG Y, et al.Calibration algorithm of mobile robot vision camera[J].International Journal of Precision Engineering and Manufacturing, 2016, 17(1):51-57.

[20] WANG H, KANG X, YU Y, et al.Nighttime pedestrian ranging algorithm based on monocular vision[J].Cybernetics and Information Technologies, 2016, 16(5):156-167.

[21] WANG Q, SHI L.Pose estimation based on PnP algorithm for the racket of table tennis robot[C].Chinese Control and Decision Conference, 2013:2642-2647.

[22] KORTLI Y, MARZOUGUI M, BOUALLEGUE B,et al.A novel illumination-invariant lane detection system[C].2017 2nd International Conference on Anti-Cyber Crimes(ICACC), 2017:166-171.