0 引 言

在自然场景中,人类视觉系统在感知场景时往往不是一蹴而就地全面把握,而是首先聚焦视觉画面的主要部分,即显著目标,然后根据显著目标先验知识的导向,通过联想机制实现对整个场景的理解和认知。因此,国内外相关研究机构和人员研究表明基于视觉注意机制的显著目标的检测和提取是一种有效模拟人类视觉感知和认识机理的方法,也是计算机视觉领域中有关视觉图像处理、场景感知、认知相关研究内容中的重要组成部分。目前,基于显著性检测和提取的成果广泛应用于基于计算机视觉图像领域的相关方向,如基于视觉内容的图像检索[1]、图像视频压缩[2]、目标检测[3]、目标识别[4]、场景感知和理解[5]等。因此,在复杂场景中基于视觉注意机制的显著目标的检测和提取研究意义重大。在煤矿井下场景中,为保证煤矿工人的生命安全,以及实现对井下作业场景中关键设备目标状况的实时动态监控,目前相关煤矿企业在煤矿作业场景中广泛引进了视频监控系统,一定程度上形成了“可视化远程干预性智能采煤控制系统”。在井下集控中心以及矿井地面实现了针对综采工作面复杂场景的可视化远程监控。但是随着智能化无人开采进程的推进,围绕井下关键设备目标对象的视觉智能感知需求日益增强。井下复杂场景中,特别是生产工况的综采工作面,人员及设备目标频繁交错呈现,基于监控视觉画面实时检测、提取井下作业人员、关键设备目标对象,对实现井下关键设备目标对象的动态视频监控、生产场景智能感知安全生产管理意义重大。因此需要基于视觉注意机制针对可视化监控视频图像进行显著目标的实时检测和提取,例如针对井下人员,及关键设备目标对象的实时检测和提取,以便后续进行基于视觉内容的分析处理,实现围绕关键目标对象的实时动态监控,场景智能感知和安全生产管理。在视觉图像画面中,显著性表现为视觉特殊性、稀缺性以及奇异性,并且是由颜色、梯度边缘、纹理等视觉特征共同作用所致。其具体定义为:显著性就是在某个场景中,某事物个体与其周围环境的对比度即差异性。一般情况下,理想显著目标的检测和提取应满足以下3个标准:① 在显著目标检测过程中,显著目标应该是被准确定位在场景中具有相对突出颜色辨识度的位置,理想情况下应遵循人类面对繁杂场景感知时对突出颜色个体的聚焦规律;② 显著目标的提取应该相对比较完整地从背景区域中分离出来,无论场景是简单还是繁杂,都能够尽可能完整地保留其固有的特征信息,例如完整的目标外轮廓形状及局部纹理特征,使得提取的显著目标可以方便后续处理,以及更高层次应用;③ 从时效性上来说,显著目标的检测和提取过程应该越快越好,因为这是从后续实时应用需求的角度出发考虑的。

因此,从显著目标检测和提取效率角度出发,特别是基于视觉注意机制针对煤矿井下可视化远程监控视频图像进行显著目标检测和提取的实际工程应用需求考虑,在分析图像视觉特征的基础上,特别是煤矿井下图像视觉特征,提出一种基于随机采样区域对比度计算(Random Sampling Region Contrast,RSRC)的实时显著区域和目标提取方法。在显著性检测过程中,首先在图像全局颜色空间中进行量化,然后对原图像像素进行随机采样,使用随机采样后的图像进行区域分割;然后构建各个区域的颜色直方图,计算区域对比度获得区域显著性;最后基于背景先验知识对区域对比度进行修正,并使用引导滤波生成全分辨率显著图,实现显著性的实时检测。在显著目标分割过程中,提出一种自适应的前景、背景阈值迭代方法,基于Shared Sample Matting[6]方法实现显著目标的实时分割提取。通过公共图像集实验测试分析表明,该提取方法在提高显著目标检测和分割精度的同时,进一步提高了算法的实时性,可以满足实际工程应用需求,为井下复杂环境场景中关键设备目标对象的实时智能感知应用奠定基础。

1 显著目标检测、提取研究现状

有关视觉图像显著目标检测和提取,目前在非煤领域研究者开展了广泛的研究,提出了许多具有代表性的显著目标检测和提取方法。这些方法主要分为生物驱动模型与数据驱动模型两大类。

生物驱动模型最早由KOCH等[7]提出,后来由LTTI等[8]定义了图像显著性,提出了基于生物视觉注意机制的显著性区域检测方法(IT)方法。这种方法是利用颜色、边缘、方向等图像低层特征,通过多尺度高斯差分方式计算显著性。HAREL等[9]提出(Graph-based,GB)方法,其利用IT方法构建特征图,采用基于图像统计的归一化方法,实现显著性计算。GOFERMAN等[10]和WANG等[11]通过构造图像单元,计算图像单元间的差异来检测显著性(Context-Aware,CA)。这种方法体现了良好的全局特性,检测效果有明显提升,但其运用多尺度图像金字塔进行融合,计算复杂度高,运行缓慢,只适合在低分辨率图像上进行显著性检测提取。程明明等[12]在2011年提出区域对比度的显著性检测方法(Region Contrast,RC),其通过图像颜色区域高效计算区域对比度获取图像显著性。但是,在RC方法中的图像区域化和颜色空间转换过程需要很大的计算资源,其检测时间无法达到实时要求,在下一步显著目标分割过程中所占用的计算处理时间更长。

基于数据驱动模型的方法,其中一部分是利用图像的局部特征进行计算处理,例如ACHANTA等[13]使用图像在多尺度空间中图像子区域的像素平均特征向量与近邻的像素平均特征向量的差来表征图像的局部显著性值(Average Contrast,AC)。这种方法虽然输出全分辨率图像,但是显著检测精度相对较低,而且运行效率也低。LI[14]等人通过构建超图并在超图中检测显著点和边来实现显著目标检测,其充分考虑了各个像素点或者区域与其周围的关联关系。LIN等[15]首先通过学习获取中层特征来表示图像的局部信息,然后通过滤波器得到多尺度、多级显著图,最后通过视觉先验知识指导得到最终的显著图。另一部分方法是利用图像的全局特征进行计算处理,例如HOU等[16]提出的:Spectral Residual(SR),这种方法虽然计算效率有很大提升,但是检测结果的精度不够。LIU等[17]提出了一种监督的视觉注意区域检测方法,在图像高斯金字塔中通过线性结合比较来得到多尺度下的局部区域对比度,同时利用中心-周边直方图以及颜色空间分布的平均值定义显著目标。这种方法由于在多尺度下获取局部区域对比度,因此其处理效率也很难达到实时性。同样,程明明等[2]利用量化全图像素数量,通过直方图对比度来计算显著性(Histogram Contrast,HC)[12]方法也属于基于数据驱动的模型,其在实现过程中利用视觉图像的全局特征进行计算处理的。

近年来许多方法在显著性计算和处理过程中同时考虑图像的局部特征和全局特征。在国内,2013年唐勇等[18]提出一种基于图像单元对比度与空间统计特性的显著性区域检测方法(Cell Contrast and Statistics,CCS)。CCS方法与单独采用局部特征相比,提升了运行效率,检测结果更加清晰,同时提高了检测精度。郭迎春等[19]提出了一种基于颜色空间的局部特征和区域特征的显著性检测方法。这种方法在获得显著目标对象边缘的同时,将显著特征与显著目标的边缘信息进行融合获取最终显著目标。在国际上,PERAZZI等[20]考虑颜色独立性与颜色分布对图像显著性的贡献,从而把两者相结合提出SF(Saliency Filters)方法。SF方法采用高斯滤波加速,得到很不错的检测效果,但是其在显著性计算过程中采用滤波器实现,需要设置参数过多,导致处理速度达不到实时性需求。YILDIRIM等[21]提出一种快速的显著检测方法FASA(Fast Accurate and Size-Aware)。这种方法主要使用颜色特征和空间位置信息,通过统计学模型来计算显著性的概率,最后结合全局颜色对比来获得最终显著性。该方法虽然处理速度很快,但是其牺牲了显著性检测精度和准确性。

因此,在复杂场景中,基于视觉注意机制的显著目标检测和提取具有很大的研究潜力,特别是基于数据驱动模型综合考虑图像全局与局部特征的相关方法。近年来显著性检测无论在精准度方面还是召回率方面都有了明显的提高,而且处理速度方面也有了一定程度上的提升。但是,利用显著性检测结果进行显著性目标的分割提取过程往往计算程度相对复杂,一般在没有人工干预情况下,其处理速度在某种程度上很难达到实时应用需求[22-23]。常用的显著目标分割提取算法例如Saliency Cut [24]方法,该方法是基于 Grab Cut[25] 改进而来,通过迭代应用Grab Cut来改善二值化显著图然后进行分割处理,其运算复杂度很高。基于此,在显著性检测中引入随机采样策略,在保证显著性检测精度的前提下提高了计算效率。在显著目标分割提取过程中,提出一种自适应的前景、背景阈值迭代方法。分割过程基于Shared Sample Matting[6]在无需人为交互的情况下实现显著目标的实时分割,实现显著目标的端到端连贯性实时分割提取。

2 基于随机采样区域的实时显著性检测

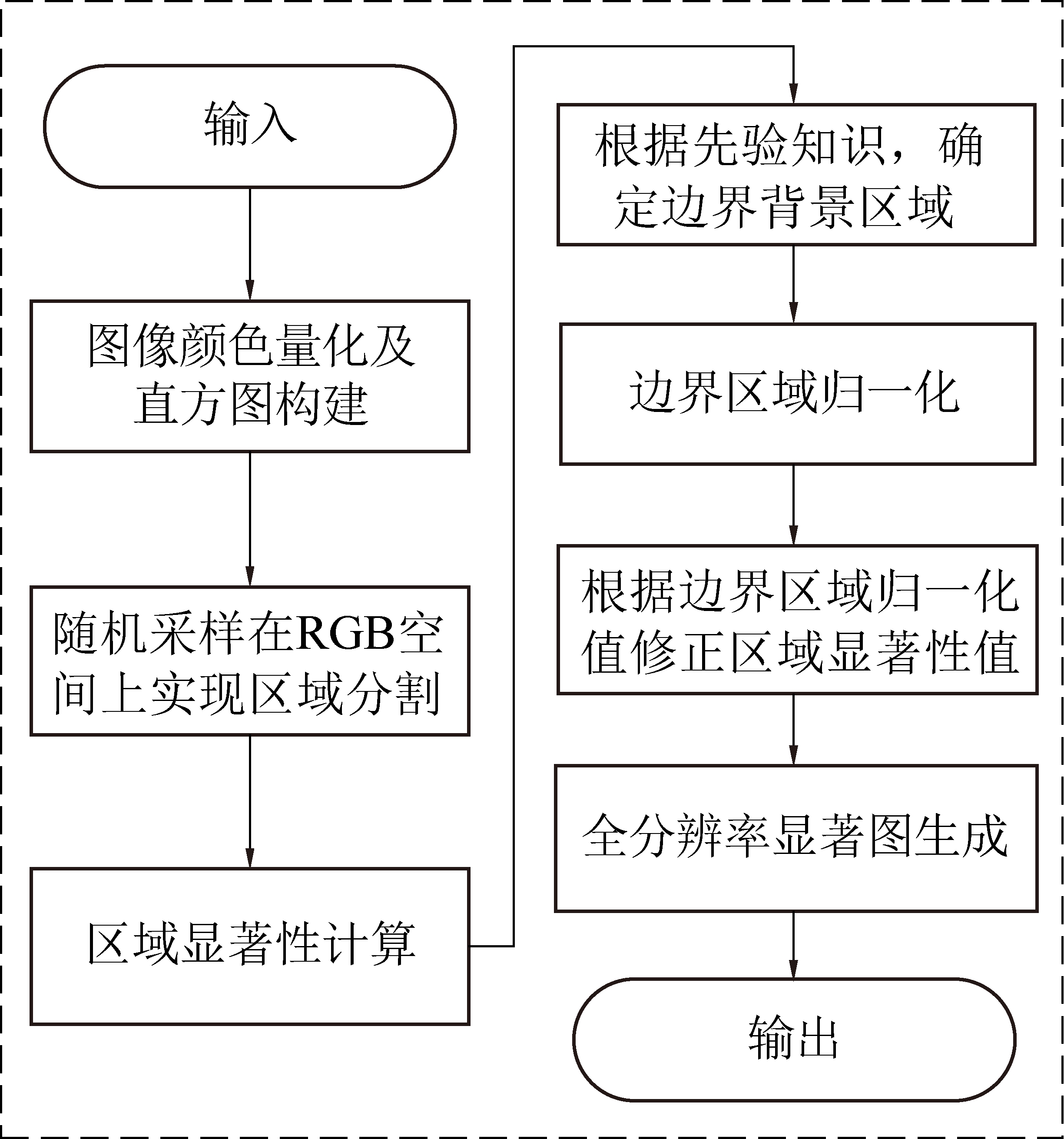

显著目标提取的首要任务是显著性检测。本文在分析图像视觉特征的基础上,特别是煤矿井下图像视觉特征,提出一种基于随机采样区域的实时显著性检测方法,其算法流程如图1所示。

图1 显著性检测流程

Fig.1 Flow of saliency detection

基于随机采样区域的实时显著性检测方法的具体流程为:①对输入原图像进行颜色量化减少图像中像素颜色类别数目;②对量化后的图像进行随机采样;③利用Efficient Graph-based Segmentation(EGS)[26]算法进行 RGB 颜色空间上的区域分割;④基于区域颜色对比度计算获取各区域的显著性;⑤利用边界背景先验知识计算边界区域的归一化值;⑥基于边界区域的归一化值修正区域的显著性值;⑦使用Fast Global Smoother(FGS)[27]算法平滑区域显著性图生成全分辨率显著图。

2.1 图像视觉特征分析及颜色空间量化

一般地,对于256 种颜色特征类别的三通道彩色图像,其颜色直方图中color bins的数量有16万个左右,即原图像中包含大约 16 万种颜色。这种现实情况加大了基于颜色特征图像处理算法的计算负担。同时在分析煤矿井下图像视觉特征过程中发现,井下图像颜色信息相对比较突出,颜色类别相对单一,而且各颜色类别之间的差异也不大。

因此首先通过颜色量化方法来减少原图像中颜色种类数量,将原图像中不重要且具有高相似度的颜色合并为同类颜色以减少颜色的种类。这样可以减少算法计算复杂度,提高处理效率。为保证量化后的颜色种类均匀分布,每个颜色通道划分为8个等级,最终将颜色空间量化为83种不同类别。颜色量化操作在RGB颜色空间上进行,但是为了颜色类别距离计算与人类感知更为相似,颜色类别距离计算是在图像的L*a*b*颜色空间上进行。

2.2 随机采样的区域分割和对比度计算

根据人类视觉系统感知场景过程是基于颜色块信息进行处理的相关机理,利用图像区域块进行对比度计算实现视觉显著性检测。由于目前常见图像区域分割方法,如SLIC超像素分割[28],MeanShift方法[29]等,计算复杂度较高,增加显著性检测整个过程的处理时间。因此在分析图像视觉特征的基础上,提出一种随机采样的区域分割方法,针对图像进行区域分割,提升区域分割过程的计算处理效率。

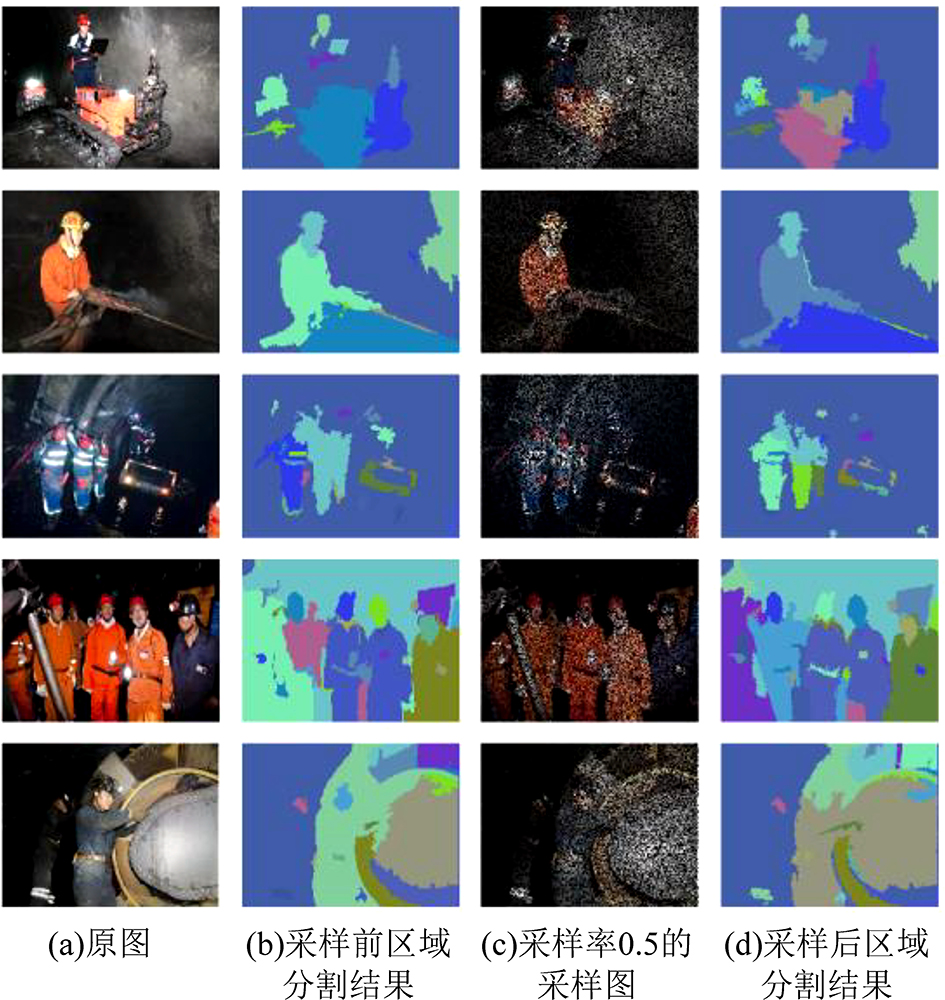

按不同的随机采样率,针对非煤图像和煤矿井下图像上进行采样,统计区域分割结果以及算法的实时性相关情况进行分析。首先对比随机采样前后图像的区域分割结果,同时统计二者的均值绝对值误差(Mean Average Error,MAE),以及区域分割过程所消耗的时间,统计情况如图2所示。

图2 随机采样率与MAE,及区域分割消耗时间曲线

Fig.2 Random sampling rate and MAE curve,Random sampling rate and region segmentation time consuming curve

从图2中可以看出,当随机采样率为0.5时,区域分割结果的误差为0.15左右,同时其消耗的时间降低为未使用随机采样(即全部图像像素参加区域分割)时的1/10。同时,在采样率为0.5时,随机采样前后的图像区域分割可视化效果如图3所示。

图3 随机采样前后的图像分割效果

Fig.3 Source images and segmentation results before and after random sampling

图3a、图3b分别为原图及其区域分割结果图,图3c、图3d分别为随机采样率为0.5情况下的采样图及其区域分割结果图。从原图和随机采样图中可以看出,当随机采样率为0.5时,由于煤矿井下图像背景中黑色区域较多,随机采样后的图像仍然保留了足够多的颜色信息和目标对象轮廓信息。从原图的区域分割结果图和随机采样图的区域分割结果图中可以看出,二者图像的分割结果效果图明显差异不大。可以看出,按照合适采样率进行随机采样,一定程度上可以在不影响图像颜色特征聚类计算的情况下实现区域分割,特别是煤矿井下场景的视觉图像。因此,选择合适的采样率,对随机采样后的图像进行区域分割,可以在保证区域分割精度的前提下提高区域分割的实时性。

基于随机采样的区域分割过程具体为,首先对原图像基于随机采样策略进行采样,然后利用快速分割算法EGS[26]将图像分割成若干个不同的初始区域,再将未采样到的图像像素点归并到最邻近的初始分割区域中。最后在区域分割的基础上,计算区域与其他所有区域的对比度获得区域的显著性值Sc(ri),定义如下:

(1)

其中,Rrand为随机采样分割的所有区域;ω(ri)为区域ri中包含的像素值,用于强调较大区域的对比度;ri为要计算的当前区域;rj为除了自身外的区域;ω(ri,rj)为区域的空间位置信息权重,可以强化相邻区域和削弱较远区域对当前区域显著性的影响程度,表示如下:

(2)

式中:Cs为空间位置信息权重的归一化因子,用来控制空间位置信息权重的作用效果;De(ri,rj)为区域之间的距离,即2个区域重心之间的距离。

式(1)中Dr(ri,rj)为2个区域之间的颜色距离表征,具体表示如下:

(3)

式中:m、n分别为区域ri和rj内的颜色数目;Dclr(c1,i,c2,j)为在颜色空间上2个区域中的2种颜色之间的距离;f (ck,l)为在第k个区域中第l种颜色在该区域内出现的概率,k={1,2},l={i,j}。

2.3 基于背景先验的区域对比度修正

区域显著性值反映当前区域在全局区域中的相对突出程度,即当前区域与其他区域的对比度。但是在复杂场景下,原图像背景中往往会包含一些分散的相对突出的小块区域,从而使得这些小区域块在结果显著图中具有较高的显著性值。另外,对于一些不规则形状的区域,在计算对比度过程中,由于使用图像像素坐标的平均值计算区域的重心,这样计算获得的区域重心往往与实际重心可能不一致,导致最终获得的显著性值与实际情况具有一定的偏差。

针对上述问题,为在全局范围内更加相对突显实际的显著目标,基于边界区域为背景区域的一般现实假设,利用“位于图像边界的像素极有可能为背景像素”的先验知识来进行修正优化图像的全局显著性。在具体实现过程中,取20个像素宽度的边界部分,统计此边界属于各个区域的像素数目,同时计算此像素数目占所属区域像素数目的比例,作为此区域的归一化值,然后利用各个归一化值对各区域的对比度(即显著性)进行修正。背景先验权重ωb(ri)表示为

(4)

其中,Cb为控制边界背景先验权重的作用;p(ri)为区域的归一化值。最后进行区域的对比度(即显著性)修正,修正后的区域显著性表示为:

(5)

2.4 全分辨率显著图生成

在各区域对比度计算完成后,基于局部区域对比度计算获得的显著图中往往会出现前景目标边缘部分被淹没现象,导致不能够完整地将检测到的显著性目标从背景中分离出来。因此,需要使用原图像对显著性图进行滤波操作来获得最终的边缘轮廓清晰的全分辨率显著图。

针对显著图的平滑处理操作,采用FGS方法[27]将区域显著性映射为全分辨率显著性图。FGS算法具有线性复杂度、运行效率高和易调参等特点,同时这种方法可以在空间和亮度上完成滤波操作,很好地保持原图像中显著目标的边缘细节信息。FGS通过优化策略近似计算能量函数的最小值,表示如下:

(6)

其中,f ,g和u分别为输入图像、引导图像和输出图像;N为包含n的2个邻域的集合;λ为平滑参数;ωn,i (g)为引导图像中2个像素点n和i的相似性函数,定义为:

(7)

其中:σc为亮度参数。在实现过程中,设定λ2 = 10,σc2 = 3,并采用3次迭代优化能量函数。

FGS处理需要2个输入数据,即输入图像和引导图像,分别对应优化策略过程中的空间和亮度参数。在实现过程中,输入图像为灰度图,即前一步生成的显著性图,引导图像为原彩色图像。灰度显著图提供显著亮度信息,引导图完成空间上的边缘轮廓细节保持。通过上述FGS处理后生成全分辨率显著图,这样在全分辨率显著图中,原图像中显著目标的边缘细节得到很好保持。

3 显著目标实时分割提取

为实现显著目标的提取,需要基于显著性检测得到的显著图进行前景背景分割。一般情况下,对于给定的显著性灰度图,通过固定阈值二值化操作获得掩模图进行目标分割。但是,不同场景图像如果均采用固定阈值往往无法获得理想的二值化掩模图。因此,通常使用固定阈值得到一个包含前景区域、背景区域以及待求未知区域的三分图,前景区域和背景区域中的像素是确定的,这样就只需要确定未知区域中属于前景和背景的部分。采用Shared Sample Matting方法[6]可以确定未知区域中属于前景和背景部分,从而实现目标的分割提取。而三分图中未知区域面积占原图面积的比例直接影响Shared Sample Matting方法[6]的计算复杂度,三分图中未知区域面积占原图面积的比例越大,Shared Sample Matting方法[6]的计算复杂度就越高。对于对比度差异明显的显著图,在三分图生成过程中,如果前景阈值选取过高或背景阈值选取过低,得到的三分图中的未知区域面积占原图面积的比例就会增大,必然增加Shared Sample Matting[6]分割过程的计算复杂度。

因此,基于显著性目标分割提取的实时性需求,提出一种自适应确定前景阈值和背景阈值的方法,获取固定比例的高质量三分图,然后利用Shared Sample Matting方法[6]实现显著目标的实时分割提取。具体实现过程流程图如图4所示:① 构建显著图直方图;② 根据直方图的最大值和前景像素先验信息初始化前景阈值和背景阈值;③ 迭代更新前景阈值和背景阈值,直到三分图的未知区域占原图面积比率小于5%;④ 利用Shared Sample Matting方法[6]确定三分图未知区域中属于前景和背景的部分,实现显著目标的分割。

图4 显著目标实时分割提取流程

Fig.4 Flow of real-time salient object segmentation

在确定背景阈值的初始值过程中,通过统计分析显著性图的直方图获得像素数目最多的灰度值,将其作为背景阈值的初始值。由于RC[12]方法表明,在公开数据集MSRAS-10K[17]中,平均20%的像素属于显著性区域。因此,在前景阈值的初始化过程中,针对显著灰度值进行从大到小顺序排序,并统计各灰度值的累积像素数目,最终获得累积像素数目达到20%情况下的灰度值作为前景阈值的初始值。

在自适应确定前景阈值和背景阈值以获得未知区域最优的三分图的过程中,首先选取合理背景阈值和前景阈值的迭代步长,不合理的迭代步长可能错过最优的背景阈值和前景阈值。由于背景区域和前景区域在显著性图中的灰度值范围差别较大,因此前景阈值和背景阈值迭代更新时使用的步长并不相同。以显著图直方图的最大值为界,计算左右两侧像素数目的累积速度来确定前景阈值和背景阈值的迭代步长。一般情况下由于背景区域的像素灰度值所在范围小于前景区域像素的灰度值所在范围,因此前景阈值的迭代步长会大于背景阈值的迭代步长。经多次测试,本文中前景阈值步长为0.003,背景阈值步长为0.001。然后依次迭代更新背景阈值和前景阈值过程中计算三分图的未知区域。当未知区域面积占原图面积的比例处于较小范围(文中取值为5%)时迭代结束,获得未知区域最优的三分图。同时为了使显著目标分割的前景图轮廓较为平滑,采用膨胀和腐蚀操作处理每次迭代得到的三分图。这样膨胀处理后落在外面的区域设置为背景,在腐蚀区域内的部分设置为前景,其余的区域为三分图的未知区域。

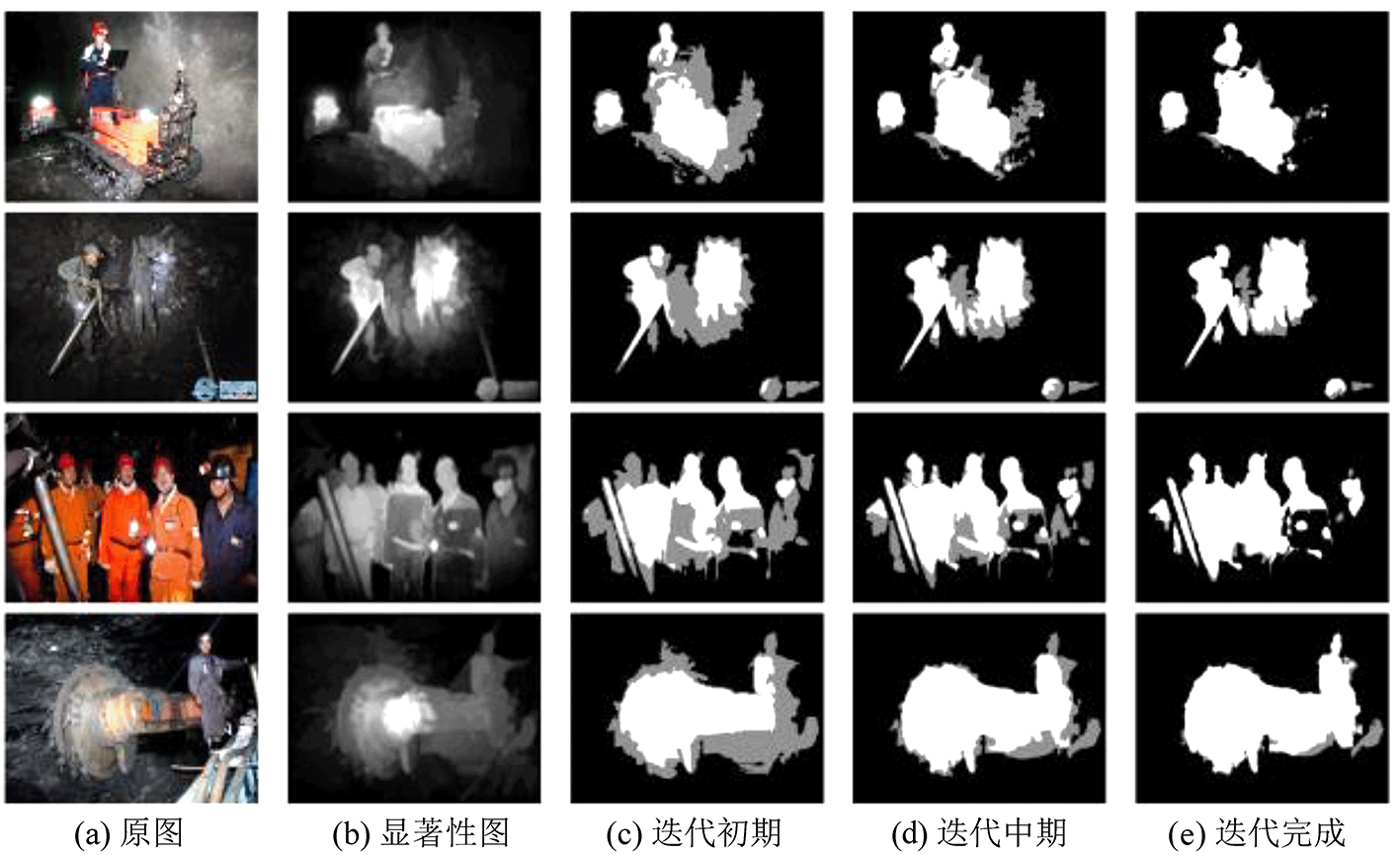

图5为有关井下视觉图像在前景阈值和背景阈值迭代更新过程中三分图的变化情况。迭代更新过程中,前景阈值和背景阈值在不断调整,三分图中未知区域的面积也逐渐减小并向显著性目标轮廓附近逐渐收缩。一般情况下,5次迭代就可以获到一个相对合理含有较优未知区域的三分图。

图5 显著性分割迭代过程中的三分图

Fig.5 Trimap of saliency segmentation during the iteration process

4 显著目标检测、分割提取实验

利用公开试验数据集,将文中提出的RSRC方法与目前流行的8种显著性检测算法进行实验对比分析,这8种方法分别为:Region Contrast(RC)[12],Saliency Filters(SF)[20],Maximum Symmetric Surround(MSS)[30],Fast Accurate and Size Aware(FASA)[21],Graph-based Manifold Ranking(GMR)[31],Hierarchical Saliency(HS)[33],Frequency-Tuned(FT)[34],Soft Image Abstraction(GC)[32]。上述8种方法作者已公开相应实现源代码,所有源码均使用C++实现。试验中硬件平台的CPU为Intel Core i5-3230M 2.6 GHz,内存为4GB。

4.1 数据集

试验过程使用的公开数据集为MSRA10K[17](10 000张)、THUR15K[35](15 000张)、ECSSD[33](1 000张)和DUTOmron[31](5 168张)。其中每个数据集中均含有原图和相对应像素级人工标注的Ground Truth显著图。

4.2 显著性检测量化比较

目前显著性检测算法的量化分析均利用Ground Truth显著图与相应检测结果进行对比评估分析。检测结果精确度衡量指标为:准确率、召回率及F-measure[34]。准确率P(Precision)和召回率R(Recall)的定义如下:

(8)

(9)

其中,TP(True Positives)为在相对应Ground Truth显著图中的显著性像素被算法实际正确检测为显著性的像素;FP(False Positives)为在相对应Ground Truth显著图中的背景像素被算法实际检测为显著性像素;FN(False Negatives)为在相对应Ground Truth显著图中的显著性像素被算法实际检测为背景像素。由于显著性检测方法得到的显著图是灰度图,而计算TP,FP及FN则需要二值化图,因此需要使用一个阈值T∈[0,255]分别将某个数据集对应的检测结果显著性图进行二值化分割,然后计算每张图像在[0,255]内的所有阈值对应的准确率-召回率,最后再得出该数据集的平均准确率-召回率(P-R)曲线。不同显著性检测方法在4个数据集上的P-R曲线如图6所示。

图6 4个不同数据集上的P-R曲线

Fig.6 P-R curves on four public datasets

从图6可以看出,本文RSRC方法的显著性检测精确度分别在MSRA10K[17]、ECSSD[33]和THUR15K[35]数据集上的表现都良好,明显优于其他8种方法。在DUTOmron数据集[31]上,RSRC方法只是在召回率低于70%的情况下,其准确率低于低于HS方法[33]。其中特别在MSRA10K[17]数据集上,RSRC方法在召回率小于80%区间上,其检测准确率达到90%左右。

为进一步评估分析显著性检测效果,引入Fβ 量化指标,Fβ 定义如下:

(10)

式中,β为用于调节准确率或召回率对最终结果的影响程度。

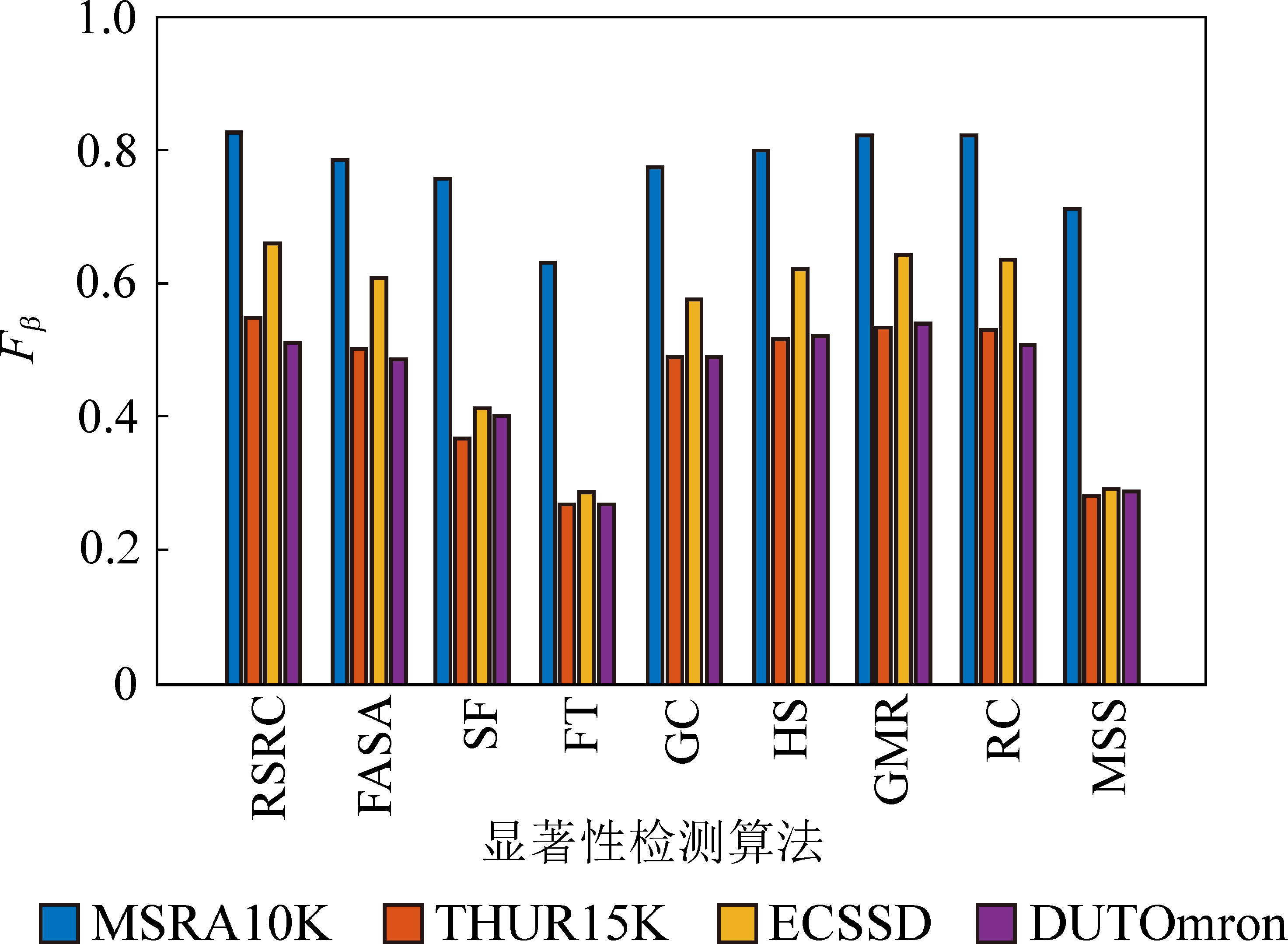

由于在实际应用中,准确率比召回率更加重要,因此通常采用β2 = 3强调准确率的影响程度来计算Fβ 。需要注意的是,准确率-召回率曲线是在[0,255]区间范围内计算得到,而Fβ测量则需要在一个固定阈值下进行统计计算。在本文实验中,采用与RC方法[12]类似的操作,使用召回率为90%时的阈值对显著图二值化处理后计算统计Fβ。不同显著性检测方法在四个数据集上实验得出Fβ,统计情况如图7所示。

图7 4个不同数据集上的Fβ 比较

Fig.7 Comparison of Fβ on four public datasets

从图7可以看出,本文RSRC方法的显著性检测精确度分别在MSRA10K[17]、ECSSD[33]、THUR15K[35]数据集上基于Fβ 评估标准的表现都明显优于其他8种方法;在DUTOmron[31]数据集上的Fβ评估表现略低于HS[33]方法;在MSRA10K数据集[17]上,RSRC方法的Fβ达到0.85以上。

4.3 显著目标检测实时性分析

同时针对显著性检测的实时性进行统计分析。在实验中各方法都是在基于C++代码实现,运行在相同实验硬件系统上,显著性检测过程消耗时间统计情况如见表1。由于在目前流行的8种显著性检测方法中,RC方法[12]和GMR方法[31]可以得到高质量的显著性图,以及FASA[21]方法具有较高的运行效率。因此,试验中重点比较分析RSRC方法,RC方法[12],GMR方法[31],以及FASA[21]方法的显著目标检测实时性。

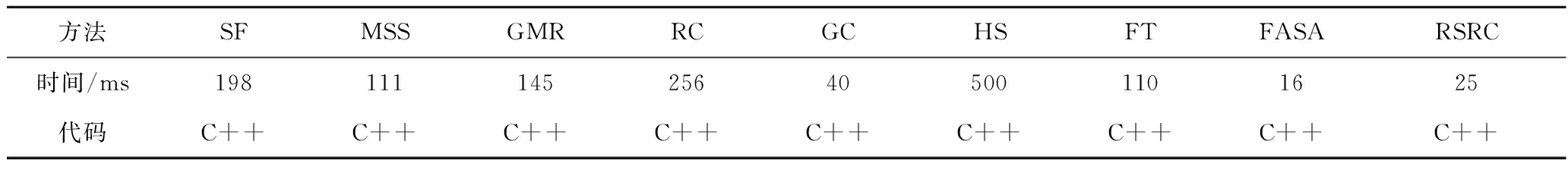

表1 各方法的显著性检测消耗时间统计

Table 1 The consumption time of saliency detection algorithms

方法SFMSSGMRRCGCHSFTFASARSRC时间/ms198111145256405001101625代码C++C++C++C++C++C++C++C++C++

如表1所示,对于自然场景图像,RC方法[12]消耗时间256 ms,GMR[31]方法消耗时间145 ms,FASA[21]方法消耗时间16 ms,RSRC方法的消耗时间为25ms;RC方法[12]的消耗时间几乎是RSRC方法的10倍。虽然RSRC方法消耗时间25 ms略长于FASA[21]方法消耗时间16 ms,但是从图6可以看出,RSRC方法检测的准确率明显优于FASA[21]方法。而本文RSRC方法的显著性检测过程消耗的时间25 ms可以满足工程应用的实时性需求。

4.4 显著目标分割结果比较

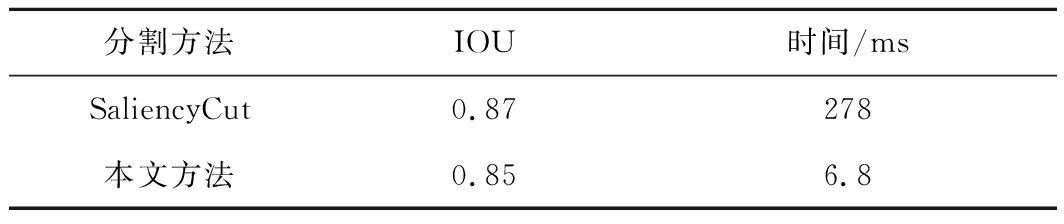

为了分析基于自适应确定前景背景阈值方法实现的显著目标实时分割提取结果,我们利用RC方法[12]中采用的Saliency Cut分割方法[24],在数据集MSRA10K[17]上随这2种分割结果进行比较分析。两种方法显著目标分割结果的可视化效果如图8所示。

图8 显著目标分割结果

Fig.8 Salient objet segmentation results

从图8的视觉效果来看,本文的方法与和SaliencyCut方法[24],在分割结果的效果上没有明显差异,且与Ground Truth之间的差异也很小。为进一步量化分析本文显著目标的分割效果,我们在整个数据集上分别统计两种方法得到的二值掩模图和Ground Truth之间的平均交并比值(Intersection Over Union,IOU)进行分割精度的比较分析,以及分割过程所消耗的时间进行实时性进行比较,情况见表2,其中IOU的定义为:

表2 分割方法的IOU值和消耗时间统计

Table 2 IOU value and time consuming of segmentation algorithm

分割方法IOU时间/msSaliencyCut0.87278本文方法0.856.8

(11)

式中:M为显著目标分割得到的二值掩模图;G为数据集的Ground Truth。

如表2所示,虽然本方法的IOU值只是稍微下降了0.02。但是本文法的消耗时间为6.8 ms,其分割提取效率几乎是Saliency Cut方法[24]的40倍。因此表明通过自适应迭代前景背景阈值获取较优的未知区域,利用Shared Sample Matting方法[6]实现显著目标的分割提取,在保证较好目标分割精度的同时提高了分割提取的效率。

5 煤矿井下关键目标对象实时检测提取

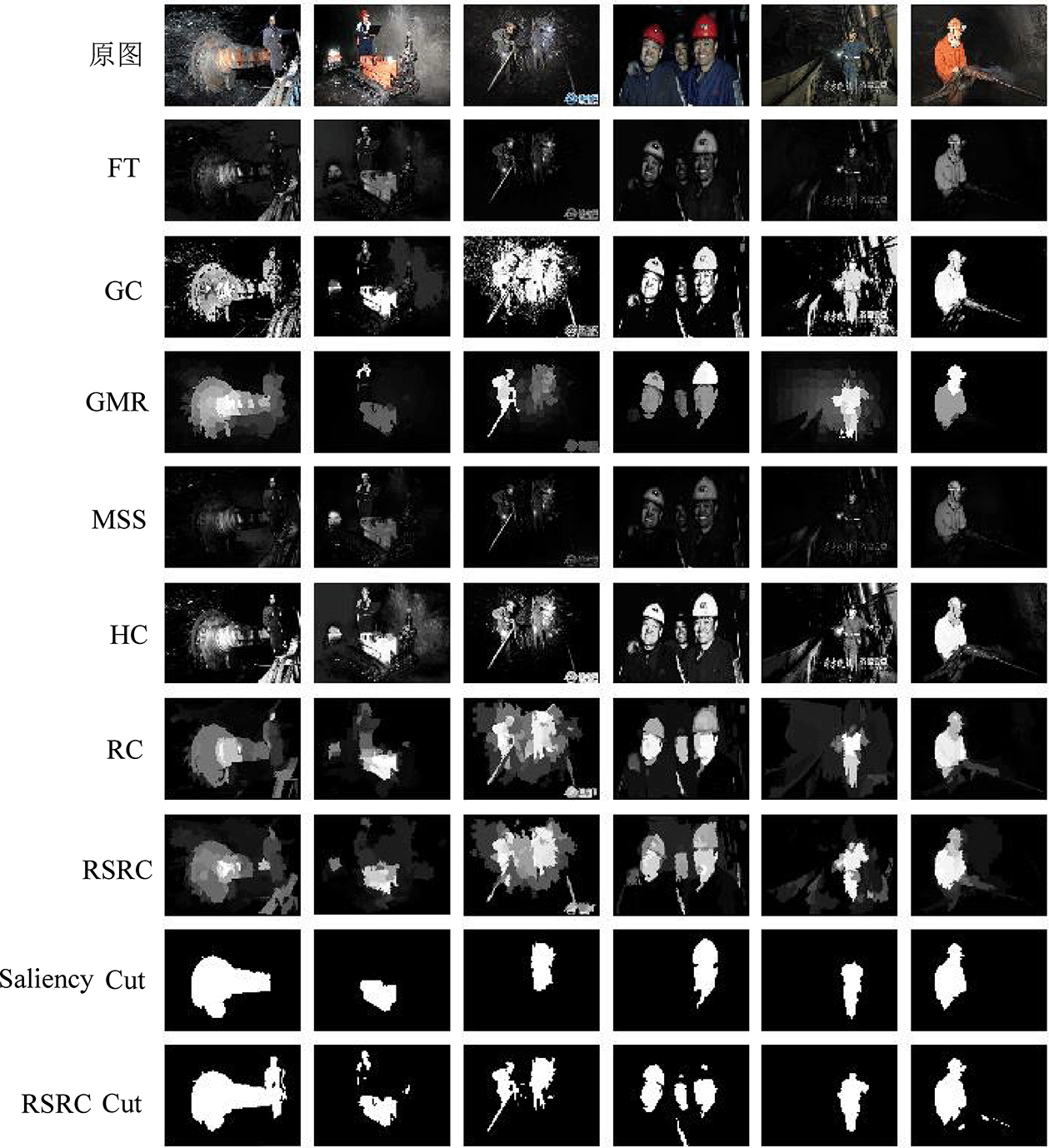

为进一步验证RSRC方法在煤矿井下场景中关键设备目标对象的实时感知应用效果,我们针对包含井下工作面常见关键目标对象的视觉图像,分别应用显著性检测方法FT[34]、GC[32]、GMR[31]、MSS[30]、HC[12]、RC[12],以及本文RSRC方法进行显著性检测,并对RSRC方法的显著性结果利用文中提出的分割方法和Saliency Cut分割方法[24]进行关键目标对象的提取,可视化结果如图9所示。

图9 煤矿井下场景关键目标对象的检测、分割提取结果

Fig.9 Saliency detection and segmentation results of salient objects in the coal mine underground

在图9中,第1行为原图,原图中基本涵盖了井下的关键设备目标对象,主要有井下人员、采煤机滚筒,及其它矿用设备的主要部件部分。第2行到第8行分别为显著性检测结果,即显著性图。第9行、第10行分别是基于本文RSRC方法检测结果利用Saliency Cut分割方法和该分割方法进行的显著目标提取的结果。与显著性检测方法GC[32]、GMR[31]、HC[12]、RC[12]相比较,本文RSRC方法成功检测到实际场景中的关键目标对象,如井下人员、采煤机滚筒等目标。与RC[12]相比,由于RSRC方法引入了随机采样策略,其显著性图中出现的一些孤立显著性块,在显著目标分割阶段被成功移除,如图9中第10行分割结果所示。正是由于引入了随机采样策略才使得RSRC方法在显著性检测阶段处理一幅图像的平均花费时间为25 ms,可以达到实时的应用需求。

同时,从图9第1行原图、第8行RSRC显著性检测结果、第9行Saliency Cut分割结果以及第10行RSRC Cut分割结果的可视化效果可以看出,基于同样的显著检测结果输入,该分割方法能够正确地分割提取出井下的多个关键目标对象,如井下人员、煤机滚筒等目标对象,而Saliency Cut分割方法提取结果中只有单个显著目标,无法成功分割提取出多个关键目标对象。虽然该方法在提取结果图中丢失了一些目标对象的细节部分,但是整个提取过程能够准确检测并成功分割出关键目标对象(显著目标)。

而且通过试验统计数据表明,该显著性检测、显著目标分割方法实现了30 FPS左右的处理速度,满足实际工程应用的实时性需求。

6 结 论

1)在显著目标检测过程中引入随机采样策略,对随机采样后的图像进行区域聚类实现区域分割,提高显著性检测过程的处理效率;在显著目标分割过程中,提出了一种自适应确定前景阈值和背景阈值获取较优三分图方法,在保证显著性检测和目标分割精度的前提下,达到了实时检测分割效果。

2)针对煤矿井下复杂场景关键设备目标对象进行检测获取实验验证,效果良好,可以为井下可视化远程监控视频图像的预处理,以及关键设备目标对象的智能感知应用提供技术基础。

3)本方法虽然可以满足煤矿场景以及非煤场景下显著目标的实时检测、分割提取需求,但是在显著性检测过程中由于引入了随机采样策略针对图像特征进行聚类实现区域分割,因此在图像目标纹理和轮廓特征不是很清晰的情况下,随机采样策略会弱化图像中的纹理和边缘轮廓特征,将会导致在显著性检测结果图中出现某些孤立的显著点。

因此,在接下来的研究过程中:① 进一步研究在纹理或轮廓之外的像素点区域进行随机采样,为区域的聚类处理提供无损原始像素值;② 针对煤矿井下关键设备目标对象视觉图像颜色和背景颜色区分度不大的现象,尝试使用新的区域颜色对比度量化方法来有效区分井下视觉图像中的不同区域,从而提高显著目标检测精度;③ 在消除孤立显著性点的基础上进一步提高显著性检测、目标分割精度,保证显著目标提取效果。

[1] 王向阳,杨红颖,郑宏亮,等. 基于视觉权值的分块颜色直方图图像检索算法[J]. 自动化学报,2010,36(10):1489-1492.

WANG Xiangyang,YANG Hongying,ZHENG Hongliang,et al. A color block-histogram image retrieval based on visual weight[J]. Acta Automatica Sinica,2010,36(10):1489-1492.

[2] HADIZADEH H,IVAN V Bajic. Saliency-preserving video compression[C]//In Proceedings of 2011 IEEE International Conference on Multimedia and Expo,Barcelona,Spain:IEEE,2011.

[3] 丁正虎,余 映,王 斌,等. 选择性视觉注意机制下的多光谱图像舰船检测[J]. 计算机辅助设计与图形学学报,2011,23(3):419-425.

DING Zhenghu,YU Ying,WANG Bin,et al. Visual Attention-based ship detection in multispectral imagery[J].Journal of Computer-Aided Design & Computer Graphics,2011,23(3):419-425.

[4] 王彦情,马 雷,田 原. 光学遥感图像舰船目标检测与识别综述[J]. 自动化学报,2011,37(9):1029-1039.

WANG Yanqing,MA Lei,and TIAN Yuan.State-of-the-art of Ship detection and recognition in optical remotely sensed imagery[J].Acta Automatica Sinica,2011,37(9):1029-1039.

[5] 张素兰,郭 平,张继福,等. 图像语义自动标注及其粒度分析方法[J].自动化学报,2012,38(5):688-697.

ZHANG Sulan,GUO Ping,ZHANG Jifu,et al.Automatic semantic image annotation with granular analysis method[J].Acta Automatica Sinica,2012,38(5):688-697.

[6] ESL. Gastal,MM. Oliveira.Shared Sampling for Real-Time Alpha Matting[J].Computer Graphics Forum,2010,29 (2):575-584.

[7] KOCH C,ULLMAN S. Shifts in selective visual attention:towards the underlying neural circuitry[J]. Journal of Human Neurobiology,1985,4(4):219-227.

[8] ITTI L,KOCH C,NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[9] HAREL J,KOCH C,PERONA P. Graph-based visual saliency[C]//Proceedings of the 2006 MIT Annual Conference on Neural Information Processing Systems. Vancouver,Canada:The MIT Press,2006:545-552.

[10] GOFERMAN S,ZELNIK-MANOR L,TAL A. Context-aware saliency detection[C]//Proceedings of the 2010IEEE Conference on Computer Vision and Pattern Recognition. San Francisco,USA,2010:2376-2383.

[11] WANG M,KONRAD J,ISHWAR P,et al. Image saliency:from intrinsic to extrinsic context[C]//Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Colorado Springs,USA:IEEE,2011:417-424.

[12] CHENG M M,ZHANG G X,MITRA N J,et al.Global contrast based salient region detection[C]//Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition,Colorado Springs,USA:IEEE,2011:409-416.

[13] ACHANTA R,ESTRADA F,WILS P,et al. Salient region detection and segmentation[C]//Proceedings of the 6th International Conference on Computer Vision Systems. Berlin,Heidelberg:Springer-Verlag,2008:66-75.

[14] LI X,LI Y,SHEN C,et al. Contextual Hypergraph Modelling for Salient Object Detection[C]//2013 IEEE International Conference on Computer Vision . Sydney,NSW,Australia,2013:3328-3335.

[15] LIN Yuetan,KONG Shu,WANG Donghui,et al. Saliency dete-ction within a deep convolutional architecture[C]//Proceedings of the AAAI Workshops at the Twenty-Eighth AAAI Conference on Artificial Intelligence.2014:31-37.

[16] HOU X D,ZHANG L Q. Saliency detection:a spectral residual approach[C]//Proceedings of the 2007 IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis,USA:IEEE,2007:1-8.

[17] LIU T,YUAN Z,Sun J,et al. Learning to detect a salient object[J]. IEEE Transactions on Pattern analysis andmachine intelligence,2011,33(2):353-367.

[18] 唐 勇,杨 林,段亮亮. 基于图像单元对比度与统计特性的显著性检测[J]. 自动化学报,2013,39(10):1632-1641.

TANG Yong,YANG Lin,DUAN Liangliang. Image cell based saliency detection via color contrast and distribution[J].Acta Automatica Sinica,2013,39(10):1632-1641.

[19] 郭迎春,袁浩杰,吴 鹏. 基于Local 特征和Regional 特征的图像显著性检测[J]. 自动化学报,2013,39(8):1214-1223.

GUO Yingchun,YUAN Haojie,WU Peng.Image saliency detection based on local and regional features[J]Acta Automatica Sinica,2013,39(8):1214-1223.

[20] PERAZZI Federico,KRAEHENBUEHL Philipp,PRITCH Yael. Saliency filt-ers:contrast based filtering for salient region detection [C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition,Providence,RI,2012:733-740.

[21] YILDIRIM G,SUSSTRUNK S. FASA:fast,accurate,and size-aware salient object detection [C].Proceedings of the 12th Asian Conference on Computer Vision,Singapore,November 2014,1-5.

[22] BORJI A,CHENG M M,JIANG Huaizu,et al. Salient object detection:A benchmark[J]. IEEE Transactions on Image Processing,2015,24(12):5706-5722.

[23] BORJI A,CHENG Mingming,JIANG Huaizu,et al. Salient obje-ct detection:A survey[J]. Eprint Arxiv,2017,16(7):3118.

[24] CHENG M M,MITRA N J,HUANG X,et al,Global contrast based salient region detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):569-582.

[25] ROTHER C,KOLMOGOROV V,BLAKE A.“Grabcut”- Interactive foreground extraction using iterated graphcuts[J].ACM Transactions on Graphics,2014,23(3):309-314.

[26] FELZENSZWALB P,HUTTENLOCHER D.Efficient graph-based image segmentation[J].International Journal of Computer Vision,2004,59(2):167-181.

[27] MIN D,CHOI S,LU J,et al.Fast Global Image Smoothing Based on Weighted Least Squares[J].IEEE Transactions on Image Processing,2014,23(12):5638-5653.

[28] ACHANTA R,SHAJI A,SMITH K,et al. SLICsuperpixels compared to state-of-the-art superpixel methods[J]. IEEE Transactions on Pattern Analysis And Machine Intelligence,2012,34(11):2274-2282.

[29] COMANICIU D,MEER P. Mean shift:a robust approach toward feature space analysis[J]. IEEE Transactionson Pattern Analysis and Machine Intelligence,2002,24(5):603-619.

[30] ACHANTA R,SUSSTRUNK S. Saliency detection using maxim-um symmetric surround[C]//Proceedings of 2010 IEEE International Conference on Image Processing,Hong Kong:IEEE,Sept 2010.

[31] YANG C,ZHANG L,LU H,et al. Saliency detection via graph-ba-sed manifold ranking[C]//Proceedings of the IEEE conference on computer vision and pattern recognition,Portland,:IEEE,June 2013:3166-3173.

[32] CHENG M M,WARRELL J,LIN W Y,et al. Efficient salient region detection with soft image abstraction[C]//Proceedings of the IEEE International Conference on Computer vision,Sydney,:IEEE,2013:1529-1536.

[33] YAN Q,XU L,SHI J,et al. Hierarchical saliency detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition,Portland:IEEE,2013:1155-1162.

[34] ACHANTA R,HEMAMI S,ESTRADA F,et al. Frequency-tuned salient region detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition,Miami,IEEE,2009:1597-1604.

[35] CHENG M M,MITRA N J,HUANG X,et al. SalientShape:group saliency in image collections[J]. The Visual Computer,2014,30(4):443-453.