0 引 言

近年来,随着大数据、云计算和人工智能的快速融合发展[1],以及相关软硬件研发的突破创新,煤矿智能化已经成为煤炭行业发展的重大战略方向[2]。而图像和视频作为煤矿智能化中智能感知要素[3],目前已逐渐应用于煤矿的日常生产活动中,在煤矿巷道机器人导航和地图构建[4]、三维可视化[5]、人员识别[6]、巷道视频图像拼接[7]等方面有着广泛的应用。使用煤矿巷道的图像进行图像拼接,获得巷道的全景图,是实现煤矿巷道的三维重建、可视化以及数字模型建立等方面研究的基础性工作。作为计算机视觉领域最经典的算法之一,图像拼接步骤一般包括[8]:图像预处理、图像配准、图像融合。其中图像配准是图像拼接的关键与核心[9],一般分为基于区域的配准方法和基于特征的配准方法,相较于基于区域的配准方法,基于特征的配准方法计算效率高、鲁棒性好、场景适应性强。对于基于特征的配准方法[10],图像配准的质量与图像特征匹配点精度息息相关。由于煤矿井下巷道场景复杂、光照不均衡,重叠区域特征点匹配错误率较高,对于经典的随机采样一致性RANSAC(RANdom SAmple Consensus)算法[11]及其改进融合算法[12-15],虽在一定程度上剔除了一些误匹配点,提高剔除结果的精度,但是误匹配点仍然很多,主要表现为受煤矿巷道复杂场景影响其特征点的描述子很相近,但相应匹配点在图像中的位置相差甚远,使得这些算法在煤矿巷道图像拼接中的实际效果较差。

文献[16]提出了一种基于图论的误匹配剔除方法,尽管其可以有效剔除误匹配点,但其模型复杂度高,实时性低;文献[17]使用点特征和线特征共同约束下的特征匹配,提高了影像的配准精度,但直线特征的带入增加了描述子复杂性,也使得该算法有一定的局限性;文献[18]引入了一种有向线段匹配方法,通过对特征点建立的有向线段进行线段特征描述与匹配,尽管有效提高了匹配正确率,但其增加了算法复杂性,但其构造有向线段辅助进行误匹配剔除的思路却值得借鉴。上述方法虽然有效地剔除了误匹配点,但却增加了模型和算法的复杂度,而煤矿巷道图像具有一定的像素数量,就使得算法实时性和鲁棒性较差。鉴于以上问题,为保证算法的实时性和鲁棒性;文献[19]利用图像匹配点之间的几何约束来剔除误匹配点,大幅简化了算法的步骤和复杂度,但是其仅仅考虑了匹配点之间连线的几何属性,不够全面,同时该算法对初始匹配点的要求较高,而煤矿巷道图像的初始匹配点误匹配点率较高,因此该算法不适用;文献[20]通过计算每对匹配点连线的斜率和长度,并定义标准分组边界SGB(Standard Grouping Boundary)对其进行分组,再定义置信椭圆边界CEB(Confidence Elliptical Boundary)剔除在椭圆边界外的离群点,以此剔除斜率距离大于阈值的匹配点对,该思路对本文也有一定的借鉴意义。鉴于以上问题,建立图像匹配点有向线段模型保证算法的实时性要求,同时引入图像内特征点有向线段模型,使得算法更加全面,更加有效剔除误匹配点。为不增加算法的复杂度,算法仅利用有向线段的固有属性方向(斜率)和长度来作为剔除误匹配的约束条件,使得算法的计算量,复杂度大幅降低,从而保证了算法的实时性和鲁棒性。尽管基于有向线段模型的误匹配剔除方法,使得匹配点的错误率有一定程度上的降低,但是却使得重叠区域的匹配点数量变少,又加上选取的图像具有一定的视差,致使最后的图形拼接结果易出现重影和投影失真[21]。面对以上问题,考虑到全局单应性矩阵在视差大的图像拼接的局限性,文献[22]提出了双平面的图像拼接算法,通过分别计算2个平面的单应变换,更好地配准图像;文献[23]进而提出了一种局部单应性对齐的APAP(As-Projective-As-Possible)算法,通过将图像网格化,对每个网格使用单应矩阵对齐,并提出了一套高效计算方法Moving-DLT(Moving Direct Linear Transformation),在一定程度上解决了图像重影和几何错位问题;文献[24]在APAP算法基础上,以局部单应矩阵为主,结合非重叠区域单应矩阵线性化和全局相似变换矩阵来约束图像变形,消除了投影失真现象,得到了观感更好的全景拼接图。文献[25]将图像超像素化,使用最优单应性使得每个超像素变形误差最小,并引入扭曲残差,使其自适应确定超像素区域的权重,但其对于大尺寸图像超像素区域较多,且每个区域参数较多,导致最后算法运行时间大大增加。

针对煤矿巷道复杂场景图像拼接,由于煤矿巷道图像光照不均衡,场景相似性较高,容易产生误匹配点,而且图像拼接对误匹配点比较敏感。因此,建立图像特征点的有向线段模型,使用有向线段的固有属性来剔除误匹配点,可以有效剔除场景相似性高但几何位置完全不同的图像匹配点和特征点,从而减少了误匹配点,之后建立图像网格模型,再结合利用得到的精匹配结果计算局部单应矩阵和全局相似变换矩阵,来约束网格变形,最终得到观感和效果更好的全景拼接图。

1 特征点有向线段的数学模型

特征匹配后得到的匹配点精度对图像配准及拼接的质量有着很大的影响。而对于特征匹配来说,一般情况正确匹配点在数量上是远大于误匹配点,因此剔除误匹配点对图像配准中依靠特征点求取图像变换模型有着很大的意义。使用SIFT算法和欧式距离匹配方法[26],得到n组粗匹配点对,并以此得到参考图像I1和待配准图像I2对应匹配特征点的齐次化坐标D1、D2。然后建立特征点的有向线段模型,对粗匹配点进行精匹配,获得质量和效果更好的匹配点。

1.1 有向线段模型的构造思路

在2张图像没有较大的尺度变化和旋转变换的情况下,将2张同尺寸的图像左右放置在一个窗口中,对图像间匹配点和图像内所有特征点建立有向线段模型。对于相邻有重叠区域的2张图像来说,其特征匹配点分布一般具有如下规律:①图像间对应特征点有向线段关系基本呈平行关系;②图像间对应特征点有向线段长度也基本分布在同一区间内;③参考图像特征点有向线段方向和待配准图像有向线段方向基本是相同的。

对于图像间匹配点有向线段模型来说,通常图像间的重叠区域是呈左右分布和上下分布,因此不会出现匹配点之间的连线为垂直情况,即该线段的斜率为正负无穷大的情况。所以可以统计对应匹配点连线的斜率,建立统计分布柱形图,取柱形图中斜率分布集中的区间作为剔除误匹配点的阈值区间。而线段的长度关系可以用距离的平均值来约束,给定一个区间来剔除不符合的匹配点。

对于图像内特征点有向线段模型来说,可以建立以特征点为原点的方向坐标系,以方向坐标系的四象限区域分为4个方向,以此作为有向线段方向匹配的量化指标。若一组有向线段方向不匹配,则将其2对匹配点都归于误匹配点中,待所有有向线段匹配完后,就得到所有匹配点对的误匹配点统计次数值。最后依靠误匹配点统计次数值来建立概率统计模型,剔除其中概率大对应的匹配点对,以此达到剔除误匹配点的目的。

1.2 图像间匹配点有向线段模型的建立

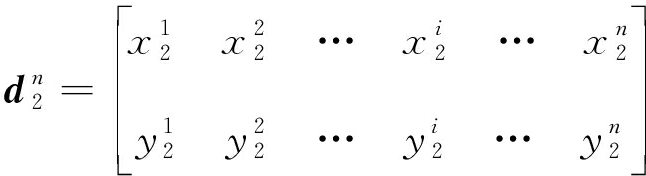

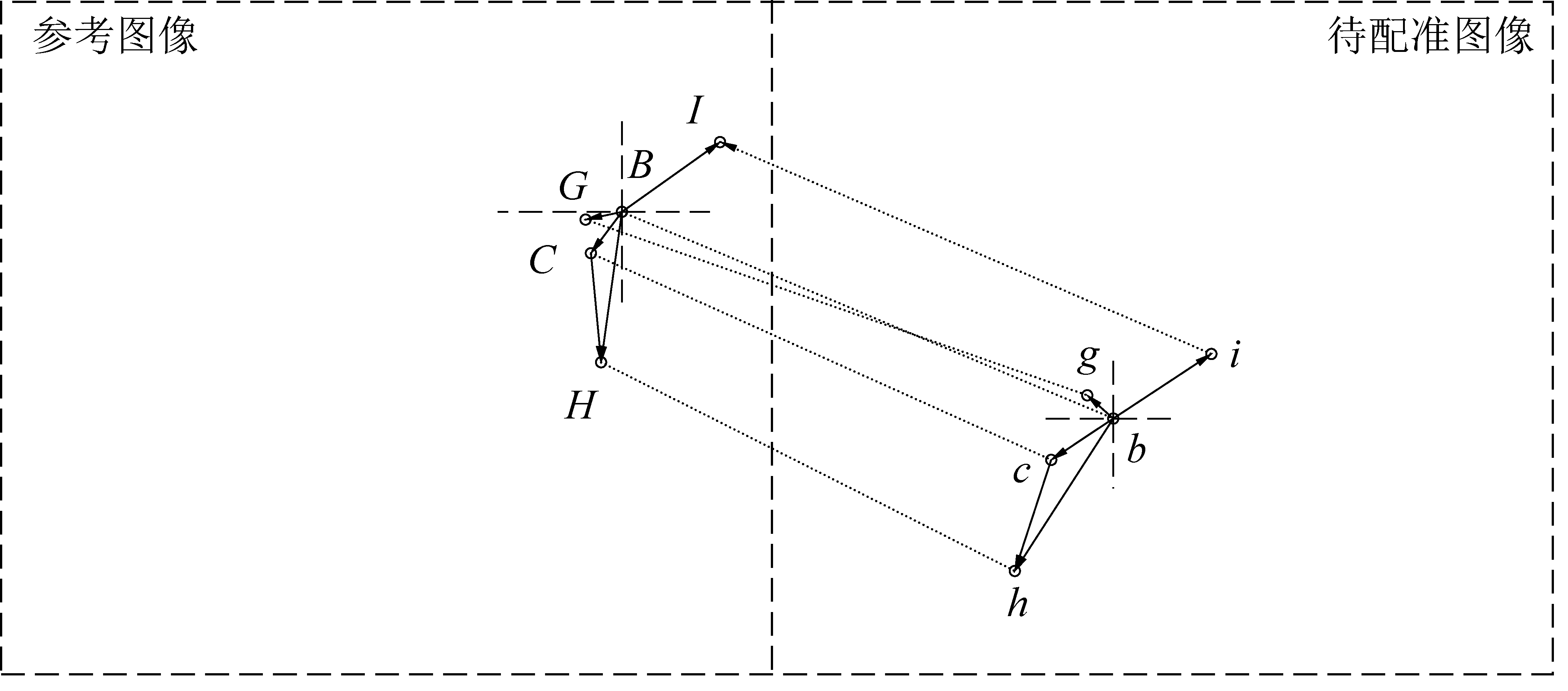

图像间匹配点有向线段模型如图1所示,其中[A,a]、[B,b]、[C,c]、[D,d]、[E,e]、[F,f]是图像特征匹配后得到的粗匹配点对,[B,b]、[C,c]是正确匹配点,其他的为错误匹配点。以图1为例,图像匹配点有向线段剔除误匹配点思路可简单概括为:以斜率阈值区间可以剔除[D,d]、[F,f],而长度约束即可剔除[A,a]、[E,e],达到剔除误匹配点的目的。而其数学模型的建立过程如下:

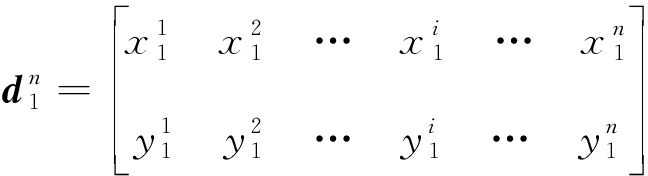

首先将2张图像左右放置在同一窗口中,已知n对粗匹配点对应的齐次坐标D1、D2,提取到对应特征点在原图像坐标系中的坐标数组![]() 为:

为:

(1)

(2)

其中:i∈(1,n)。由式(1)和式(2)可构造图像间匹配点有向线段模型:

(3)

图1 图像间匹配点有向线段示意

Fig.1 Schematic of directed line segment of matching points between images

图2 图像内特征点有向线段示意

Fig.2 Schematic of directed line segment of feature points in image

其中:Iw为图像的宽度,参考图像I1和待配准图像I2的尺寸相同,高都为Ih(对应坐标的y值),宽都为Iw(对应坐标的x值)。由式(3)可得,每一条有向线段斜率计算公式如下:

(4)

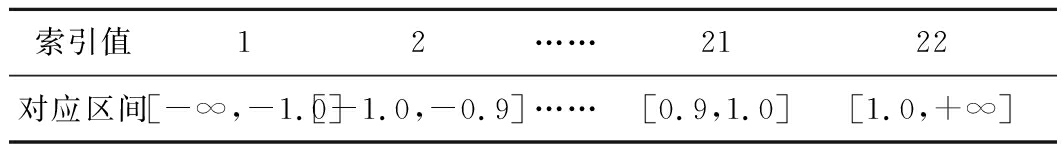

为准确找到斜率阈值区间,并根据图像匹配经验可知,图像匹配有向线段的斜率大小大致在区间[-1,1]中,因此将斜率区间负无穷大到正无穷大划分为22个区间,区间分别为[-∞,-1.0]、[-1.0,-0.9]、[-0.9,-0.8]、…、[0.8,0.9]、[0.9,1.0]、[1.0,+∞]。对应划分的22个区间,构造统计分布数组:

(5)

其中:h为行数;l为列数。其中第一行放置各区间的右边界,第二行放置落在各区间的统计数量。待所有有向线段斜率统计完毕后,可得到数量最多区间sm,并结合式(5)进而求得斜率阈值区间[f1,f2]如下所示:

(6)

其中:lm为斜率统计数量最多的sm对应的列数。考虑到待配准图像相对于参考图像可能有稍微的尺度变化和旋转变换,为保证不会剔除正确匹配点,将斜率阈值区间左右都向外扩展0.1。

按照得到的斜率阈值空间剔除不符合约束的匹配点,并结合式(4)和式(6),可得到n个匹配点中符合斜率阈值空间的匹配点索引值集合![]()

(7)

为之后表示的统一,假设得到的![]() 有p个匹配点,其可以定义为:

有p个匹配点,其可以定义为:

(8)

有向线段长度约束针对的是经斜率阈值区间剔除后的dp,有向线段长度用两点间的欧式距离表示,为方便运算,之后判断误匹配点即用该欧式距离的平方表示:

(9)

式中:j∈(1,p)。由式(9)可得长度约束如下:

(10)

其中:![]() 为p个匹配点经长度约束后其中得到匹配点的索引值;

为p个匹配点经长度约束后其中得到匹配点的索引值;![]() 为所有匹配点欧式距离平方的平均值;Td为长度约束控制值。Td与参与图像拼接的图像尺寸有关,试验得知当图像像素是百万级时,Td=4较好,图像像素值小于百万像素时Td=1.5较好。本文图像尺寸为2 448×3 264,故选择的Td=4。

为所有匹配点欧式距离平方的平均值;Td为长度约束控制值。Td与参与图像拼接的图像尺寸有关,试验得知当图像像素是百万级时,Td=4较好,图像像素值小于百万像素时Td=1.5较好。本文图像尺寸为2 448×3 264,故选择的Td=4。

经过有向线段固有属性斜率和长度约束,得到k对新匹配点对,结合式(7)、式(8)和式(10),最终得到是正确匹配点在原始坐标集合中的索引值dk:

(11)

1.3 图像内特征点有向线段模型的构建

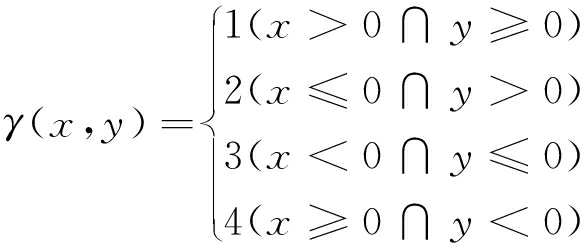

经过有向线段固有属性斜率和长度约束,得到新匹配点坐标![]() 但是得到的新匹配点仍存在一部分的误匹配点,因此还需要对新得到的匹配点再次剔除误匹配点。

但是得到的新匹配点仍存在一部分的误匹配点,因此还需要对新得到的匹配点再次剔除误匹配点。

按照上节得到的新匹配点,其对应的坐标集合表示为:

(12)

(13)

式中:i∈(1,k)。

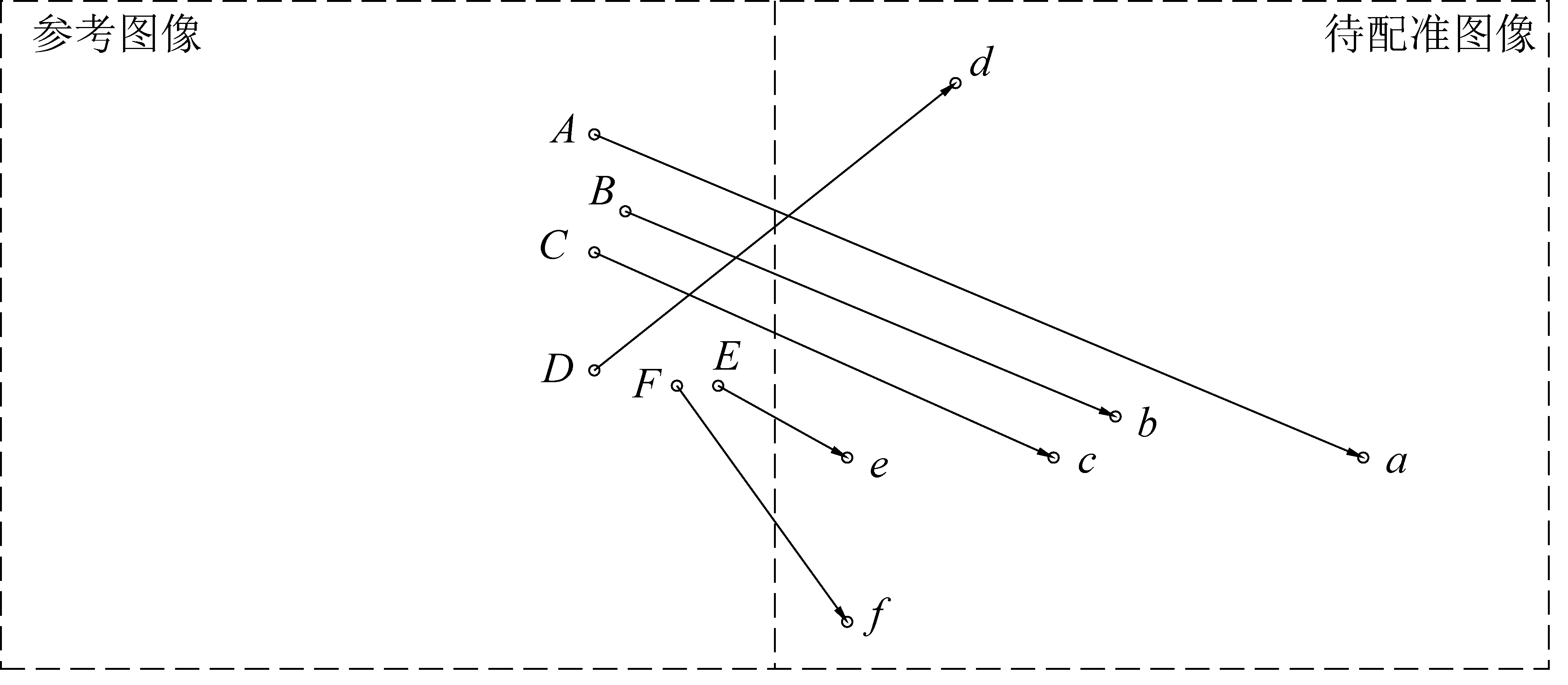

图像内特征点有向线段模型如图2所示,其中[B,b]、[C,c]、[G,g]、[H,h]、[I,i]是经过有向线段固有属性斜率和长度约束得到的匹配点,其中[B,b]、[C,c]、[I,i]为正确匹配点,[G,g]、[H,h]为误匹配点。

以图2为例,图像内特征点有向线段剔除误匹配点的思路表现为:建立如图3以特征点为原点的方向坐标系,其中<P,P1>、<P,P2>、<P,P3>、<P,P4>分别代表一个方向和坐标系4个象限一一对应,以此来确定有向线段的方向标签;可以得出有向线段<BG,bg>、<CH,ch>方向是不同的,<BC,bc>、<BH,bh>、<BI,bi>方向是相同的;在已知[B,b]、[C,c]为正确匹配点的前提下,可知[G,g]、[H,h]为误匹配点;但在实际过程中不知道正确匹配点和误匹配点到底是哪些,因此要构造一个概率统计模型,统计每个匹配点被定义为误匹配点的数量及对应概率,以此来剔除误匹配点。

图3 方向坐标系

Fig.3 Directional coordinate system

以式(12)和式(13)构建图像内特征点有向线段模型:

(14)

式中:i∈(1,k-1),j∈(i+1,k)。

Mb1(i,j)和Mb2(i,j)是参考图像和待配准图像对应的匹配线段,其中![]() 和

和![]() 分别代表有向线段的坐标值,表示以图像内第i个特征点为起点,第j个特征点为终点的有向线段。计算可得到每张图像内的有向线段模型中有

分别代表有向线段的坐标值,表示以图像内第i个特征点为起点,第j个特征点为终点的有向线段。计算可得到每张图像内的有向线段模型中有![]() 个元素,且两者按照索引值一一对应,则其按照索引值可表示为:

个元素,且两者按照索引值一一对应,则其按照索引值可表示为:

(15)

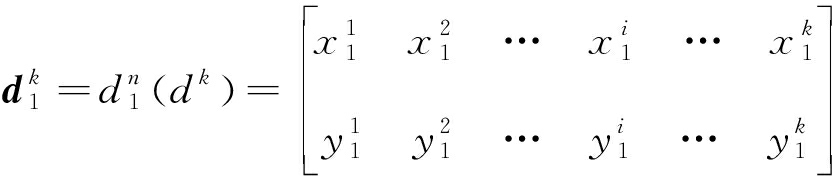

式中:![]()

通过确定![]() 和

和![]() 处于方向坐标系的那个象限,来给有向线段赋上标签γ:

处于方向坐标系的那个象限,来给有向线段赋上标签γ:

(16)

以此标签来作为有向线段的匹配条件,综合式(15)和式(16)可得有向线段模型为

(17)

式中:![]()

若![]() 则表示

则表示![]() 和

和![]() 是一对正确匹配线段,即

是一对正确匹配线段,即![]() 和

和![]() 是一对正确匹配线段,其对应的两条线段的端点

是一对正确匹配线段,其对应的两条线段的端点![]() 和

和![]() 都为正确匹配点,反之则都是误匹配点。

都为正确匹配点,反之则都是误匹配点。

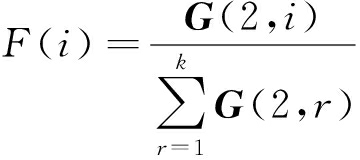

由于误匹配点占总匹配点少数,且正确匹配点事先并不知道,因此通过统计每对匹配点被划分为误匹配点的次数来判断该匹配点是否为误匹配点。则建立数量统计矩阵G∈R2×k:

(18)

式中:i∈(1,k)。

G的计算过程如下:

1) 首先初始化G矩阵第2行全部为0。

2) 同索引值遍历Mb1(t)和Mb2(t)。①若![]() 和

和![]() 为误匹配线段,即

为误匹配线段,即![]() 和

和![]() 为误匹配线段;②则说明其对应的

为误匹配线段;②则说明其对应的![]() 和

和![]() 都为误匹配点;③即令数量统计矩阵中G(2,i)=G(2,i)+1,G(2,j)=G(2,j)+1。

都为误匹配点;③即令数量统计矩阵中G(2,i)=G(2,i)+1,G(2,j)=G(2,j)+1。

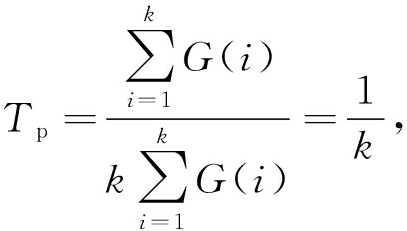

3) 输出数量统计矩阵G。数量统计矩阵G中放置的是每对匹配点被判别为误匹配点的次数,由此得到每对匹配点对应的概率统计模型:

(19)

式中:i∈(1,k)。

对于式(19)的概率统计模型,设定阈值Tp,阈值的确定见第3.2节式(25)。如果某对匹配点的概率大于该阈值,则说明其为误匹配点,则就可以得到l个在dk中的正确匹配点索引值。

(20)

式中:i∈(1,k)。

由式(11)和式(20),则就可以得到l个在原始坐标集合中的正确匹配点索引值dl。

(21)

结合式(1)、式(2)和式(21),可以得到正确匹配点的坐标值为:

(22)

2 图像配准及融合

得到参考图像I1和待配准图像I2的精确匹配点后,尽管剔除了误匹配点,但是总体用于拼接图像的匹配点对变少了,最后的拼接图像极易出现投影失真的问题。为减少待配准图像的投影失真,进而得到观感更好的煤矿井下巷道的图像拼接结果,采取AANAP算法解决图像拼接过程的投影失真问题。

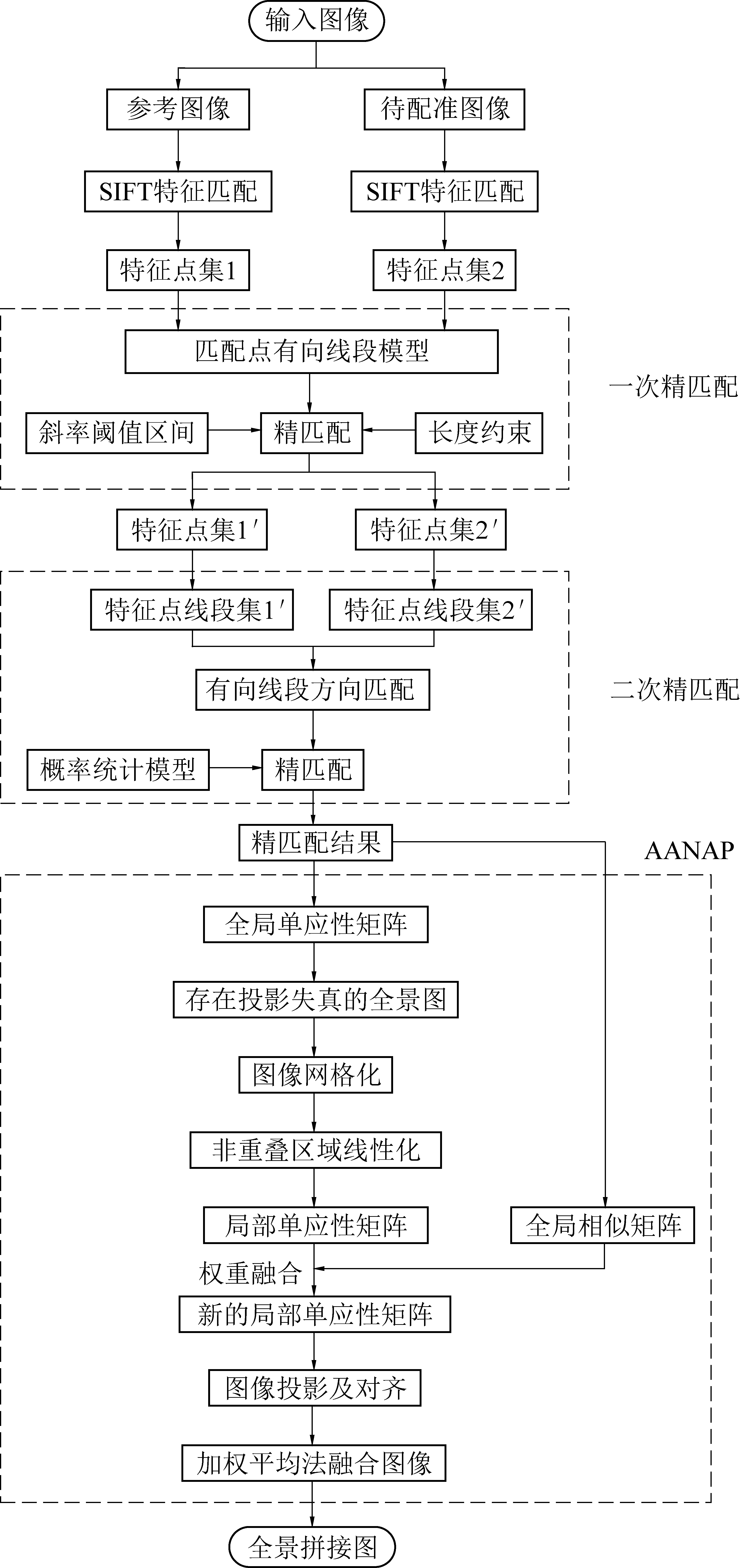

完整的图像拼接流程则如图4所示。其中在得到图像的粗匹配点后,建立有向线段模型对图像匹配点进行两次精匹配,尽可能剔除其中的误匹配点,使之后的图像变换尽可能准确;然后利用AANAP算法,减少因匹配点对减少而导致的投影失真,最后对全景拼接图加权融合得到观感更好的拼接图。

图4 图像拼接流程图

Fig.4 Image stitching flow chart

AANAP算法具体步骤如下:首先求得全局单应性矩阵,得到对应的全景拼接图;再对该图像划分网格,利用Moving DLT算法,对每一个网格赋予高斯权重,获得每个网格的局部单应性矩阵;为了避免非重叠区域图像的投影失真,对于非重叠区域内的局部单应性矩阵使用已知的锚点和矩阵的泰勒级数对其实行线性化;然后将全局相似矩阵和局部单应性矩阵(包括已线性化的)按照一定的权重融合起来,得到两个图像新的局部单应性矩阵;最终以局部单应性矩阵投影并对齐图像,达到图像配准的目的。

图像融合算法[27]采用经典的加权平均法来融合图像,消除图像间的亮度和纹理差异。

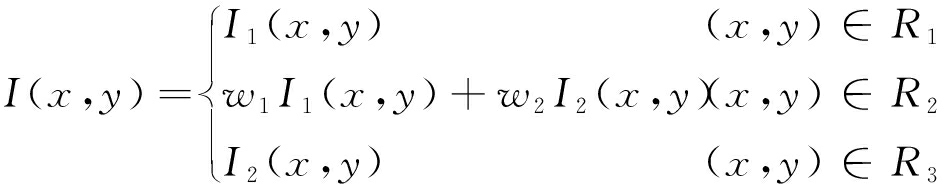

(23)

式中:I1和I2为参考图像和待配准图像;R1为图像I1的非重合区域;R2为图像I1和图像I2的重合区域;R3为图像I2的非重合区域;w1和w2为加权值,且w1+w2=1,w1,w1∈(0,1)。

3 试验结果及分析

针对该误匹配点剔除方法,采用了煤矿井下巷道图像(图5)进行试验,并将该误匹配算法和RANSAC算法进行比较,并采用AANAP算法对其匹配性能和拼接精度进行了定量评价和分析。

图5为煤矿巷道具有一定视差的2张图像,其中左边为参考图像,右边为待配准图像,图像尺寸均为2 448×3 264,为加快运算速度,减少图像噪声的影响,图像输入为原来的四分之一,即1 224×1 632。算法是在台式计算机上运行的,其运行环境:CPU为Intel(R) Core(TM)i5-7400 /2.20 GHz;内存为8 GB;操作系统为64位Windows10操作系统。

图5 煤矿井下巷道图像

Fig.5 Images of underground tunnel in coal mine

3.1 评价指标

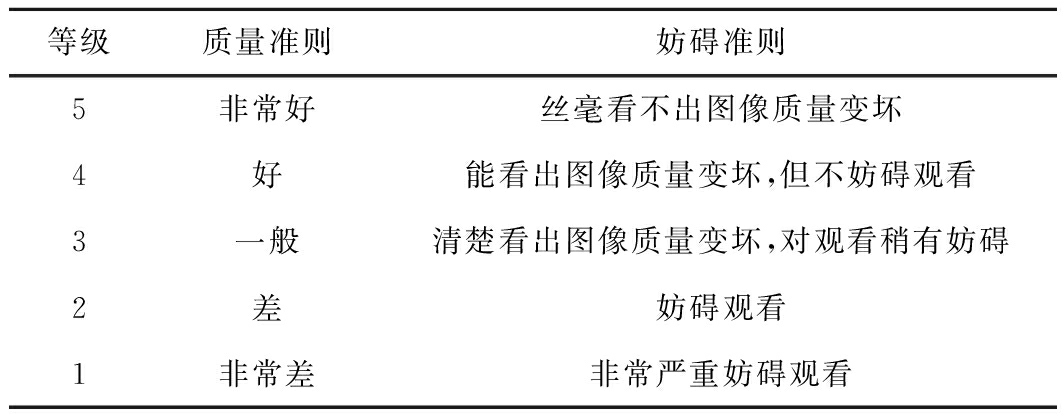

1)主观评价。主观评价是以观测者的主观感受作为图像配准的质量体现。采用的主观评价准则为国际无线电咨询委员会制订的CCIR500-1主观评价标准[28],见表1。

表1 CCIR500-1主观评价5级标准

Table 1 CCIR500-1 subjective evaluation level 5 standard

等级质量准则妨碍准则5非常好丝毫看不出图像质量变坏4好能看出图像质量变坏,但不妨碍观看3一般清楚看出图像质量变坏,对观看稍有妨碍2差妨碍观看1非常差非常严重妨碍观看

2)客观评价。运行速度:使用算法的运行时间来判断算法的实时性效果。

均方根误差RMSE(Root Mean Square Error):参考图像和待配准图像两者经过图像配准后之间的距离度量,RMSE值越小,说明配准后两者距离越小,配准精度越高,图像配准效果越好。反之,则图像配准效果就越差。RMSE计算公式如下:

(24)

式中:K为最终匹配点对的数目;(xi,yi)为参考图像的坐标;f1为参考图像的变换模型;![]() 为待配准图像的特征点坐标;f2为待配准图像的图像变换模型。

为待配准图像的特征点坐标;f2为待配准图像的图像变换模型。

3.2 特征匹配点精匹配试验过程

特征匹配点精匹配对于后续图像配准过程中的图像变换模型起着至关重要的作用,在进行精匹配之前,首先需要对得到的原始特征点进行匹配,得到粗匹配点对(图6),然后在此基础上对其进行精匹配试验,并对比最后的拼接图。

图6 粗匹配点匹配图

Fig.6 Coarse matching point matching diagram

常用的剔除误匹配RANSAC算法的核心是:通过多次迭代剔除外点,找到内点数量最多对应的最优变换模型。其中最小点对数目和迭代值需要人为经验选定,若特征点数目较多,将导致算法时间成本较高。同时煤矿巷道的图像光照不均衡,而特征描述方法是以特征点邻域来设定的,致使有些匹配点的特征点特征描述子相似,但其实两者位置相差甚远。图7为使用RANSAC算法后得到的特征点匹配图和全景拼接图,可以明显看到拼接图中缺失了一部分,即得到的图像变换模型出现了较大的偏差,图8是RANSAC精匹配后仍存在的误匹配局部放大图,其中用红圆圈和红矩形框起来的是一对误匹配点。

图7 RANSAC精匹配结果

Fig.7 RANSAC fine matching results

为解决RANSAC算法的缺陷,剔除如图8所示的误匹配点。以1.1节中提出的特征匹配点的3条规律,可以对得到的粗匹配点(图6)进行2次精匹配,以期剔除误匹配点,进而得到质量更好的匹配点。一次精匹配主要内容(图1):以每对匹配点构成有向线段的斜率阈值区间和长度约束来剔除误匹配点。

图8 RANSAC误匹配局部放大图

Fig.8 RANSAC mismatches schematic diagram

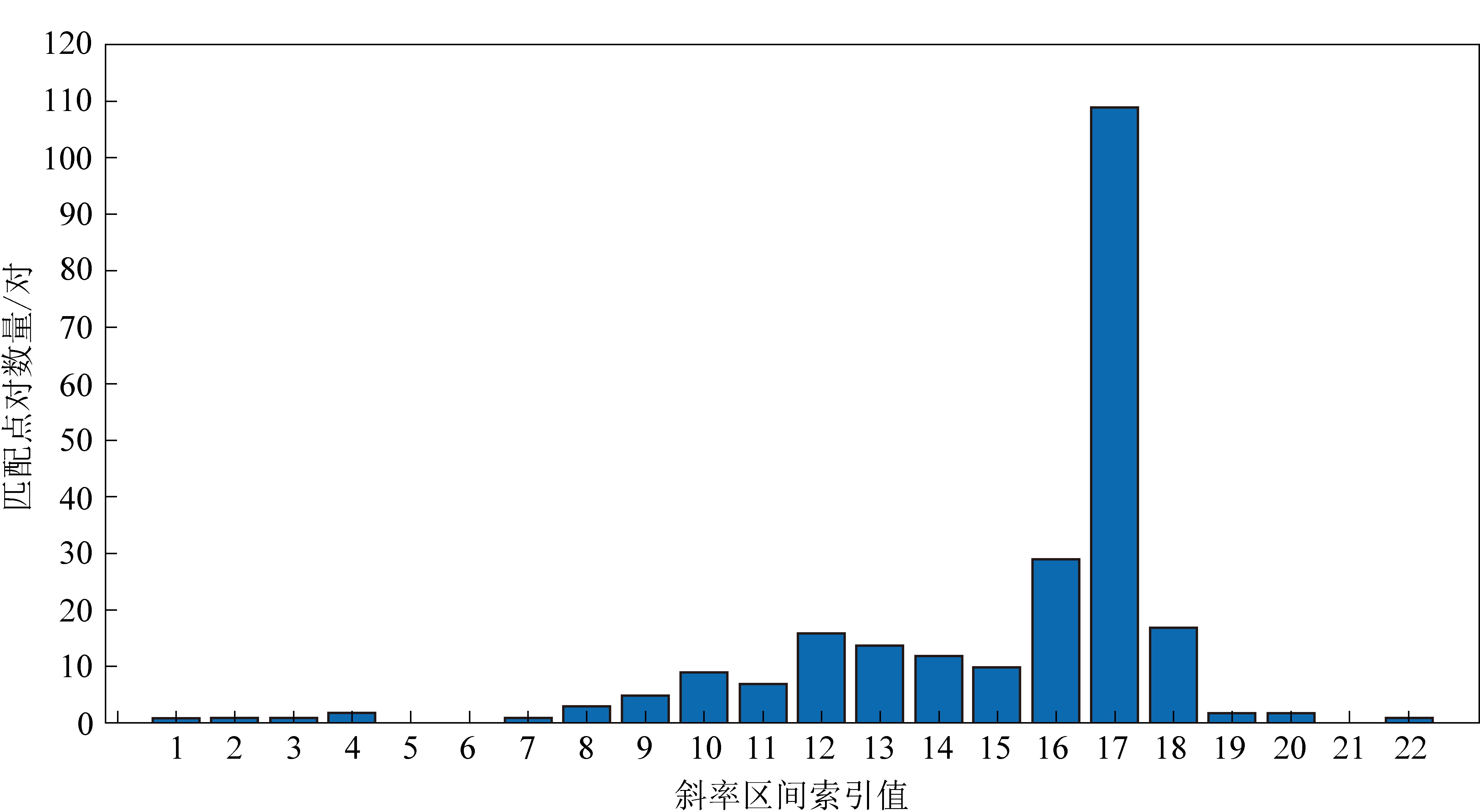

图9 斜率区间统计分布

Fig.9 Statistical distribution of slope interval

图9为斜率区间统计分布图。其对应的区间见表2。由图9和表2得知,横轴上17对应的区间[0.5,0.6]匹配点的数量最多,即所有匹配点构成的有向线段斜率落在此区间内的最多,结合式(5)和式(6)可以得到斜率阈值区间为[0.4,0.7]。以此区间对粗匹配点进行误匹配点剔除,匹配结果如图10所示。

表2 斜率区间索引值对应区间

Table 2 Corresponding interval of index

value of slope interval

索引值12……2122对应区间[-∞,-1.0][-1.0,-0.9]……[0.9,1.0][1.0,+∞]

图10 斜率阈值区间约束匹配图

Fig.10 Slope threshold interval constraint matching diagram

从图10中可以明显看到有一根线长度较长,且其匹配点分别处于重叠区域和非重叠区域内,这显然是错误的。因此在斜率阈值空间的基础上附以长度约束将不符合约束的匹配点剔除,得到一次精匹配结果如图11所示,其中图11a为特征匹配点图,图11b为一次精匹配得到的全景拼接图。

图11 一次精匹配结果

Fig.11 Results after first fine match

从图11b可以得知,尽管图像无较大投影失真和重影,但是待配准图像出现了不规则变形,使得图像观感和质量较差。说明一次精匹配后得到新的匹配点对中仍存在部分误匹配点,且对最后的全景拼接图有着很大的影响。因此构建图像内特征点有向线段对匹配点进行二次精匹配。由式(20)—式(22)可知,二次精匹配的效果和阈值Tp的选择息息相关。由于不同图像其可能对应的值各不相同,因此不能确定成某一固定数值,即选定所有匹配点概率的平均值作为阈值:

其中i∈(1,k)

其中i∈(1,k)

(25)

将式(25)代入式(22),可以得到最终的正确匹配点坐标值。图12是经过一次精匹配和二次精匹配后得到的结果,其中图12a为特征匹配点图,相较于RANSAC算法得到的匹配图来说,匹配点的数目较少;图12b为得到的全景拼接图,相较于RANSAC算法下的全景拼接图,图像无缺失,无不规则变形,即拼接图的观感自然度更好;如图13所示,RANSAC在相应黄方框中的误匹配,该算法中已经剔除,足可见本文算法剔除误匹配的能力更强。

图12 二次精匹配结果

Fig.12 Results after second fine matching

图13 相较于RANSAC误匹配的匹配位置

Fig.13 Matching position compared to RANSAC mismatch

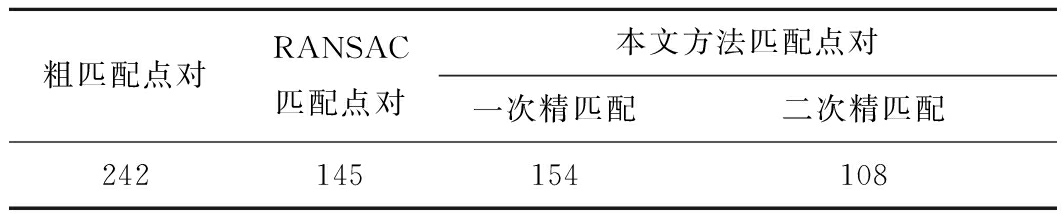

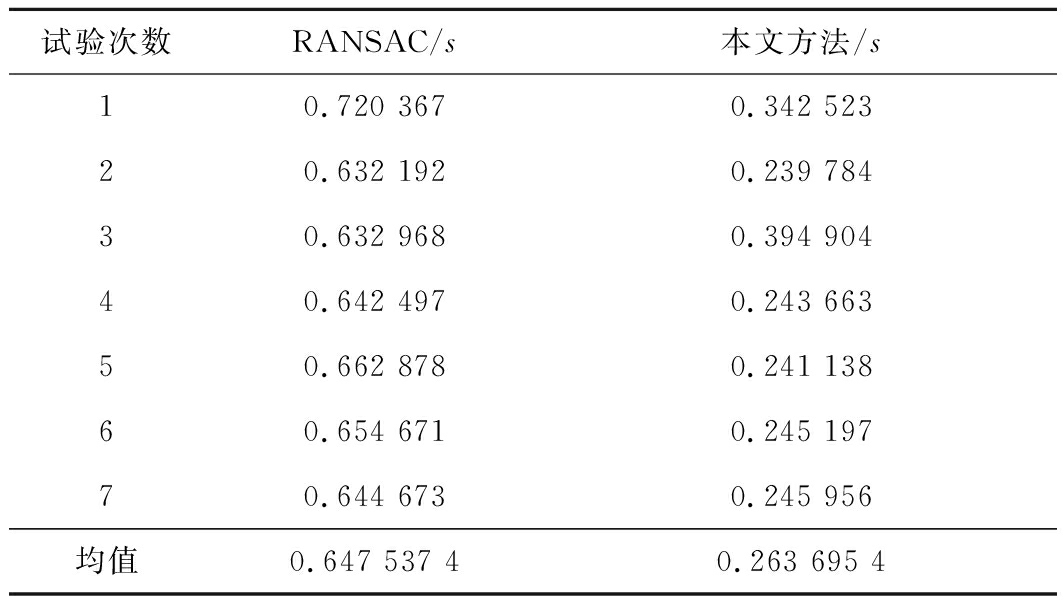

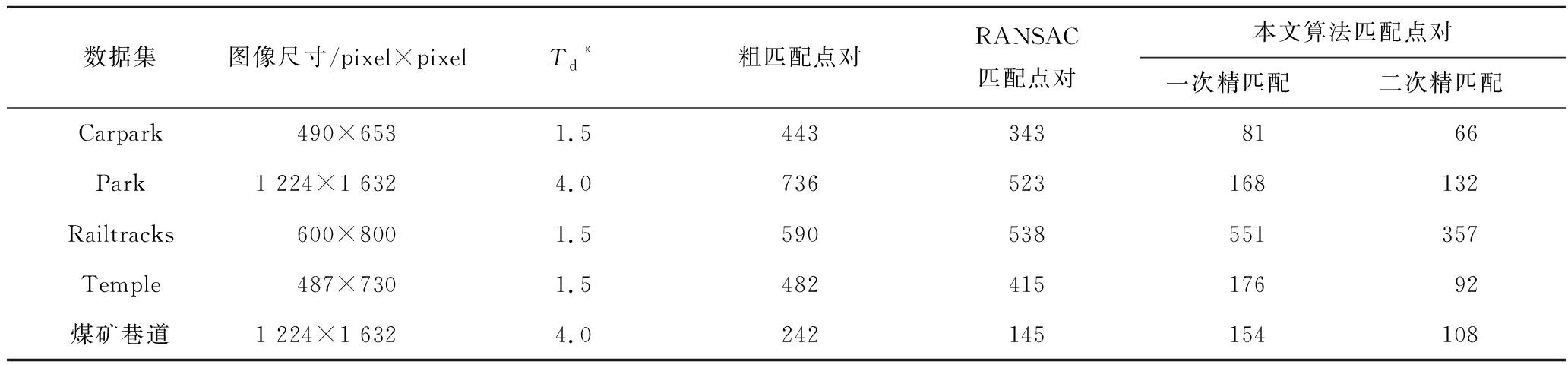

表3表示的是使用本文方法和RANSAC得到的正确匹配点对数量,同时对两者进行了多次试验,得到算法耗费时间见表4。

表3 特征匹配点对数量

Table 3 Number of feature matching point pairs

粗匹配点对RANSAC匹配点对本文方法匹配点对一次精匹配二次精匹配242145154108

表4 算法耗费时间

Table 4 Time consumed by the algorithm

试验次数RANSAC/s本文方法/s10.720 3670.342 52320.632 1920.239 78430.632 9680.394 90440.642 4970.243 66350.662 8780.241 13860.654 6710.245 19770.644 6730.245 956均值0.647 537 40.263 695 4

从表3可得在图像相同的情况下,RANSAC算法得到的匹配点较多,但本文方法得到的匹配点的数目较少。表4表示的是使用RANSAC算法和本文方法剔除误匹配进行的7次试验以及其剔除误匹配耗费的时间。由于程序运行时间受计算机硬件软件的影响,因此运行多次,去除最高值和最低值,求剩下时间的均值;可以得到本文方法运算时间快于RANSAC算法,实时性更好。

综上所述,该方法得到的匹配点准确度和质量较高,实时性较好,在匹配点数目较少的情况下,所得到的全景拼接图质量和自然度更好。

3.3 图像拼接对比试验

综合上节结论可以得出,本文方法剔除误匹配能力更强,运行时间更快,得到的匹配点质量更好,在煤矿巷道图像拼接的效果较RANSAC更好。为判断本文方法的普适性能,接下来在4组公共数据集[16](Carpark、Park、Railtrack、Temple)上进行试验。

图14、15、16、17是RANSAC算法和本文算法分别在4组公共数据集上的处理效果:其中各图中a图和b图是2种方法得到的匹配点图,可以看出本文方法得到的匹配点数目比RANSAC算法少很多;c图和d图则是在2种方法精匹配完后,辅以AANAP算法后得到4组数据集的全景拼接图,综合精匹配结果来看,本文方法在得到匹配点较少的情况下,仍能得到和RANSAC算法相同的结果,可以得出该方法具有一定的稳定性和普适性。

图14 Carpark数据集图像拼接结果

Fig.14 Image stitching of the Carpark dataset

表5所示的是4组数据集和煤矿巷道图像在2种算法下的匹配点数目对比,可以看出本文方法得到的匹配点对数目比RANSAC算法得到的要少很多,但是综合之前得到的全景拼接图效果来看,本文方法并不逊色匹配点较多的RANSAC算法,相反,在煤矿巷道的全景拼接图(图7和图12)中,本文算法得到的效果更好,更具观感自然度。

表5 不同数据集匹配点数量对比结果

Table 5 Comparison results of number of matching points in different data sets

数据集图像尺寸/pixel×pixelTd*粗匹配点对RANSAC匹配点对本文算法匹配点对一次精匹配二次精匹配Carpark490×6531.54433438166Park1 224×1 6324.0736523168132Railtracks600×8001.5590538551357Temple487×7301.548241517692煤矿巷道1 224×1 6324.0242145154108

*注:Td的选择见1.2节式(10)。

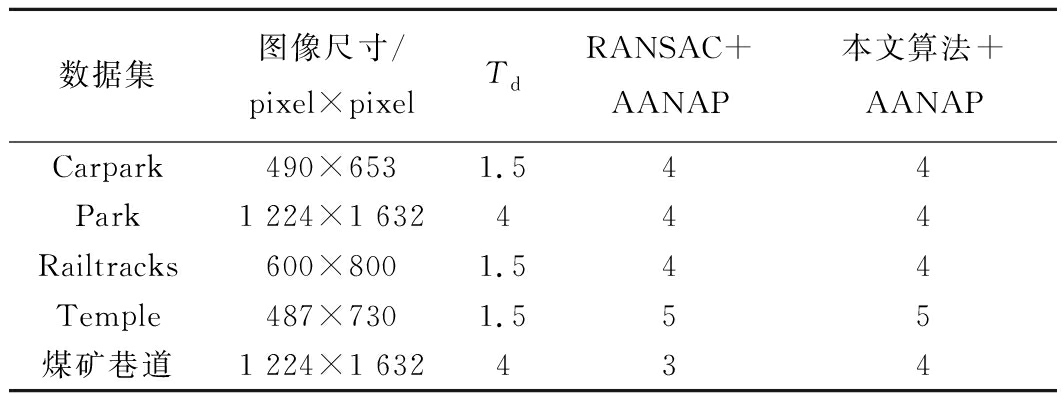

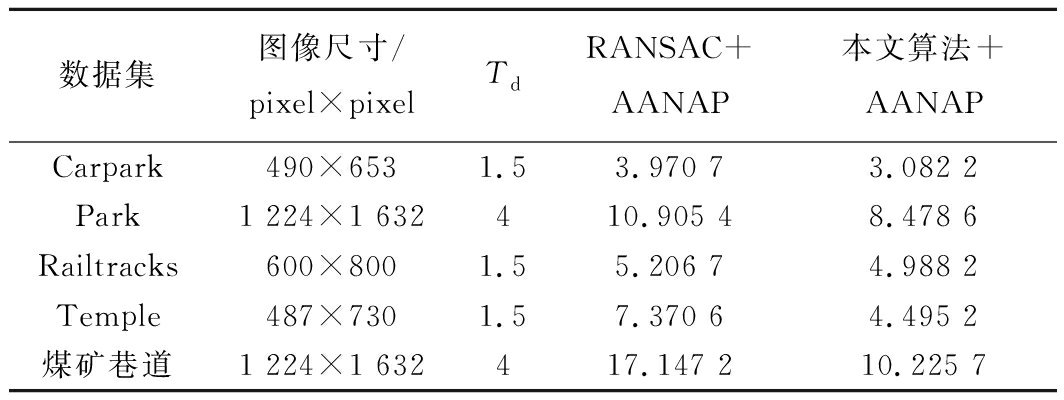

按照3.1节的评价指标,对得到这五组全景拼接图进行主观评价和客观评价,得到的结果如表6所示。可以看出本文方法和RANSAC算法在公共数据集上主观效果一样,说明本文算法具有一定的普适性,而在煤矿巷道复杂场景的数据集中,本文方法则更适用,得到结果的效果更好。表7表示的是图像拼接效果的定量评价指标RMSE,从中得知本文方法的RMSE值普遍要比RANSAC的要低,说明了本文方法的图像配准精度更高,得到的图像效果也更佳。

图15 Park数据集图像拼接结果

Fig.15 Image stitching of Park dataset

图16 Railtracks数据集图像拼接结果

Fig.16 Image stitching of Railtracks dataset

图17 Temple数据集图像拼接结果

Fig.17 Image stitching of Temple dataset

表6 不同算法在不同数据集上的主观评价结果

Table 6 Subjective evaluation results of different

algorithms on different data sets

数据集图像尺寸/pixel×pixelTdRANSAC+AANAP本文算法+AANAPCarpark490×6531.544Park1 224×1 632444Railtracks600×8001.544Temple487×7301.555煤矿巷道1 224×1 632434

注:Td的选择见1.2节式(10)。

表7 不同算法在不同数据集上的RMSE值

Table 7 RMSE values of different algorithms on

different data sets

数据集图像尺寸/pixel×pixelTdRANSAC+AANAP本文算法+AANAPCarpark490×6531.53.970 73.082 2Park1 224×1 632410.905 48.478 6Railtracks600×8001.55.206 74.988 2Temple487×7301.57.370 64.495 2煤矿巷道1 224×1 632417.147 210.225 7

注:Td的选择见1.2节式(10)。

4 结 论

1)提出了一种基于有向线段误匹配剔除的煤矿巷道图像拼接方法,并与RANSAC算法拼接结果进行对比。首先利用SIFT算法提取参考图像和待配准图像的特征点,并使用欧式距离来匹配特征点,得到粗匹配点;然后构建匹配点和特征点的有向线段模型,利用斜率阈值区间、长度约束和概率统计模型对粗匹配进行两次精匹配;最后使用AANAP算法实现图像配准和加权融合过程,得到观感自然度更好的全景拼接图。

2)试验结果表明,在煤矿巷道图像拼接中,依靠较少的匹配点实现了比RANSAC算法更好的结果,表明本文方法更适用于煤矿巷道复杂场景的图像拼接;而在公共数据集中,本文方法和RANSAC算法得到的图像拼接结果大同小异,效果相似,更说明了该方法有一定的普适性。

3)该方法从特征点最基本性质出发,避免了煤矿巷道图像场景特殊性的限制,达到了有效剔除误匹配点的效果,得到更为精确的图像变换模型,同时运行时间更快,具有更高的匹配准确率和实时性。

由于本文所提方法使用了斜率阈值区间作为剔除误匹配的基础,因此对于图像之间存在大角度的旋转变换和大尺度的缩放变换的处理效果不是很理想,同时由于AANAP算法自身缺陷,运行时间较长,导致图像拼接整体算法的实时性较差。下一步的研究重点是在图像预处理阶段消除图像的大角度旋转和大尺度的缩放,以及改进AANAP算法使得图像拼接过程更快,并进一步优化提升本文算法鲁棒性和稳定性。

[1] 杨健健,张 强,吴 淼,等. 巷道智能化掘进的自主感知及调控技术研究进展[J]. 煤炭学报,2020,45(6):2045-2055.

YANG Jianjian,ZHANG Qiang,WU Miao,et al. Research progress of autonomous perception and control technology for intelligent heading[J]. Journal of China Coal Society,2020,45(6):2045-2055.

[2] 王国法,杜毅博,任怀伟,等. 智能化煤矿顶层设计研究与实践[J]. 煤炭学报,2020,45(6):1909-1924.

WANG Guofa,DU Yibo,REN Huaiwei,et al. Top level design and practice of smart coal mines[J]. Journal of China Coal Society,2020,45(6):1909-1924.

[3] 王国法,张德生. 煤炭智能化综采技术创新实践与发展展望[J]. 中国矿业大学学报,2018,47(3):459-467.

WANG Guofa,ZHANG Desheng. Innovation practice and development prospect of intelligent fully mechanized technology for coal mining[J]. Journal of China University of Mining & Technology,2018,47(3):459-467.

[4] 陈先中,刘荣杰,张 森,等. 煤矿地下毫米波雷达点云成像与环境地图导航研究进展[J]. 煤炭学报,2020,45(6):2182-2192.

CHEN Xianzhong,LIU Rongjie,ZHANG Sen,et al. Development of millimeter wave radar imaging and SLAM in underground coal mine environment[J]. Journal of China Coal Society,2020,45(6):2182-2192.

[5] 刘万里,张学亮,王世博. 采煤工作面煤层三维模型构建及动态修正技术[J]. 煤炭学报,2020,45(6):1973-1983.

LIU Wanli,ZHANG Xueliang,WANG Shibo. Modeling and dynamic correction technology of 3D coal seam model for coal-mining face[J]. Journal of China Coal Society,2020,45(6):1973-1983.

[6] 孙继平,贾 倪. 矿井视频图像中人员目标匹配与跟踪方法[J]. 中国矿业大学学报,2015,44(3):540-548.

SUN Jiping,JIA Ni. Human target matching and tracking method in coal mine video[J]. Journal of China University of Mining & Technology,2015,44(3):540-548.

[7] BAI Z,LI Y,CHEN X,et al. Real-time video stitching for mine surveillance using a hybrid image registration method[J]. Electronics,2020,9(9):1336.

[8] XIE X,XU Y,Liu Q,et al. A study on fast SIFT image mosaic algorithm based on compressed sensing and wavelet transform[J]. Journal of Ambient Intelligence & Humanized Computing,2015,6(6):835-843.

[9] 杨家俊,丁祝顺,陈 昕. 图像配准关键技术综述[J]. 导航与控制,2020,19(1):77-84.

YANG Jiajun,DING Zhushun,CHEN Xin. Review of key technologies of image registration[J]. Navigation and Control,2020,19(1):77-84.

[10] 赵海峰,陆 明,卜令斌,等. 基于特征点Rényi互信息的医学图像配准[J]. 计算机学报,2015,38(6):1212-1221.

ZHAO Haifeng,LU Ming,BU Lingbin,et al. Medical image registration based on feature points and Rényi mutual information[J]. Chinese Journal of Computers,2015,38(6):1212-1221.

[11] 韩 敏,闫 阔,秦国帅. 基于改进KAZE的无人机航拍图像拼接算法[J]. 自动化学报,2019,45(2):305-314.

HAN Min,YAN Kuo,QIN Guoshuai. A mosaic algorithm for UAV aerial image with improved KAZE[J]. Acta Automatica Sinica,2019,45(2):305-314.

[12] 柳长安,艾 壮,赵丽娟. 基于网格运动统计的自适应图像特征匹配算法[J]. 华中科技大学学报(自然科学版),2020,48(1):37-40,54.

LIU Changan,AI Zhuang,ZHAO Lijuan. Self-adaptive image feature matching algorithm based on grid motion statistics[J]. Journal of Huazhong University of Science and Technology(Natural Science Edition),2020,48(1):37-40,54.

[13] RUBLEE E,RABAUD V,KONOLIGE K,et al. ORB:An efficient alternative to SIFT or SURF[C]//International Conference on Computer Vision(ICCV),2011:2564-2571.

[14] BIAN J W,LIN W Y,MATSUSHITA Y,et al. GMS:Grid-Based Motion Statistics for Fast,Ultra-Robust Feature Correspondence[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2017:2828-2837.

[15] SUN D,ZHANG S,WANG Y. Improved feature point extraction and mismatch eliminating algorithm[J]. Systems Science & Control Engineering,2020,8(1):11-21.

[16] 袁修孝,袁 巍,陈时雨. 基于图论的遥感影像误匹配点自动探测方法[J]. 武汉大学学报(信息科学版),2018,43(12):1854-1860.

YUAN Xiuxiao,YUAN Wei,CHEN Shiyu. An automatic detection method of mismatching points in remote sensing images based on graph theory[J]. Geomatics and Information Science of Wuhan University,2018,43(12):1854-1860.

[17] 丁亚洲,冯发杰,吏军平,等. 点线特征约束的LiDAR点云与航空影像自动配准[J]. 中国矿业大学学报,2020,49(6):1207-1214.

DING Yazhou,FENG Fajie,LI Junping,et al. Automatic registration of airborne LiDAR data and aerial images constrained by point and line features[J]. Journal of China University of Mining & Technology,2020,49(6):1207-1214.

[18] 董 强,刘晶红,王 超,等. 基于改进BRISK的图像拼接算法[J]. 电子与信息学报,2017,39(2):444-450.

DONG Qiang,LIU Jinghong,WANG Chao,et al. Image mosaic algorithm based on improved BRISK[J]. Journal of Electronics and Information Technology,2017,39(2):444-450.

[19] 刘李漫,谭龙雨,刘 佳. 基于多种几何约束的图像误匹配剔除算法[J]. 中南民族大学学报(自然科学版),2020,39(1):91-97.

LIU Liman,TAN Longyu,LIU Jia. A mismatch removing method based on multiple geometric constraints[J]. Journal of South-Central University for Nationalities(Natural Science Edition),2020,39(1):91-97.

[20] WU G L,CHANG H H. An accurate feature point matching algorithm for automatic remote sensing image registration[C]//International Conference on Digital Image Computing:Techniques and Applications (DICTA),2017:1-8.

[21] LEE K Y,SIM J Y. Warping residual based image stitching for large parallax[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),2020:8195-8203.

[22] GAO J,KIM S,BROWN M S. Constructing image panoramas using dual-homography warping[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2011:49-56.

[23] ZARAGOZA J,CHIN T,BROWN M S,et al. As-projective-as-possible image stitching with moving DLT[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2013:2339-2346.

[24] LIN C C,PANKANTI S U,RAMAMURTHY K N,et al. Adaptive as-natural-as-possible image stitching[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2015:1155-1163.

[25] CHANG C H,SATO Y.,CHUANG Y Y. Shape-preserving half-projective warps for image stitching[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2014:3254-3261.

[26] LOWE D G. Distinctive Image features from scale-invariant ke-ypoints[J]. International Journal of Computer Vision,2004,60(2):91-110.

[27] 罗永涛,王 艳,张红民. 结合最佳缝合线和改进渐入渐出法的图像拼接算法[J]. 红外技术,2018,40(4):382-387.

LUO Yongtao,WANG Yan,ZHANG Hongmin. Image stitching algorithm combining the best stitching line and the improved fade-in method[J]. Infrared Technology,2018,40(4):382-387.

[28] 万国挺,王俊平,李 锦,等. 图像拼接质量评价方法[J]. 通信学报,2013,34(8):76-81.

WAN Guoting,WANG Junping,LI Jin,et al. Method for quality assessment of image mosaic[J]. Journal on Communications,2013,34(8):76-81.